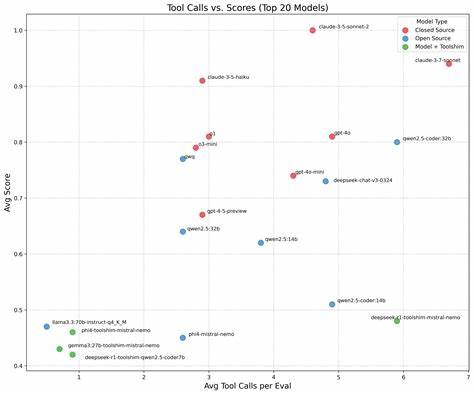

随着人工智能技术的飞速发展,大型语言模型(LLM)正被广泛应用于智能代理系统中,这些系统能够通过调用各种工具大幅拓展语言模型的功能,实现诸如数据查询、运算辅助、任务自动化等多种复杂操作。然而,越来越多的研究与实践表明,工具调用不仅代价昂贵,而且存在明显的次数限制,这对智能代理的设计和应用提出了极大挑战。理解这一点,对于开发高效可靠的智能代理系统尤为关键。大型语言模型本质上是复杂的文本生成引擎,它们通过生成特定格式的文本来实现工具调用操作。这种机制本质上是通过语言模型先生成关于工具调用的指令文本,随后外部系统解析执行并将结果反馈回模型的上下文中。例如,一个简单的加法工具调用,当用户询问"15加27等于多少"时,模型会生成一段特定格式的文本用于调用加法工具,工具执行完毕后再将结果作为新的消息输入模型,模型再基于该结果向用户输出最终答案。

虽然看似流程简洁,但每一次工具调用都涉及生成额外的文本令牌,耗费大量的计算资源和上下文窗口空间。这种上下文窗口空间的消耗尤其关键,因为每次工具调用的输入输出都必须保存在上下文中,使得模型运算的上下文容量快速被占满。对于简单的工具调用,如单次加法,消耗尚可接受,但一旦遇到大量调用场景,比如批量数据处理,问题便显现出来。以需要对上千个用户ID进行信息查询的应用为例,若采用逐条调用工具的方式,模型不仅需要为每条调用生成对应的文本令牌,还需要储存并处理返回结果。这将导致上下文窗口迅速达到极限,模型的响应时间显著延长,同时大规模调用带来的计算开销也使得整体系统效率骤降。因此,工具调用不仅成本高昂,更存在使用次数的天然瓶颈。

对于工程师和系统设计者来说,这种工具调用的昂贵与有限性一方面要求更加谨慎地设计代理的调用逻辑,另一方面也呼唤更高效的工具设计策略。设计灵活且功能强大的工具成为关键,这样可以在尽可能少的调用次数中完成更多任务。另一方面,将复杂逻辑封装在单个工具内部,减少频繁调用,也成为应对工具调用成本的有效手段。例如,结合编程能力赋予代理生成并执行代码的功能,从而利用代码执行环境批量处理数据,避免让模型为每个细节调用工具,大幅减少交互次数和上下文占用。设计时还可以采用分层管理调用策略,先进行一次宏观的预筛选或过滤,再针对限定范围内信息调用工具,从而避免大量无效调用。同时,应充分利用缓存机制存储工具调用结果,避免重复请求。

除此之外,还应结合业务场景灵活选择工具调用的时机和频率,避免滥用工具调用。此外,随着技术的发展,未来工具调用的效率可能会进一步提升,新的架构和算法优化将降低调用的成本和对上下文窗口的占用,但现阶段尤其需要认识到调用的昂贵性与有限性,合理规划代理设计。代理设计者应充分调研自身应用的需求,评估工具调用需求规模,对工具本身的功能做深入规划,避免"工具调用次数无限制"带来的性能崩溃和用户体验下降。总而言之,虽然赋予大型语言模型工具调用能力极大地扩展了其应用边界,但其本质上的高昂成本和调用次数的天然限制,要求设计者必须明确权衡,在保证模型灵活性的同时,谨慎控制工具调用的频率和数量。只有充分理解工具调用的工作机制和成本来源,设计出功能强大且调用次数最优化的工具,才能打造出高效、稳定且能够长久支持复杂任务的智能代理系统。未来智能代理的发展,将越来越依赖于工具调用策略的创新与优化,这也为AI工程师和研究者提出了全新的挑战和机遇。

。