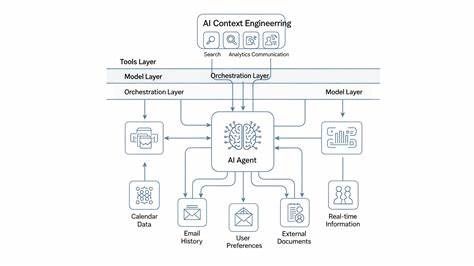

OpenAI 正在筹备一款以 AI 生成视频为核心的独立社交应用,内部代号围绕最新视频生成模型 Sora 2 打造。该应用采用竖屏短视频流与滑动浏览的交互方式,视频长度被限定在 10 秒以内,所有内容均由 AI 生成,普通用户无法上传摄像头拍摄的素材。这一设想既带来技术创新的想象空间,也引发关于版权、隐私、未成年人保护和平台责任的讨论。 Sora 2 社交应用的产品形态极具目标感。界面模仿短视频生态的经典交互,右侧菜单提供点赞、评论、remix 等功能,页面存在 For You 风格的推荐流,算法会根据用户行为持续个性化内容分发。核心差异在于创作来源从人类拍摄转向 AI 生成。

用户通过文本提示或简单指令让 Sora 2 生成短片,生成后可直接在应用内分享或 remix 他人作品。 身份验证和个人肖像使用是 Sora 2 应用的一大特色。平台提供用户身份验证功能,已验证的用户可以在生成的作品中使用自身肖像。其他用户如果想在视频里使用某位已验证用户的样貌,需要对方被标注或授权。平台同时会在使用某人肖像时向该人发送通知,甚至在作品仅停留为草稿时也会触发提醒。这一设计意图在于为用户提供一定程度的知情权与控制权,但实践中可能面临复杂的同意管理与滥用场景。

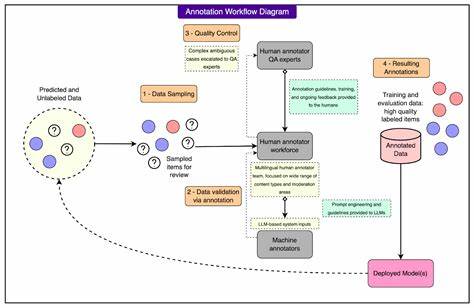

从技术层面来看,Sora 2 在生成短视频方面具有先进能力,但并非万能。OpenAI 在此前版本中已经承认 Sora 系列模型在理解物理法则、生成复杂动作场景和长时序连贯性方面存在限制。把视频时长限定在 10 秒,一方面是为了降低模型出错概率,另一方面也是为了控制算力成本和内容审核难度。短时片段更适合展示创意概念、视效尝试或情景梗,但在现实感、动作物理和连续叙事上仍需谨慎评估。 内容审核与版权保护是 Sora 2 面临的核心风险之一。模型在生成过程中会触发一系列过滤器与版权保护链路,许多生成请求会因涉嫌侵权或触及敏感内容被拒绝。

OpenAI 当前正卷入多起版权诉讼,其中包括纽约时报等媒体对模型训练数据来源的指控。短视频社交平台本质上是强调传播与去中心化创作的场域,若生成模型的训练数据涉及未经授权的受版权保护素材,平台可能面临持续的法律压力。 与 Meta、Google、TikTok 等巨头的竞争与差异化策略值得关注。Meta 在其 Meta AI 应用中推出了名为 Vibes 的 AI 视频创作和分享频道,Google 则将 Veo 3 的定制版本整合进 YouTube。TikTok 则选择更谨慎的路径,更新社区准则,明确禁止在公共事务或造成他人伤害时发布误导性 AI 内容。OpenAI 把 Sora 2 做成独立社交产品,既是对短视频生态的直接入场,也是其在监管、品牌与市场定位上进行的一次重要博弈。

平台内的创作生态与创作者经济值得深究。AI 生成视频降低了创作门槛,任何用户都可能成为创作者,产生大量短时、高频的内容输出。对草根创作者而言,这是机会,能以极低成本尝试多样化创意。但这同样会稀释原创视频和现场拍摄作品的价值,可能压低人类创作者的收入预期。如果平台追求高频互动以驱动推荐算法,内容质量与真实性的平衡也会变得困难。 隐私与个人肖像权保护在 AI 视频时代显得尤为重要。

Sora 2 的身份验证机制尝试通过通知与标注建立保护链,但能否有效防止恶意深度伪造仍成疑问。即便是已验证用户,如何界定授权范围、使用场景与撤回权利,都涉及技术实现与法律制度的配合。此外,通知机制若覆盖草稿阶段,会带来监控感与行为收敛的风险,从而影响用户创作自由。 未成年人安全与年龄管理是公众关注的敏感点。OpenAI 最近推出了家长控制与青少年关联账户功能,并在研发自动年龄预测工具,计划将疑似未满 18 岁的用户路由到更受限的交互模式。Sora 2 如何落实年龄验证、内容限制与接触控制尚未明朗。

短视频平台的吸引力对青少年极强,AI 生成内容可能放大误导性、性化或危险行为的风险,平台必须在产品设计、内容策略与外部监管之间找到平衡。 在内容溯源与可验证性方面,Sora 2 面临行业共同挑战。为了防止深度伪造与误导传播,平台应考虑在生成内容中嵌入可检验的元数据或可视水印,标注作品为 AI 生成并保留生成参数、时间戳与创作者身份。透明度可以缓解部分信任问题,但也可能被技术熟练者规避,因此需要结合审查机制和外部问责机制。 法律与监管层面将不断演进。全球多国对 AI 生成内容的监管正在加速,关于标签义务、深度伪造惩罚、数据训练来源披露和未成年人保护的法律草案陆续出现。

OpenAI 若推出独立社交平台,必须面对多法域的合规要求,并准备好对应的内容审查、申诉机制与跨境数据治理策略。平台还需建立迅速的人工复查流程,以应对算法误判或恶意滥用导致的公关与法律风险。 从社会影响角度看,AI 短视频社交平台可能重塑信息传播节奏与文化生成模式。短时间、高频次的 AI 内容输出会加剧信息碎片化,也可能催生新的流行文化现象。与此同时,依赖同质化模型生成的内容易陷入风格单一与创意疲劳,平台和创作者都需要探索混合创作方式,将 AI 辅助创作与真人创意结合,才能维持长期吸引力。 为降低风险并提升用户信任,平台可以采取多重策略。

首先,加强版权合规和训练集透明度,积极探索与版权持有者的合作与许可机制。其次,实施分层身份与肖像使用权限管理,赋予被标注用户撤回权和明确的授权日志。再次,在 AI 生成内容中显性标注其来源与生成参数,并提供便捷的举报与申诉通道。最后,投入足够的人力进行高风险内容的人工复核,尤其是涉及公众人物、未成年人和公共事务的内容。 在商业化路径上,Sora 2 平台可以考虑与创作者经济结合,探索原创激励、付费滤镜或品牌合作等模式。OpenAI 在 ChatGPT 内部引入广告和商业功能的尝试表明,其对变现路径保持开放态度。

然而,商业化也会放大监管审查和公众关注,如何在营收与合规之间找到可持续模式将是关键。 展望未来,Sora 2 社交应用若能在内容透明度、版权合规和未成年人保护上形成可行机制,可能成为 AI 视频普及的重要窗口。但如果监管、版权争议与滥用问题无法有效解决,平台将面临监管收紧和用户信任流失的双重挑战。OpenAI 的这一探索不仅是技术产品的推出,更是对社会治理、法律边界和文化生态的一次重要考验。 总体而言,AI 生成短视频社交化是一场新型技术与既有制度的碰撞。关注点涵盖技术能力、产品设计、法律合规与社会伦理。

无论最终形态如何,关键在于确保技术服务于真实、负责和有创造力的社交生态,而非放任滥用和侵权行为泛滥。未来数月到数年间,Sora 2 能否在竞争激烈且监管敏感的市场中找到自己的位置,将为整个 AI 媒体生态带来重要参考价值。 。