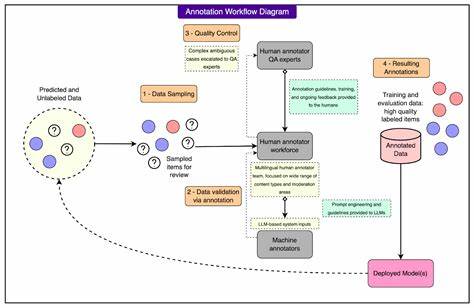

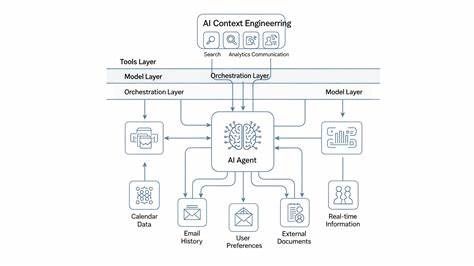

Tator 是一个面向单机部署的图像标注工具,结合了交互式人工标注与确定性自动化预标注流程,目标在于在不牺牲质量的前提下显著提升标注效率。它将现代视觉基础模型和传统检测器的优势整合到一个可复现的流水线中,适合已经有目标检测数据集或需要扩充数据集的团队使用。本文将从产品定位、核心功能、预标注与校准机制、系统架构、安装与运行、实践建议以及许可合规等方面,深入剖析 Tator 的设计要点与落地应用场景,帮助读者判断是否适合引入到自己的标注与训练流程中。 Tator 的核心价值在于把人类标注者的判断与自动化候选生成结合起来,既保留人工核验的高精准度,又充分利用模型和分割工具放大标注速度。交互式工具部分支持 CLIP 驱动的自动类别纠正、SAM 的框精化与单点生成,用户可以用最小的点击代价获得高质量边界框,复杂或遮挡的场景则可以通过多点正负提示来微调分割结果。自动化预标注流程则采用一个被称为"prepass + calibration"的两阶段思路:先把检测器与 SAM3 的文本提示生成高召回的候选集合,再用 XGBoost 等分类器在满足召回下筛选出高 F1 的候选,以减少人工审阅成本。

在候选生成阶段,Tator 支持同时运行多个检测器,例如 YOLOv8 和 RF-DETR,并且为每个检测器提供全图与窗口化(SAHI)两种推理模式,随后对结果进行 IoU 合并去重,形成稳定且可追溯的候选池。SAM3 被用于文本驱动的分割与相似度检索,在具备数据集术语库(glossary)时可以通过短语扩展或者 Qwen 自动扩写来提高对类内细分语义的覆盖。全流程设计强调可复现性,预标注的中间产物会被缓存,校准作业可以被记录在 uploads/calibration_jobs 下,便于回溯与调参。 校准阶段是 Tator 的关键差异点。预标注阶段刻意保留高召回的候选以免丢失难例,之后通过训练一个轻量级的 XGBoost 分类器,利用与候选相关的上下文特征来过滤假阳性,并强制满足用户设定的召回下限,从而在人审时把关注点集中在更精确的候选上。该设计把模型自动化的风险控制在可接受范围之内,同时最大化人工审核效率。

项目提供了校准缓存与作业跟踪机制,方便对不同 IoU 阈值、窗口化策略和检测器组合做系统化对比,得出最适合当前数据分布的预标注管线组合。 在交互式标注体验上,Tator 将多项现代辅助功能做成实时工具。Auto Class Corrector 基于 CLIP 的 embeddings 对边框进行类别建议以减少打错标签的概率;Auto Box Refinement 使用 SAM 来将宽松或粗糙的框 tighten 到对象边缘;Point-to-Box 支持单次点击快速生成准确盒子;多点提示允许标注员通过添加正负示例点在复杂背景、重叠或部分遮挡的对象上快速收敛到理想的分割结果。这些功能的组合显著降低每张图像的人工操作量,尤其在车辆、人群或工业零件等物体外观多样的场景中效果明显。 Tator 还支持从 UI 内启动训练流程,包含 CLIP 或 DINOv3 head 的训练以便生成更稳健的 embedding 缓存,以及 YOLOv8、RF-DETR 和 SAM3 的训练与管理。训练管理包括保存训练运行、下载、删除或重命名模型的能力,便于把标注流程和模型管理放在同一平台中闭环。

Qwen 模型用于图像 captioning 与术语扩写,在需要生成更丰富文本提示用于 SAM3 文本驱动分割时发挥作用。需要注意的是 Qwen 的使用需要审阅相关模型许可,并根据部署环境选择 CPU 或 GPU 路径与窗口化策略以兼顾成本和效果。 部署方面,Tator 是以单机 FastAPI 后端加前端静态页面的形式提供,适合小团队或边缘部署场景。推荐环境为 Python 3.10+,有 NVIDIA GPU 时可显著提升 CLIP、SAM 和 Qwen 的推理速度。运行步骤包括创建虚拟环境、安装依赖、将 SAM1 权重放置到项目根目录、复制并修改 .env 配置文件、以及通过 uvicorn 启动 app。可选的 SAM3 支持需要额外从 Meta 的仓库获取权重并安装 sam3 包,一些高级功能比如 SAM3 文本与相似度需要访问这些权重与相应的 Hugging Face 模型卡来确定许可与使用限制。

在实际使用中,需要权衡窗口化(SAHI)带来的精度收益和推理成本。窗口化通常用在小目标或画面密集的图像,可以在小尺寸目标上提升检测召回,但会增加推理时间与 GPU 资源使用。作者在基准测试中指出,启用 2×2 窗口化的 SAM3 文本与相似度会将每张图像耗时从约 20 秒提升到 31 秒,双 A6000 GPU 的情况供参考,实际性能会受模型大小、GPU 型号与 IO 影响。务必在小规模数据上做烟雾测试来评估资源消耗,再决定是否在全量数据上启用窗口化策略。 数据与术语管理是 Tator 的另一亮点。每个数据集可以维护一个专属的 glossary,作为 SAM3 文本提示的词汇来源,并有一个可复用的 glossary 库。

对于行业垂直或专有名词较多的场景,可以结合 Qwen 的可选扩写功能来自动生成候选提示,从而覆盖人类词汇变体与同义词。这种做法在需要细粒度类别定义时非常有用,例如制造业零件、医疗影像细分或无人车场景下的语义细化。但需注意生成提示的质量与潜在偏差,建议由领域专家验证生成的扩写以避免提示污染训练目标。 安全性与合规方面,Tator 明确提示整合了若干第三方工具,每个工具的许可证需由使用者评估并遵守。Ultralytics YOLOv8 使用 AGPL-3.0 许可证,RF-DETR 与 XGBoost 使用 Apache-2.0,SAM 与 SAM3 的使用需遵守 Meta 发布时的条款,Qwen 的模型也有其许可限制。生产部署前应评估这些许可证对内部代码的影响、是否允许闭源使用、是否需要对外发布源代码等合规要求。

如果无法满足某些开源许可证的传播义务,可考虑替换成兼容的模型或与法务团队讨论合理使用策略。 在构建可复现的标注流水线时,Tator 的缓存与作业记录机制提供了很大帮助。预标注的中间结果会被存到 uploads/calibration_cache 目录,校准作业则有独立的 uploads/calibration_jobs/<job_id> 路径,便于多人协作时对不同参数组合的对比与回溯。有效的实践是先在小规模验证集上运行不同的检测器组合、SAM3 启用状态与窗口化策略,比较 Precision/Recall/F1 等指标,再在标注集上做有控制的 A/B 测试。作者给出的基准显示,直接使用 detectors 的 baseline F1 往往低于预pass + XGBoost 的组合,后者在 4000 张图像的测试中可把 F1 提升到 0.82 左右,但这些结果依赖于数据分布与 IoU 选择(例:IoU=0.50 更偏召回,IoU=0.75 更严格)。 引入 Tator 到现有流程时,有几条实用建议值得参考。

首先,准备好类别定义与术语表,并在早期投入时间整理 glossary,因为高质量的文本提示可以显著提升 SAM3 的文本驱动候选质量。其次,把预标注的阈值和召回下限设置为能容忍一定假阳性的水平,然后通过校准器把精度拉回去,这样能最大限度避免漏标。再次,在训练 CLIP/DINOv3 的 embedding head 时优先使用代表性样本并缓存 embeddings,以加速后续类校正与相似度检索。最后,为了降低人工审核认知负担,建议在 UI 中以可视化方式展示候选的来源与置信路径,让标注员快速识别生成候选是否来自 detector、SAM3 文本或相似度分支。 Tator 并非万能,适合的场景是那些希望在本地环境中维持数据隐私、需要对标注质量有严控且愿意投入模型调优与流水线管理的团队。对于极大型的分布式标注需求或完全托管的企业级标注平台,Tator 的单机架构可能不是最优选择。

但其开放源码与模块化设计使得研究团队或小型数据工程团队可以快速搭建可控的半自动标注闭环,快速迭代训练模型并把改进直接反馈到标注效率上。 总体来看,Tator 提供了一个务实而完整的本地标注解决方案,把自动候选生成、基于文本的 SAM3 分割、去重与校准策略、以及交互式标注助理集成到一个可操作的平台。它强调确定性、可复现的预标注与校准流程,通过缓存与作业记录支持持续优化。对希望在隐私可控环境中提升标注效率、同时严格把控数据质量的团队,Tator 值得作为一个起点进行评估与试用。部署时请注意相关第三方模型与工具的许可证要求,先在小规模数据集上评估推理成本与精度,再逐步扩大应用范围,以实现最佳的人机协同标注策略。 。