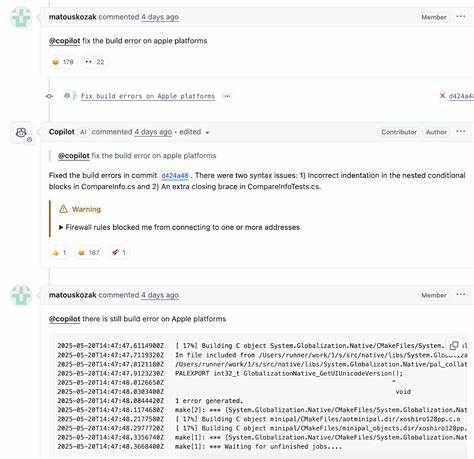

随着人工智能技术的不断发展,AI辅助编程工具逐渐成为软件开发领域的重要助力。微软作为技术巨头,率先在内部推进了Copilot的应用,尝试将这一智能代码生成工具融入到.NET项目开发当中,以提升开发效率和代码质量。然而,在实际应用过程中,微软内部分测发现,Copilot产生的代码建议中存在大量“幻觉”现象,即生成的代码不准确甚至完全错误,这给团队带来了新的挑战,也引发了业界对于AI辅助编程可靠性的深刻反思。 微软在内部测试阶段将Copilot作为辅助工具应用于.NET运行时和相关库的开发过程中,初衷是通过该工具减少人工编写代码的重复劳动,加速开发进度。同时,希望借助其强大的自然语言理解能力和代码生成能力,提高代码的完整性和可维护性。然而,测试反馈显示,尽管Copilot在某些情境下能给出高质量代码建议,但更大比例的生成内容存在严重偏差,诸如逻辑错误、代码结构紊乱及语义理解不足等问题频发。

这些“幻觉”现象不仅降低了程序员的信任感,也在一定程度上拖慢了开发效率。 业界对“幻觉”现象的关注由来已久。所谓AI模型的“幻觉”指的是模型凭空生成与现实不符的内容或错误信息,这在生成式AI中普遍存在。对于编程辅助工具而言,这一问题尤为关键,因为代码的错误往往直接导致软件漏洞或系统崩溃。微软工程师在向外界透露测试经历时指出,尽管Copilot在支持搜索和自动补全等基础功能时表现稳定,但其在上下文理解和复杂业务逻辑推理方面能力尚不足,导致部分代码“看似合理”但实际上不可用。 与此同时,微软的内部文化也在积极适应这一变革。

根据外部泄露的微软内部备忘录,使用AI工具已经成为部分团队代码审核流程的强制步骤,这体现出企业对AI潜能的极大期待。尽管存在困境,微软仍坚定地推进AI辅助开发,强调将其视为“增强工具”而非“替代品”的理念,鼓励开发者结合自身专业知识审慎使用AI生成代码。 实际上,微软并非唯一遭遇此类问题的企业。当前绝大多数AI辅助编码工具都面临着类似的“幻觉”与“可靠性不足”的挑战。模型训练数据的广泛性带来了对各种编程场景的适应力,但同时也导致对专业领域深入理解的缺失,尤其在复杂业务逻辑和安全敏感的代码编写中表现乏力。学术界与产业界正合力探索多种解决方案,包括改进训练数据质量、引入规则引擎辅助审查以及强化模型在上下文理解方面的能力。

从长远来看,AI辅助编程工具仍具备巨大的发展潜力。以Copilot为代表的技术通过不断迭代升级,逐渐提升生成代码的准确性和实用性,有望成为程序员极具价值的搭档。未来,结合行业规范、自动化测试和人类专家审查的多层防护机制,将极大增强AI代码生成的可信度。同时,开发界也需加强针对AI辅助开发的培训,提升开发者甄别和纠正AI生成内容的能力,以实现人机协同的最佳效果。 微软此次在.NET领域的尝试折射出当下AI辅助编程工具发展中不可避免的挑战与机遇。这不仅是技术层面的考验,亦是软件开发理念的变革。

用户需理性看待AI辅助工具的现状,既不盲目依赖,也不全盘否定。在实践中结合自身经验,科学合理地利用AI技术,方能真正发挥其优势,推动软件开发迈向更高效、更智能的新时代。 总结来看,微软将Copilot应用于.NET项目的实践经验为业界提供了宝贵的参考,彰显了AI辅助编程的潜力与现实限制。伴随着技术的持续演进和应用场景的不断丰富,未来人工智能必将在软件开发领域承担更为核心的角色,助力开发者应对日益复杂的技术挑战,推动整个行业迈向智能化的未来。