近年来,大语言模型(LLMs)在自然语言处理领域取得了突破性进展,其强大的语言理解和生成能力极大地推动了人工智能技术的发展。然而,随着模型应用场景的不断扩展,对处理更长上下文的需求也日益增长。长上下文处理能够帮助模型更好地理解文本全貌,捕捉复杂的语义关系,从而生成更加连贯准确的结果。但与此同时,传统的注意力机制由于计算复杂度呈二次增长,给模型的长上下文扩展带来了巨大挑战。在这个背景下,KV缓存压缩技术成为提升长上下文处理效率的关键手段之一。KV缓存,指的是在自注意力机制中存储的键(Key)和值(Value),用以帮助模型快速查找和利用先前信息。

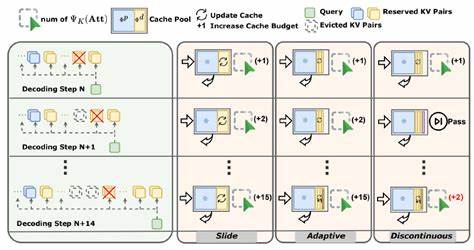

当前主流的KV缓存压缩方法大多将键和值视为同质数据,采用相似的压缩策略。然而,最新的研究发现,这种统一处理忽略了键和值在局部上下文中的本质差异性,影响了压缩效果和模型性能。具体而言,研究揭示了KV缓存中存在“局部非对称性”:邻近的键表现出高度的相似性,称为局部键同质性,而对应的值则往往分布各异,表现为明显的异质性。这一发现打破了传统压缩方法对KV缓存的统一看法,提示我们需要差异化策略以充分利用这种结构特点。基于此认知,研究团队提出了一种创新性的训练无关压缩框架AsymKV。该框架利用局部键的同质性,通过智能键合并技术有效减少冗余键的存储需求,极大降低了模型的计算负担。

同时,针对值的异质性,AsymKV设计了数学上证明无损的值压缩算法,确保关键信息不受损失,保障了模型的推理精度。AsymKV的设计避免了对模型重新训练或微调的依赖,极具实用价值和推广潜力。在多个基准测试和实际任务中,AsymKV展现了超越现有最先进方法的显著优势。以LLaMA3.1-8B模型为例,AsymKV在LongBench评测中达到了43.95的平均评分,远超H2O等领先方案。这不仅反映了压缩效率的提升,更说明了信息保留和语义捕捉能力的增强。KV缓存非对称性的发现与利用为长上下文LLMs的性能突破提供了新的思路,也为未来相关技术路线指明了方向。

传统的KV缓存压缩忽视值的异质性往往导致信息损失和模型预测准确率下降,而AsymKV通过差异化压缩策略兼顾了效率和效果,成为行业的里程碑。延展而言,随着模型规模和应用复杂度持续增加,长上下文处理的需求愈加迫切。如何在有限的计算资源下实现高速且高质量的上下文管理,是当前乃至未来研究的重点。利用局部数据结构特征进行差异化优化,有助于突破传统瓶颈,提升模型的实用性和用户体验。同时,AsymKV不依赖额外训练参数或复杂微调,具备良好的兼容性和适配性,方便集成到各种LLM框架中,助力广泛应用推广。未来研究方向可以探索更丰富的缓存结构分析,结合动态上下文感知策略,实现更加智能和灵活的缓存管理。

此外,将KV缓存非对称性原理应用于多模态模型、多任务学习以及边缘计算领域,或能催生更多创新和效率提升的可能。总结来看,局部KV缓存非对称性的发现揭示了长上下文处理背后的深层次数据分布特征,AsymKV框架通过对键值特性的精细化利用,成功提升了压缩效果和模型性能,为大语言模型迈向更长上下文领域铺平了道路。随着AI技术不断进化,该研究成果必将在推动智能语言理解和生成能力的边界上发挥重要作用,助力构建更加智能、高效的人工智能系统。