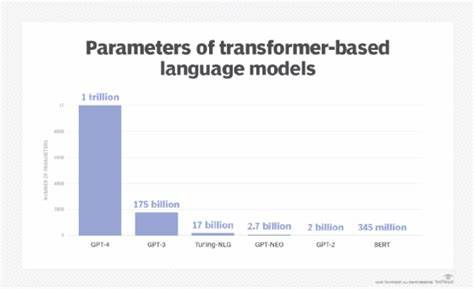

随着人工智能技术的迅猛发展,大型语言模型(LLMs)在文本生成、自然语言理解等领域取得了显著进展。然而,尽管它们在诸多任务中表现出色,LLMs在寻找和构造数学证明方面却表现平平,甚至面临诸多挑战和限制。为什么这些备受瞩目的语言模型在处理严谨的逻辑推理任务时表现不佳?对此,本文将深度剖析LLMs的技术特点、内在瓶颈以及数学证明任务的特殊性,力求为读者揭示背后的根本原因,并展望未来可能的改进方向与发展前景。 大型语言模型的设计初衷和训练机制决定了它们主要擅长的是对自然语言的统计模式学习。通过海量文本数据的无监督训练,模型掌握了丰富的语言结构、语义联结以及上下文理解能力。但数学证明任务实际上是一项高度逻辑严谨和结构性强的推理活动,需要绝对的准确性和严密的步骤衔接,这种领域规则远远超出语言模式的范畴。

LLMs虽然能生成看似合理的文本和推理,但其生成过程本质上依赖概率分布和模式匹配,它们并不真正“理解”数学命题的内涵和逻辑必然性。因此,它们常会在证明过程中出现跳跃推理、不严谨论证甚至逻辑错误。这种情况在复杂推导或长链推理更为明显。另一方面,当前语言模型缺乏内置的数学知识和正式逻辑系统的基础,导致无法有效检验和验证每一步推理的正确性。数学证明往往涉及符号逻辑、定义精确的公理体系以及严格的演绎规则,然而LLMs主要面向自然语言,没有专门设计来处理形式语言和符号演算。因此,这些模型在保证推理严密性和连贯性上存在根本的局限。

此外,训练数据的局限也制约了LLMs在证明任务中的表现。虽然网络上不乏数学论文、教材等文本,但这些内容在数据中占比相对较低,且模型难以准确捕捉其中复杂的逻辑结构。训练过程中缺乏针对数学证明的专门标注和指导,使模型难以获得解决该任务所需的明确信号和反馈。数学证明不仅需要语言的表达能力,还依赖深层次的逻辑推理能力和抽象思维,这远乎于简单的文本生成。 另一方面,现有的评价标准和训练目标也未能促进模型在数学证明方向的进步。大多数模型训练旨在最大化语言预测的准确率,主要关注语言流畅度和上下文相关性,而非逻辑严谨性和证明有效性。

因而,模型生成的“证明”往往只是文字上的连贯,而缺乏真正的数学说服力。 对于解决上述问题,研究者正在积极探索多种方法。一种路径是结合神经网络与符号计算,利用强化学习和符号推理工具对模型进行指导,让其不仅依赖语言模式,还能执行正式规则验证推理有效性。另一种方法是设计专门的数学语言模型,不仅学习语言规则,更系统地吸收数学知识库,提升形式推理能力。 此外,开发更精细的训练数据和评测体系同样关键。对数学证明步骤进行结构化表示和注释,辅以人类专家指导,使模型获得更准确的训练信号。

引入自动化定理证明工具,辅助训练评价路径,推动模型稳健学习数学推理。 总体来看,虽然LLMs在理解和生成日常语言表现惊人,但面对严苛的数学证明任务,现阶段它们依旧存在显著不足。这既源于其基于概率模型的本质,也受限于训练数据、任务目标和模型架构。未来通过多模态融合、符号推理结合及专门的数学知识注入,或可大幅改进其逻辑严谨性和推理深度。 数学证明作为逻辑推理的典范,彰显了智能系统需突破单一统计学习,迈向认知和理解的全新境界。大型语言模型虽非完美证明者,但为人工智能的推理探索铺路,激发出更多创新思考。

从根本上提升机器在复杂推理领域的表现,将推动科学研究、教育以及工程应用的智能化革命,实现人类与机器协作探索知识的更高峰。