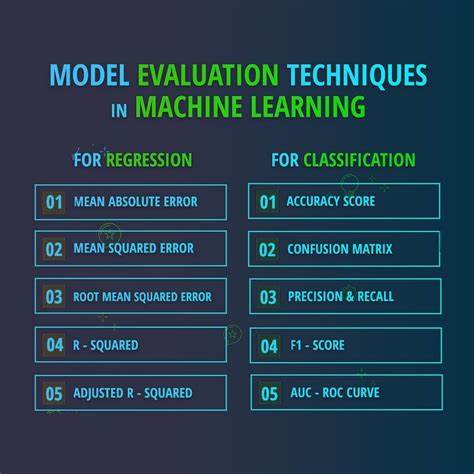

随着人工智能技术迅猛发展,机器学习模型尤其是大型语言模型(LLM)逐渐成为推动行业革新的核心力量。然而,在这些模型取得诸多突破的背后,模型评估技术却可能成为限制甚至遮蔽新发展的一道门槛。本文将带您深入探讨当前机器学习模型评估的现状,剖析其潜藏的问题,并展望未来人工智能发展可能借助于更科学和多元的评估机制实现质的飞跃。 机器学习模型的评估技术一直被视为推动算法进步的重要驱动力。无论是谷歌搜索排名的点击率评估,还是大型语言模型在特定任务上得到的准确率,这些评估指标为研发团队提供了明确的优化方向。例如,当一个搜索引擎调整算法时,评估指标能够直观反映用户行为变化,从而指导改进策略。

早期阶段,由于产品性能尚未成熟,各类评估指标往往较为一致,优化一个评估指标的同时,模型整体性能也会随之改善,推动技术快速成长。 但当模型性能趋于成熟时,问题就开始显现。评估方法难以适应复杂真实环境的多样性,甚至可能误导研发方向。著名的经济学原理"古德哈特定律"(Goodhart's Law)指出,当某个指标成为目标时,它就不再是一个好的指标,这一现象在机器学习模型评估中同样适用。当模型集中过度优化某一评估指标,模型可能牺牲其他核心能力,导致整体效果下降。谷歌和微软必应搜索引擎的争论正是该现象的反映;必应在某些内部评估上表现优异,却可能因优化评估指标而损害了实际用户体验。

此外,传统评估方法在面临自然语言理解和生成能力上也暴露出明显局限。经典的图灵测试作为人工智能语言能力评估的"里程碑",在LLM性能飞跃后显得愈发乏力。如今,许多大型语言模型已经可以通过调节回答风格、语速等"表演"方式让人类难以区分其身份,短时间内通过测试。然而,这种通过表层技巧获得的"通过"并不代表模型具备真正智能,如词汇拼写检测等基础常识性问题暴露了更多深层次的理解缺陷。由此可见,基于简单判别的人机对话测试已经不足以评估模型真实能力。 为了应对模型能力的多样化和深层化需求,业界不断提出更具挑战性的评测基准。

比如用于程序合成的SWE-bench,高等教育水平问答的GPQA,以及覆盖多模态理解的MMMU等基准指标,均旨在衡量模型在特定高难度任务中的综合表现。这些评估不仅衡量模型的答案正确率,也考察其推理能力和跨领域应用潜力,是衡量经济价值的重要风向标。然而,令人担忧的是,随着大资金巨头纷纷投入,模型训练高度依赖这些公开评测数据,导致模型在设计和优化上趋同,形成某种"训练集陷阱",在数据量和复杂度上爆发式增长,模型创新空间反而受到限制。 另一方面,为了跳出这种依赖大规模数据训练的困境,有研究者开始重新思考智能的本质。弗朗索瓦·肖莱提出的"智能衡量论"以及抽象推理基准ARC试图从"技能习得效率"角度定义智能,聚焦模型泛化能力和少量样本下的抽象思维突破。不同于单纯的任务准确率,ARC强调对模型进行不依赖于海量训练数据的"程序推理",让模型具备从有限经验中总结规则并应用到新问题上的能力。

虽然早期ARC数据集已经被一些大型模型通过逆向工程"破解",但新一代的ARC挑战仍然难倒前沿模型,显示出评估方法更新换代的必要。 值得注意的是,当前主流的大型语言模型仍然存在诸多系统性缺陷。它们对数据的依赖极为敏感,难以实现真正的在线学习,更无能力像人类大脑一样灵活地进行知识整合和推理。模型权重训练完成后趋于固定,缺乏持续学习和自我修正机制。自动回归生成方式使得错误一旦产生便会逐步叠加,无法从根本上纠正偏差。此外,模型更多是通过符号层面的词汇预测完成"推理",缺乏对思想空间的真正理解和构建。

这种以词语串联为核心的运作方式难以实现复杂的抽象思考和有效的长远规划。 针对现有不足,学界和业界已经提出多种解决方案。弗朗索瓦·肖莱建议利用程序合成突破当前深度学习的局限,向系统二思维(即理性、有条理的思考)转变,这一思路受丹尼尔·卡尼曼"思维快慢"理论启发。另一位诺贝尔奖获得者叶文提出的期望距离预测自编码机(JEPA)则强调通过无监督学习抽象输入的本质属性,使模型能够在更高层次形成稳健的表征而非数据细节。还有诸如"千脑计划"倡议者将大脑认知机制作为启发,试图构建全新非深度学习框架,从神经科学角度推动人工智能革新。 这些观点表明,未来人工智能发展的关键可能不在于模型规模的无休止扩张和传统评估指标的微调,而在于重新审视人类大脑的认知结构和学习机制,将神经科学与人工智能紧密结合。

深度学习诞生初衷即源于对神经元工作机制的仿生启发,而实际发展过程中却过度依赖指标驱动,忽略了智能本质的复杂性。随着目前技术遇到瓶颈,借鉴脑科学的动态学习、可塑性和多层次抽象能力,有望冲破现有限制,实现人工智能的质变。 总结来看,机器学习模型现有的评估技术在推动AI发展中发挥了重要作用,但也暴露出局限和误导风险。过度依赖单一评估指标可能导致算法优化陷入局部最优,无法体现模型的整体智能水平。图灵测试的日益乏力以及对多维能力基准的需求呼唤更多元且动态的评估标准。未来,应加强评估方法的多样化和创新性,吸纳如抽象推理、在线学习效能、认知接近度等新指标。

同时,融合脑科学与人工智能研究,为打造真正具备思维能力和学习能力的模型开辟新路径。当人类智慧与机器智能的界限逐渐模糊,AI也将迎来突破性的飞跃,开启无人想象的未来。 。