引言 在大数据生态中,Apache Spark 长期以来被视为处理海量数据的标准工具,特别是在分布式批处理和流式处理场景中占据主导地位。然而,随着列式内存分析引擎的发展,DuckDB 等轻量级单机 OLAP 引擎在若干场景下展现出惊人的性能优势。有基准测试显示,在处理单个 500M 记录文件时,DuckDB 在某些查询上可以比 Spark 快多达 5 倍。这个结论并不是绝对真理,而是多种因素共同作用的结果。理解这些因素对于架构师和数据工程师在实际项目中做出技术选型至关重要。 背景与技术差异 要理解性能差异,首先要看两个系统的设计目标。

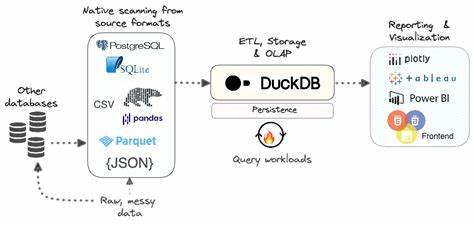

Spark 设计为可扩展的分布式计算平台,擅长跨多节点并行处理 PB 级数据、容错、调度复杂作业和与生态系统深度集成。DuckDB 则是一个嵌入式列式数据库,目标是高效的单机分析查询,强调向量化执行、列式存储、本地 I/O 优化与零运维的使用体验。两种设计在架构上有根本性区别,这些区别在中等规模数据集上(例如包含数亿条记录的单个文件)会显著影响性能。 I/O 本地化与文件扫描开销 当查询需要扫描大量数据时,I/O 成为关键瓶颈。DuckDB 在读取 Parquet 或 CSV 等列式文件时采用高效的列裁剪和谓词下推,能只读取所需的列和页,从而减少磁盘和内存带宽占用。因为它通常运行在单节点上,I/O 路径更短、缓存利用更好,且没有分布式调度产生的额外网络开销。

Spark 在读取大型单文件时,会尝试将文件切分并分配到多个任务,但单文件的切分策略、启动任务的开销以及每个任务对文件元数据的访问都会带来额外延迟。对于某些扫描密集型的分析查询,单机优化良好的 DuckDB 可以在 I/O 与 CPU 使用效率上占有明显优势,从而在端到端性能上胜出。 向量化执行与 CPU 利用率 DuckDB 的执行引擎高度向量化,意味着在内存中以列向量为单位进行算子处理,使用批量 CPU 指令(SIMD)和流水线优化,减少解释开销并提升 CPU 的数据吞吐量。Spark 的 Tungsten 项目也引入了向量化和代码生成优化,但在分布式执行中,任务粒度、序列化/反序列化成本以及线程协调开销常常限制了单核心或单节点的 CPU 利用率。在 500M 记录这种适合单节点缓存和处理的数据规模下,DuckDB 的向量化管线更能发挥作用,带来更低的每行处理时间。 内存管理与垃圾回收 JVM 上的 Spark 需要管理垃圾回收、对象分配以及复杂的内存分层(执行内存、存储内存)。

这会导致在峰值负载或复杂查询时出现长尾延迟。DuckDB 使用 C++ 实现,更接近操作系统层面的内存控制并能高效利用内存池和内存映射文件,从而减少内存碎片和 GC 干扰。在 500M 记录的数据集上,内存使用策略的差异可能决定查询是否完全在内存中完成,进而显著影响响应时间。 并行化与调度开销 Spark 的强项之一是将计算分散到大量核与机器上,从而处理超大规模数据。分布式调度、任务启动与网络传输是其不可避免的开销。对于单文件或小量文件的查询,调度与序列化成本可能占总时间的很大一部分。

DuckDB 在单节点上运行时不存在这类分布式开销,因此在端到端延迟上常常更有优势。换句话说,如果数据可以被单台机器高效处理,分布式系统的"分布式税"会让它变得不划算。 查询类型的影响 不同查询类型对系统的要求不同。聚合、筛选、列裁剪等典型 OLAP 操作在列式引擎上非常高效,DuckDB 在这些场景通常表现优秀。复杂的多表联接、跨分区的全局聚合或需要处理高并发写入的工作负载则更适合分布式平台。基准声称"快 5 倍"通常基于一组特定查询(例如大表扫描加聚合),因此理解查询特性对于评估结论的适用性很重要。

文件格式与分区策略 文件格式对性能影响非常大。Parquet 或 ORC 等列式压缩格式能显著减少磁盘读取量,并支持谓词下推与列裁剪。DuckDB 对 Parquet 的读取路径在单机场景下被高度优化,加载速度和解码效率都很高。如果基准使用了单个大文件而不是大量小文件,DuckDB 能更好地利用顺序读取与系统缓存。Spark 在面对大量小文件或需要跨分区聚合时,元数据管理与任务调度会增加成本。优化文件大小、正确设置分区策略以及使用列式格式,是提升任一引擎性能的关键。

可复现性与基准设计 声称某引擎"比另一引擎快 N 倍"必须谨慎对待,基准结果受许多变量影响。硬件差异(磁盘类型、CPU 核心数、内存大小和 NUMA 架构)、数据分布、压缩算法、列顺序、查询实现、并发度设置以及运行时参数(Spark 的 shuffle 配置、内存分配、JVM 参数;DuckDB 的线程数和内存限制)都会影响结果。良好的基准应公开测试脚本、数据生成方法、系统配置和运行环境,保证可复现性。工程师在参考基准时,应关注是否与自身生产环境相匹配。 成本与运维考量 从成本角度来看,单机引擎在许多中小规模分析任务上能显著节省资源,因为不需要维护分布式集群、复杂的调度系统和网络存储。DuckDB 可以嵌入到应用或便捷地与数据平台集成,减少运维负担。

然而,当数据规模增长到单台机器无法处理时,分布式系统的可扩展性成为必须。综合成本应考虑硬件、运维、可用性与扩展性需求。 什么时候选择 DuckDB,什么时候选择 Spark 如果工作负载主要是交互式分析、探查性查询或批量聚合,而且数据可以落在单台机器或适当分区的文件上,DuckDB 常常是更低延迟、低成本的选择。对于 ETL 中的局部处理、嵌入式分析或将查询放在应用内运行,DuckDB 的易用性与高性能尤其吸引人。 如果需要处理持续增长到 TB/PB 级别的数据、需要高可用分布式计算、跨多租户的资源隔离或复杂流式处理,Spark 的分布式能力和生态系统优势仍然无可替代。最佳实践是采用混合策略:在本地或近数据层面使用 DuckDB 做高效的探索性分析和小规模 ETL,必要时将重负载在 Spark 或其他分布式引擎上进行横向扩展。

实现可比较基准的建议 在对比性能时应遵循严格且公开的流程。确保测试在相同硬件上运行,详细记录系统参数,使用相同的数据集和文件格式,明确查询逻辑,并多次执行业务场景以统计平均与方差。关注冷启动与热缓存的差异,衡量 I/O、CPU、内存和网络的占用情况。提供可复用的脚本与数据生成代码,便于社区验证结果。只有经过这样的验证,性能结论才具有说服力并能转化为工程决策。 优化建议 无论选择 DuckDB 还是 Spark,优化策略有共通之处。

选择合适的文件格式,保持合理的文件大小与分区,利用列裁剪与谓词下推,尽量减少数据移动与重复解码。针对 Spark,需要合理设置并行度、内存比例、shuffle 参数与序列化策略。针对 DuckDB,应关注线程数、内存限制与数据布局(列顺序、编码方式),并利用向量化算子的优势。对查询进行剖析(profile),找出 I/O 瓶颈、CPU 瓶颈或网络瓶颈,是改进性能的关键步骤。 真实案例启示 社区与企业用户的实践表明,在分析型查询和探索性工作负载上,许多人发现将部分工作负载从 Spark 移到 DuckDB 可以显著降低查询延迟、减少资源成本并简化运维流程。另一方面,在需要跨多节点联合大量数据或实现复杂 ETL 流程时,Spark 仍是不可或缺的工具。

基于具体业务场景进行混合部署,往往比单一工具全面胜出。 结论 "DuckDB 在 500M 记录文件上比 Spark 快 5 倍"的说法在特定条件下是有依据的,但不能简单地泛化到所有场景。性能差异来自架构设计、I/O 与内存管理、向量化能力、调度开销与查询类型等多个维度。为了做出合理选择,需要基于可复现的基准测试、明确的业务需求和对资源成本的全面评估。在工程实践中,结合 DuckDB 的单机高效与 Spark 的分布式扩展性,采用分层与混合的处理架构,通常能在性能、成本与可维护性之间取得最佳平衡。 。