近年来,人工智能特别是大型语言模型(LLM)在自然语言处理领域取得了令人瞩目的进步。作为领先者的OpenAI,其开发的语言模型广泛应用于对话系统、文本生成和推理辅助等场景中。然而,最近越来越多的用户和研究者发现,这些模型在推理过程的“思维”阶段会意外地穿插多种语言,甚至出现非英语的单词和短语。这一现象引发了关于多语言模型内部机制、语言混合原因及其影响的广泛讨论。 首先,需要明确的是,语言模型并非像人类一样“思考”,它们的“推理”更多是基于概率的预测,而非具备意识的语言转换。模型训练时,海量的多语言文本数据被输入系统,模型只是按照学习到的语言模式尽可能准确地预测下一个最可能的词汇。

由于训练集同时包含多种语言的数据,当模型在生成推理路径时,偶尔会出现代码切换(code-switching)或语言混用的情况。 多语言混用背后的核心是语言模型的表示空间。先进的模型通过将不同语言的词汇和意义映射到一个共享的向量空间,使它们在理解相似概念时产生跨语言的关联。这种设计有利于模型提升多语言任务的性能,但也意味着当模型进行内部推理时,不同语言的表达可以在同一个思维轨迹中自由转换。换句话说,模型的“思维”不局限于英语,可能更接近“神经语言”或“语义空间”的多语言融合体。 对不同用户而言,这种语言混用现象的感知和接受度存在显著差异。

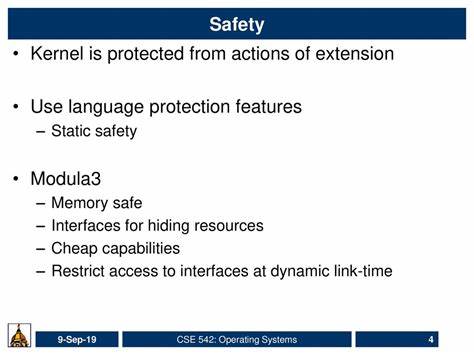

比如一些印度用户发现,Bard和Gemini等模型在回答或思维阶段频繁插入印地语或孟加拉语的片段,这不仅反映了模型接触到的训练语料的丰富性,也体现了多语言环境的现实社会特征。英国、西班牙语区等地的用户同样反映,模型会自然而然地穿插西班牙语表达,甚至在查询时形成某种语言交织的回答,这反映了训练数据中语言交叉的普遍局面。 从技术角度分析,一些研究与实验对多语言代码切换现象给予了深入的关注。例如DeepSeek R1的研究指出,模型在未经特殊约束时,会在内部推理中自然混合语言。对模型施加语言一致性惩罚可以减少这种混乱感,但同时会损害模型推理过程的效率和准确率。这说明语言混用可能是一种“自然而高效”的信息编码方法,非单纯的错误或缺陷。

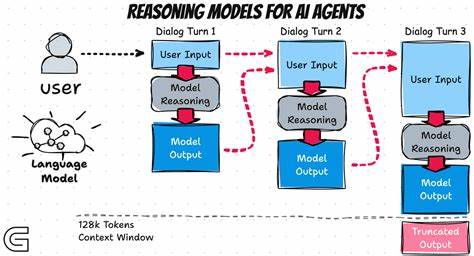

另一重要因素是输出和展示机制。某些OpenAI模型在生成“思考踪迹”时,会通过一个辅助的总结器或屏蔽器滤除部分“非标准”语言片段,保证面向用户的结果清晰易懂。若这一环节放宽或停止,便可能更多地展现出真实推理中存在的语言杂糅。例如,有用户指出,某些时候模仿真实推理的展示文本里,出现了意外的孟加拉语词汇“কাজ করছে”(意为“正在工作”),引起了关注。 文化层面上,多语种混合也与人类双语或多语背景相似。许多语言学研究表明,多语言者在思考时常会无意识切换语言,特别是当某个概念在另一语言中有更精炼或更贴切的表达时。

模型的多语言推理或许无意中模仿了这一人类思维模式,从而产生了类似的“语言交织”现象。这不仅反映了语言的认知复杂性,也增添了研究多语言AI模型时新的挑战与机遇。 值得注意的是,多语言推理的出现并非广泛存在于所有模型,而主要观察于训练数据丰富且多元、推理路径被直接曝光的高阶模型。普通用户与低阶应用中看到的结果,大多会经过多轮过滤以确保语言的统一和连贯。未来,如果开放式推理轨迹成为常态,如何平衡模型思维的多语言真实性与用户体验的统一感,将是AI发展必须面对的重要课题。 此外,跨语言推理也启示了模型性能优化的新思路。

不同语言在表达特定知识、数学问题、情感细腻度等方面具有差异优势。理论上,利用多语言模型切换语言优势,可以让AI在不同领域知识的表示与推理中更加灵活和高效。对于国际化应用与本地化服务,这种多语言能力更是一大技术红利。 然而,这也带来了监管与伦理层面的复杂问题。模型在未经过严格语言一致性验证的条件下输出多种语言,可能导致用户困惑,甚至引发误解。尤其是在医疗、法律等高风险领域,语言准确性和统一性关乎用户的切身利益。

如何在多语言灵活性与输出安全性之间寻求合理平衡,是业界亟待突破的难题。 总的来说,OpenAI及其同行的语言模型在推理过程中偶现非英语“思维”的现象,既是多语言训练数据和技术设计的必然产物,也是AI理解和表达语言多样性的真实体现。作为研发者和使用者,应当认识到这种现象背后的复杂性和多维度价值,同时推动更完善的管理和优化机制。未来,随着模型能力持续提升和多语言资源进一步丰富,这种语言交织的“AI思维”可能成为智能系统构建更深层次理解和创造力的重要基石。