在现代分布式系统中,gRPC作为一种高性能远程过程调用框架,因其支持多语言、基于HTTP/2协议以及高效的流控机制,成为微服务架构中的通信中坚。尤其是在高性能数据库和大规模服务集群中,gRPC被广泛用于实现服务间的高效交互。然而,尽管gRPC被广泛认为是一套性能优异的通信方案,实际应用中依然存在许多令人意外的性能瓶颈,尤其是在低延迟、高带宽的网络环境下,客户端性能问题尤为突出。本文旨在深入探讨这类瓶颈的根本原因,并结合具体的微基准测试,分享改进建议,助力开发者优化gRPC客户端的表现。首先需要明确,gRPC基于HTTP/2协议设计,支持多条并发流(streams)复用在单一TCP连接中。客户端通常创建一个或多个Channel,每个Channel代表一条TCP连接,多个RPC请求可以共享这些连接的带宽和资源。

然而,现实情况并非如此简单。官方的最佳实践指出,每条TCP连接的并发流数量有限制,默认通常为100个并发stream。当活跃RPC达到或超过该限制时,新请求会被迫排队等待,产生请求延迟增加和吞吐瓶颈。这一限制对于高负载或长连接Streaming场景尤其敏感。YDB团队在实践中发现,当他们尝试使用较少的集群节点降低资源时,客户端请求延迟反而持续上升,集群负载难以提升,闲置资源逐渐增多。这明显不是服务器端瓶颈,而是客户端侧的限制。

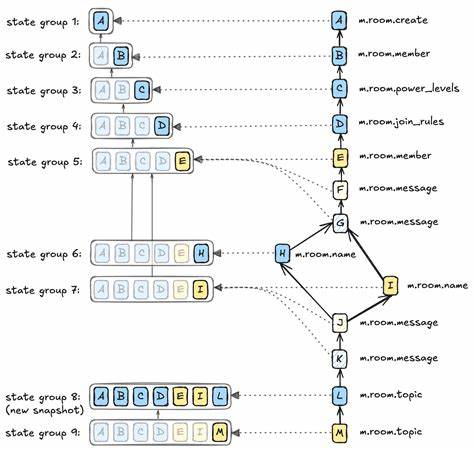

进一步的调试发现,无论启动多少并发请求,所有的gRPC Channel都会共享同一个TCP连接,导致这些请求受限于同一个连接的并发streams上限,从而形成了不可预期的瓶颈。通过一款基于最新gRPC版本(v1.72.0)的C++微基准测试工具,团队模拟了大量并行请求的ping-pong延迟测试,结果显示,吞吐量和延迟并未达到理想的线性增长,延迟随并发数量增加呈现线性上升趋势,且单一连接在高并发下表现欠佳。进一步通过工具检测确认,所有gRPC Channel默认使用了相同的TCP连接,流量实际上被复用到同一条连接上,成为性能瓶颈的根源。网络层面的分析排除了网络拥塞、TCP窗口限制、Nagle算法及延迟确认等问题,确认瓶颈集中在客户端gRPC层面。面对这一问题,常规的解决思路有两种:一种是为不同的高负载场景创建独立的Channel,确保TCP连接相互隔离,另一种是维护一个多Channel的连接池,将请求分散到多个TCP连接上。实际测试中,单纯创建多个Channel却使用相同的配置参数依旧导致连接复用,不能有效解决问题。

唯有为每个Channel设置不同的参数,如在客户端设置GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL参数,或针对每个Channel指定不同的用途标记,才可保证每个Channel独享一个TCP连接。这样做后,基准测试结果显著提升,吞吐量提高了近6倍,延迟增长明显放缓,效果堪称质的飞跃。进一步测试还表明,当网络延迟较高(如5毫秒RTT)时,客户端瓶颈影响不明显,延迟主要取决于网络本身,说明该瓶颈主要在低延迟环境下显现。结合以上发现,开发者在设计gRPC客户端时应重点关注连接复用策略,避免大量请求竞态于单一TCP连接的并发流上限。建议为性能关键业务创建专属Channel,或实现多Channel池化,并确保不同Channel参数唯一,以阻止连接重用。除此之外,合理利用gRPC的异步API,结合操作系统的线程亲和性设置(如NUMA节点绑定),也有助于最大化硬件资源利用率和降低调度延迟。

更进一步,监控TCP连接状态和流控窗口等网络指标,可辅助及时发现潜在的瓶颈和质量下降。对于业务规模持续扩展的场景,这种客户端主动优化策略书写了有效维护高性能分布式系统的保证。本文以YDB团队的实践为例,揭示了gRPC客户端在理想网络环境下容易忽视的瓶颈,并给出了可复现的基准测试与针对性解决方案,为业界提供了重要参考。未来,随着通信协议和框架不断进步,gRPC生态或将推出更智能的连接管理策略,自动优化多Channel多连接的负载均衡。与此同时,业务方也应主动评估自身gRPC客户端设计,结合网络环境与访问模式,合理调整连接复用与流控配置,在持续提高吞吐与降低延迟之间找到最佳平衡。总而言之,理解并规避gRPC客户端连接复用导致的性能瓶颈,是实现低延迟网络中高负载应用性能爆发的关键。

在分布式数据库、大规模微服务或实时通信等领域,这一优化尤为重要。期望本文内容能为广大开发者与系统架构师提供实用启示,推动gRPC在更多高性能场景的成功应用。