随着人工智能技术的迅速发展,基于大型语言模型(LLM)的检索增强生成系统(Retrieval-Augmented Generation,简称RAG)正成为知识问答及信息检索领域的重要支撑。RAG系统通过结合先进的检索技术与强大的文本生成能力,实现了在海量知识库中快速定位相关信息,并生成准确且上下文关联的答案。然而,RAG的复杂性也带来了评测难题——如何科学、公正地衡量它的检索效果与生成质量,成为业内亟需解决的关键问题。评测不仅关乎学术研究的进展,更直接影响实际应用中系统的用户体验与性能优化。 评估RAG系统牵涉两个核心组件:检索模块与生成模块。检索模块负责从庞大文本库或知识库中筛选出相关信息,考量指标通常围绕召回率、精准率等信息检索领域经典指标展开。

而生成模块则负责根据检索结果,结合自然语言理解与表达生成最终回答,其评估要点则聚焦于答案的正确性、可信度、连贯性以及是否存在幻觉信息(hallucination)。认证一个高质量的RAG系统,必须综合两部分性能,确保检索结果不仅涵盖必须信息,且生成输出在语义和事实方面均保持高度一致。 目前,业界和学术界围绕RAG系统构建了多种评测基准。各基准针对不同应用场景和难点设置了专项的测试集和指标体系,涵盖领域跨度广泛,包括电商产品搜索、学术论文检索、生物医学查询、财经体育问答、时效性极高的“新鲜”知识追踪、多轮长对话记忆与模态融合等。每个评测基准均在模型能力的某个重要维度深入考察,形成了可供开发者选择针对性测试的丰富生态。 斯坦福STaRK基准通过对半结构化知识库的查询,检验模型对结构化数据与自由文本交互的理解能力。

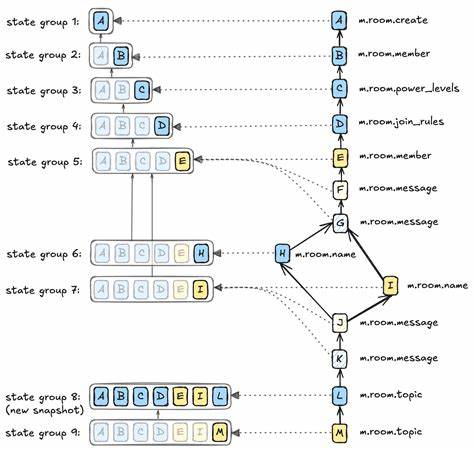

电商产品、学术文献及生物医药领域的交叉场景,强调实体检索的回忆精度,极大地贴近实际企业知识库问答需求。尽管STaRK聚焦于实体检索环节,未直接评估生成答案的流畅及准确性,但为优化检索精度和索引策略提供了坚实工具与公开排行榜。 Meta推出的CRAG基准旨在模拟多领域、多类型的真实问答任务,涵盖时间敏感事实、多跳推理及假设检验等高难度用例。其通过模拟网页检索与知识图谱访问,强调端到端系统的整体准确度和防幻觉能力。CRAG融合多样问答类型的挑战,是检验RAG系统综合能力的黄金标准,且因其开放且活跃的排行榜,为竞赛与迭代优化提供了极大便利。 Facebook AI的KILT基准贡献了一套基于单一维基百科快照的知识密集型任务合集,涵盖开放域问答、事实验证、实体链接及知识驱动对话等多种任务。

KILT特色在于通过统一格式及指标,严苛要求检索与生成共击中目标资源,实现事实依据充分且准确。这为学术研究与多任务模型现状对比提供了广泛且标准的参考框架。 在时间敏感性评测方面,FreshQA的贡献尤为突出。它设计的动态问答数据库,与不断更新的事实信息同步,专注评估LLM及时获取最新知识的能力。FreshQA劈开了纯语言模型与检索增强模型之间的性能差距,正是检验RAG系统实现实时知识更新和减少过时错误表现的重要利器。 面向实际部署时,RetrievalQA为适配检索调用的智慧决策提供了专门基准。

兼顾何时利用外部信息与何时依靠模型固化知识,针对不同问题适当调用检索,既提升准确性又节约响应时间和成本。此类能力对于商业场景中的高效响应尤为关键。 另外,LoCoMo长对话记忆基准检测系统在多轮、多会话、甚至跨媒体交互中记忆持久性和一致性的表现。它不仅考察模型跨越数百轮聊天时的准确回忆,还评估多模态内容理解,揭示长时间跨度内RAG系统的薄弱环节与记忆遗忘问题,有助于开发更健壮的智能助理产品。 RAGTruth则针对生成内容中的幻觉问题提供了详尽的人工注释数据。其细粒度词级标注与多模型多任务覆盖,为纠正与检测生成中的不可靠信息奠定基础。

在医疗、法律等对真实性要求极高的领域,借助RAGTruth检测和降低幻觉,是保障系统可信度的必备环节。 为了高速高效地评估RAG系统,工具与框架层面的发展同样重要。RAGAS为RAG开发者量身定制了一套集成的评测工具,涵盖信赖度、语义相似度、文档召回等多个维度,还附带合成测试集生成,极大降低没有标注数据时的评测门槛。其支持与主流开发框架联动,简化部署流程。 而Open RAG Eval则摒弃了对固定答案的需求,通过先进的LLM判分技术,无需人工标注即可实现大规模自动化性能评估。其提出的UMBRELA及AutoNugget等新型指标,支持细粒度检索结果评分和答案事实覆盖率,助力系统在线监测调整,尤其适合多样化、无参考答案的真实业务环境。

DeepEval由Confident AI打造,专注于将评测集成进开发测试流程,以单元测试形式对检索和生成进行分离检查。其灵活定制、模块化结构和对持续集成极高的适配度,为开发者打造稳健可靠的迭代闭环提供了保障。通过每次更新均执行回归测试,可以预防性能倒退,确保系统稳定提升。 未来,随着RAG系统在智能客服、个性化推荐、知识管理等多个领域大规模落地,评测方法及指标还将持续进化。多任务、多模态、多语言的支持将更加丰富,动态知识图谱与自我学习能力的加入考验新型评测手段。融合人类评审与自动化判分的混合评测流程有望成为主流,保障评估的科学性与经济性兼顾。

总之,要想打造优秀的RAG系统,选择合适的评测基准和工具至关重要。基于应用场景定位,合理搭配Stanford STaRK、Meta CRAG、Facebook KILT、FreshQA及更细分的RetrievalQA或LoCoMo等基准,可以全方位覆盖检索准确性、生成质量、时效性及记忆力等维度。同时结合RAGAS、Open RAG Eval、DeepEval等评价框架,形成研发到生产的闭环监控体系,才能确保系统表现稳定且持续提升。通过系统的评测设计,研发者不仅能清晰定位性能瓶颈,更能针对弱点实施定向优化,推动RAG技术迈向更高水平的实用价值和用户满意度。随着相关开源工具和数据集不断完善,RAG系统的评估将变得更加科学、精准、高效,助力未来智能问答和知识管理领域的飞速发展。