在人工智能领域,特别是生成式模型的应用中,Stable Diffusion XL(简称SDXL)因其卓越的图像生成能力成为研究和开发的热点对象。然而,想要对SDXL进行微调以适应特定需求,不仅技术难度大,还可能面临巨额成本投入。本文将深入揭示一段关于微调SDXL的真实经历,由于缺乏合理规划和技术准备,导致了近一万六千美元的高额开销与失败的尝试,从而为广大从业者提供宝贵的借鉴和警示。微调SDXL的核心目的在于让模型能够更准确地理解和生成特定领域或风格的图像内容。这个过程涵盖数据准备、训练参数设定、硬件资源配置和后期调优等多个环节。首先,数据采集和预处理是基础。

为确保训练效果,需要大量高质量、标注精准的图片数据集。然而收集这样的大规模数据本身就是一项庞大工程,如果数据质量不佳或样本多样性不足,训练结果将大打折扣。缺乏对数据样本分布的深入分析和清洗,容易使模型陷入过拟合或生成内容重复的问题。其次,合理配置训练环境与参数尤为关键。SDXL模型规模庞大,对显存和计算能力的要求极高。选择不合适的显卡或云计算实例将直接导致训练时间延长,费用攀升。

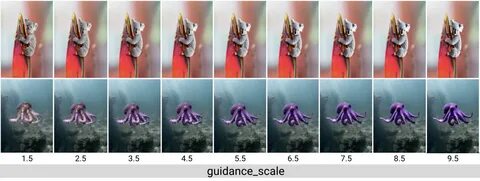

由于模型结构复杂,调参过程中需要反复试验学习率、批处理大小和优化算法等超参数,稍加不慎就可能导致训练不收敛或者性能回退。许多微调者在缺乏充足理论知识和实践经验的情况下盲目尝试,造成资源极大浪费。此外,使用云服务进行训练虽然方便灵活,但费用高昂且计费方式复杂。没有细致的成本预算和监控,容易在数小时或数天内就超出预期支出。对训练作业的管理不到位,未能及时中断效率低下的任务,也是资金流失的重要原因。除了硬件与成本问题,微调过程中技术细节的忽视常常被低估。

例如,模型保存的频率设置不合理,可能导致关键训练阶段的参数丢失;没有采用适当的早停策略,允许训练持续到过拟合阶段;缺乏对生成结果的持续评估和反馈机制,误判训练效果,使时间和资金投入继续增加。所有这些问题积累起来,最终可能让原本仅需数千美元的预算变成一万六千美元甚至更多的投入,却得不到理想的模型性能提升。案例中,通过多轮尝试微调脚本、调整参数和优化数据集,最终发现早期训练作业因显存不足导致模型不完整保存,许多时间浪费在无效迭代上。部分云计算服务的计费规则不透明,也加剧了支出失控的风险。面对这些困难,经验丰富的专家往往建议先进行小规模的预实验,通过局部微调和快速迭代掌握关键参数,再逐步扩展训练规模。此外,合理规划训练时长,监控计算资源使用,及时终止低效任务,有助于控制成本。

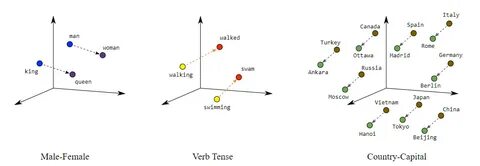

利用开源工具和社区分享的微调脚本,也能规避重复造轮子的问题。近年来,针对大模型微调的技术不断进步,如参数高效微调(PEFT)和LoRA(低秩适配)等方法,使得训练成本大幅降低,效果更加稳定。采用这些方法不仅节省显存,还能缩短训练周期,减少资金投入。尽管如此,努力掌握基础知识,结合具体需求制定个性化方案,依然是避免浪费不可或缺的环节。微调SDXL不仅是技术挑战,更是对项目预算和时间管理的考验。通过深入理解模型结构、数据质量和训练流程的关系,可以提升整体效率。

在投入资金和时间之前,进行详细的方案评估和风险分析,往往能避免因盲目扩展而导致的巨大经济损失。总结来看,这次一万六千美元的教训提醒所有AI开发者和研究者,微调大型生成式模型绝非简单复制训练流程,必须聚焦细节,精细规划,结合先进策略进行操作。通过科学的方法论、合理的实验设计和严格的成本控制,才能实现微调SDXL的高效成功,使其在各自应用领域发挥最大价值,避免陷入无底洞般的资金和时间消耗。未来,随着技术的进一步成熟和工具的不断完善,微调大型模型的门槛将持续降低。希望这段经历能够为推动AI领域技术普及与创新,贡献一份真切的参考。