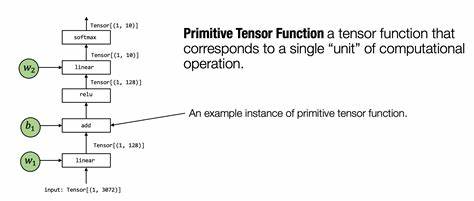

在人工智能领域,尤其是大型语言模型(LLMs)和深度神经网络不断发展的当下,计算密集型的张量算子占据了模型整体运算量的90%以上。张量算子作为深度学习框架中的核心组成部分,其性能优劣直接影响模型的训练和推理效率。随着硬件生态的持续多样化,从通用CPU架构(如RISC-V和ARM)到专用GPU及加速器,如何充分利用硬件底层原语,高效生成高性能张量算子,成了业界亟待解决的技术难题。传统的手工优化不仅耗时长、成本高,还难以充分挖掘新兴硬件的潜力。近期由QiMeng-TensorOp提出的自动生成张量算子的技术,正以其独特优势打破瓶颈,让复杂硬件特性与高层语言代码的桥梁变得简单而高效。张量算子涉及矩阵乘法、卷积和各种张量变换操作,是深度学习计算的基础。

由于硬件架构的差异,这些操作在不同设备上的最优实现大相径庭。开发者需要针对具体硬件进行深入分析,基于硬件的指令集和并行原语,设计符号化且高度可调的张量算子代码。单凭传统编译器优化,难以达到人类专家的手工调优效果,特别是在新硬件生态迅速变化的环境中更显艰难。尽管现有大型语言模型(LLMs)在编程辅助方面展现出较强的能力,但它们缺乏深入理解硬件特性和高性能计算的能力,难以生成性能优越且资源高效的张量算子。为此,QiMeng-TensorOp框架应运而生,它结合人工智能和硬件知识产权,利用LLMs的自然语言理解优势,实现以简洁的一行用户提示,自动生成针对多样硬件平台的高性能张量算子代码。QiMeng-TensorOp并非仅仅生成代码,更通过硬件原语和架构特征驱动的自动调优,极大地挖掘了硬件计算潜力。

该框架自动识别具体架构支持的指令集和并行执行单元,生成包含适配多线程并行、SIMD指令以及低级内存访问策略的优化代码,从而达到或超过人工专家与主流库的性能。大量实验数据验证了QiMeng-TensorOp的卓越性能和实用价值。针对RISC-V CPU,生成的张量算子比传统OpenBLAS实现性能最高提升达到251%。在NVIDIA GPU平台上,性能甚至超过了cuBLAS库124%。更值得关注的是,与传统手工优化相比,QiMeng-TensorOp将开发时间缩短了200倍,使得开发者无需长时间深入底层硬件细节,便能快速获得适配性强且高效的算子实现。这种自动生成和调优机制不仅极大地降低了开发成本,也满足了深度学习模型日益增长的硬件适配需求,在云端、边缘计算以及多样异构设备场景均展现了广泛的应用潜力。

在软件生态层面,QiMeng-TensorOp的出现预示着深度学习算子开发进入了一个全新的阶段。开发者通过自然语言描述即可快速定义需求,背后的系统自动结合硬件原语,生成带有底层优化的高性能代码。此模式打破了传统依赖专家知识的壁垒,使得算子适配成为一种可复制、易推展的智能化流程。此外,QiMeng-TensorOp支持持续自我迭代与优化,结合硬件反馈自动调整算子参数,保证性能随硬件更新而进步。这对于未来多样硬件架构的支持尤为关键。从更广阔的视角来看,张量算子自动生成技术是推动AI算力进步的关键驱动力。

随着模型规模飞涨,单纯靠硬件堆叠提升性能的成本越来越高,软硬协同的高效利用变得日益重要。QiMeng-TensorOp通过智能化的代码生成和硬件感知调优,不仅提升了当前算力效率,也为面向未来新兴硬件架构的深度学习应用打下了坚实基础。未来,更多创新型框架将基于此理念,结合神经网络搜索、硬件原语自动提取和自适应编译,形成张量算子开发的全链路智能生态体系。与此同时,随着边缘计算、IoT设备及定制化加速芯片的兴起,对于自动化、高性能算子生成的需求将进一步扩大。QiMeng-TensorOp的成功表明,智能化开发工具能够帮助科研和工业界迅速缩短开发周期,解放人力资源,将更多精力投入模型创新和算法研究层面。总结而言,利用硬件原语自动生成高性能张量算子,是未来深度学习计算优化的重要方向。

QiMeng-TensorOp作为这一技术趋势的典范,充分利用LLMs对自然语言的理解能力与硬件底层特性的结合,实现了性能与开发效率的双重突破。其显著性能提升和成本降低不仅极大推动了张量算子生态的发展,也为AI算力进化提供了新思路。随着人工智能应用的复杂性和多样性持续增长,自动化、高效且可扩展的算子生成框架势必成为推动数字智能时代前行的核心引擎。