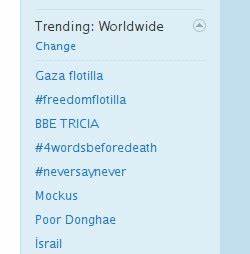

2010 年 5 月末,围绕一支驶向加沙的人道主义援助船队发生的冲突迅速成为全球关注的焦点。社交媒体,尤其是 Twitter,成为第一时间传播现场信息、组织讨论和表达声援的重要场所。在事件发生后的数小时内,带有 #flotilla 标签的推文大量涌现,一度在趋势话题列表中名列前茅。但令人惊讶的是,#flotilla 话题在短时间内从趋势中"消失",随之引发了大量用户对 Twitter 进行审查的质疑。对那次事件的深入梳理,有助于厘清算法过滤与人为审查之间的界限,并反思社交平台在公共舆论生态中的责任与透明度。 事件经过可以用几个关键节点来描述。

早晨大量用户开始使用 #flotilla 标签发布现场信息和观点,标签迅速上升为趋势话题。当许多用户通过常规搜索链接试图查看相关推文时,部分搜索结果显示"Twitter error",导致用户无法通过预期的方式获取信息。与此同时,另一标签 #freedomflotilla 快速取代并进入趋势列表,显示相关讨论并未完全消失。随后媒体报道与技术分析大多指向平台算法或技术故障,而非有意的人工删除或政治动机的审查。Twitter 官方后来也发布说明,称当时确实出现技术问题,影响了搜索结果的显示,并已修复该错误。 为何会出现这种"消失"?理解其背后的技术机制比简单地指责审查更有帮助。

首先,要认识到社交平台的趋势功能并非单纯列出使用次数最多的标签,而是由复杂的算法驱动,这些算法会考虑标签出现的速度、增长率、地理分布、历史背景和潜在滥用模式。平台必须在鼓励真实信息传播与防范垃圾信息、操纵行为之间取得平衡。大量突然涌入的相同标签可能被算法视为人为操控或垃圾信息,从而触发反滥用机制,临时降低该标签的可见性或从趋势列表中剔除以保护用户体验和系统稳定性。 其次,实时搜索和趋势统计对系统性能有巨大压力。一次突发事件往往伴随海量请求,服务器、缓存和索引系统可能面临短暂的过载。某些搜索路径或接口可能因为并发请求过高而返回错误信息,而其他经过不同处理流程的接口则仍能显示结果。

2010 年的情况中,使用高级搜索或第三方工具如 Trendsmap 的用户仍能看到 #flotilla 的讨论,说明数据并未被全面删除,而是部分搜索接口遭遇问题或被反垃圾机制误判。 再次,误判的可能性不容忽视。反垃圾或反滥用系统通常会利用历史数据判断标签是否为"主题接管"或垃圾活动。若某标签在短时间内出现方式类似于之前已知的垃圾行为,算法可能会误将其归入黑名单或降低权重。Guardian 的报道提到,当时恰逢其他名为"flotilla"相关话题在近期出现,使得系统产生混淆成为可能。机器学习模型在面对新出现的大规模真实事件时,尤其容易出现这种误判。

从法理与公共政策角度看,算法驱动的"非人工"过滤是否构成审查,取决于对"审查"定义的理解。如果审查强调的是有意图的、由人或组织授权的压制行为,那么因算法误判或技术故障导致的话题下线更接近于意外而非有意压制。但从公众感知层面来看,结果是相同的:信息传播受阻,受影响的群体可能会将其视为平台偏见或政治干预。社交平台作为公众信息基础设施,其行为无论出于何种原因,都必须承担相应的信任与透明性成本。 该事件也揭示了社交媒体时代一个更深刻的问题:算法透明度与问责机制的缺失。用户面对算法决定往往一无所知,平台并不总是公开解释为什么某个话题会被屏蔽或降权。

虽然平台在保护对抗滥用方面需要一定程度的保密,但完全不解释只会加剧公众对审查的怀疑,削弱平台的公信力。2010 年之后,关于算法透明度的呼声逐渐增多,监管、学界和媒体纷纷要求平台提供更多可解释性、第三方审计和清晰的上诉机制。 此外,技术性"误伤"经常被赋予政治含义,尤其在涉及冲突、外交或人权议题时更为敏感。以色列与巴勒斯坦冲突长期是全球政治舆论热点,任何平台对相关话题的处理都会被高度放大并赋予政治意义。用户的情绪反应符合人类对不确定性和信息控制的敏感性:当他们无法通过惯常渠道获取信息时,第一反应往往是怀疑平台隐瞒或操控。媒体对此类事件的报道也会在公众理解中起到放大或缓解作用。

Guardian 的及时报道在当时起到了澄清部分事实的作用,指出技术故障与反垃圾机制的可能性,帮助公众从更全面的角度分析问题。 从更广的历史视野看,2010 年的 #flotilla 风波并非孤例。随后的多年里,社交平台在遭遇突发事件时屡次出现算法误判或短暂信息中断的情况。不同之处在于,公众与监管的回应日趋强烈。平台被要求更积极地发布透明度报告,公布内容审查请求统计,甚至建立独立监管或上诉委员会。学术界也开始关注算法治理与数字宪章,探讨如何在保护言论自由与防范滥用之间找到制度性平衡。

对普通用户而言,如何在类似情境中评估信息是否被"审查"?一个可行的思路是多渠道交叉核验。若某标签在主流平台异常消失,仍可尝试通过第三方显示工具、高级搜索、其他社交网络或主流媒体来确认事件真实性。对媒体从业者与公众信息组织来说,建立快速反应机制以记录和保存突发事件的第一手材料也非常重要,以免因平台故障导致关键证据丢失。 对平台方的建议包括:在设计反垃圾和趋势算法时应加入更完善的审查日志与可解释性机制,允许被降权的话题通过自动通知或人工复核来复原。建立用户可见的上诉通道,让受影响群体能迅速获得解释和救济。同时,定期发布透明度报告,详细说明内容降权、删除和审查请求的原因与数量,从而提高公众信任。

监管层面需要慎重平衡。简单的政治干预或强制性审查可能损害言论自由与创新活力,而完全放任平台自律又无法保障公众知情权。更合理的路径是设定清晰的规则边界,要求平台在内容治理中遵循程序正义原則,提供透明的决策流程与独立的监督机制。学术界与民间组织也应参与到审计与标准制定中,帮助构建多方监督的治理结构。 回到 2010 年的个案,结论相对明确:没有确凿证据显示 Twitter 在当次事件中进行了有意的人为政治审查。更可能的解释是技术故障或反垃圾、反操纵算法在面对突发、大规模真实话题时的误判。

尽管如此,事件所暴露的问题并未随时间消失。社交平台在突发事件中承担的信息分发角色使得任何算法决策都有可能带来深远影响,从而要求更高的透明度、问责和用户救济渠道。 展望未来,随着人工智能与算法治理的发展,社交平台需要在技术改进与制度创新之间找到新的平衡点。提高算法的可解释性、推广第三方审计和建立多元监督机制是可行的方向。公众也应提升数字媒介素养,学会在信息碎片化时代通过多源验证来判断事件真相。只有平台、监管者与公众共同努力,才能在信息传播的高速公路上既保证言论自由,又减少因算法误判带来的不良后果。

#flotilla 事件虽已过去十余年,但其讨论具有持久价值。它提醒我们,技术并非中立,算法决策会产生社会后果;同时也表明,立即将每一次技术故障等同于政治审查并不利于问题的理性解决。面对未来的类似挑战,应以事实为依据、以制度为保障,推动更透明、更可信的信息生态建设,从根本上提升公众对数字平台的信任与依赖。 。