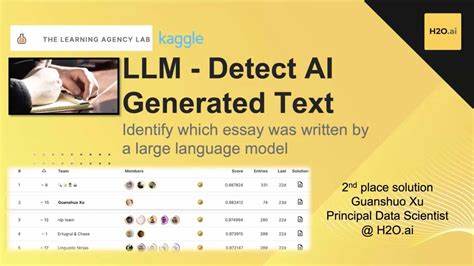

近年来,人工智能领域的突破引发了学术界的深刻变革。尤其是大语言模型(LLM)如GPT系列的出现,使得自动生成高质量文本变为可能。这一进步既带来了机遇,也带来了挑战。学术论文和同行评审环节作为科研成果传播与质量保障的重要阶段,正逐渐暴露出人工智能生成内容的广泛存在及其带来的潜在影响。学术界对这一现象的关注日益增强,因此,采用专门的AI工具来检测并识别LLM生成的文本,对维护学术诚信尤为关键。 首先,学术论文的原创性和真实性一直是学术研究的生命线。

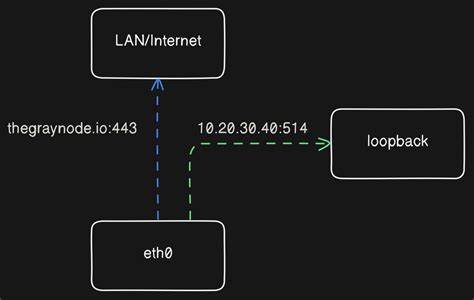

然而,随着AI生成工具的便利性和普及,部分作者可能选择使用大语言模型协助甚至替代传统写作过程,这不仅会掩盖作者真实的思考过程,还可能影响论文的科学价值。虽然许多期刊已出台政策,规范AI工具的使用,要求作者在使用相关技术时进行公开声明,但实际操作中,作者和评审者未必遵守这些规定,导致学术管理者难以准确追踪内容来源。 针对这一难题,专业开发的AI检测工具应运而生。通过分析文本的语法、句式结构、语义一致性以及可能的模式特征,这些工具能够有效区分由人类撰写和机器生成的内容。借助机器学习和自然语言处理技术,检测工具不断优化,以适应不断演进的大语言模型,使得学术期刊和研究机构能够更准确地鉴别潜在的AI生成文本。 当下的检测工具不仅在精准度上取得显著突破,也极大地提升了检测效率。

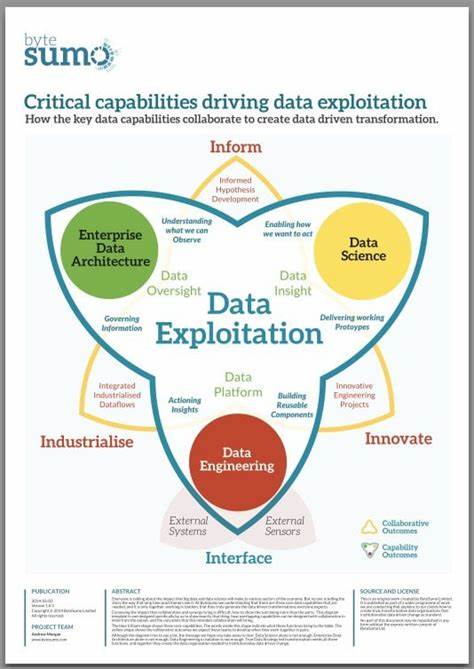

以往人工审核文本既费时又可能存在主观偏差,现在借助AI检测技术,可以在海量的稿件中快速筛查异常文本,促进学术质量监管的数字化转型。此外,在同行评审环节,AI生成的评审意见也开始频繁出现,这带来了新的伦理和实务挑战。部分评审者使用AI辅助生成评审内容,虽然能够提高评审效率,却难以保证评论的深度和个性化,可能影响评审的公正性和有效性。 高校和科研机构开始引入AI检测系统,结合内部管理和学术规范培训,加强对研究人员和评审者的指导与约束。通过透明公开的AI使用政策,将检测结果反馈给相关方,形成正向激励和监督机制,从根本上减少未经披露的AI文本产生。与此同时,学术界也在积极探讨AI与人类协同创作的新范式,试图找到技术赋能与伦理标准之间的平衡点。

然而,AI检测同样面临诸多挑战。大语言模型不断升级,其生成文本的自然度和多样性大幅提高,检测工具需要持续迭代以保持识别能力。不同学科的语言风格和技术表达存在差异,单一检测模板难以满足所有需求。此外,检测结果的误判风险可能引发学术争议,如何建立科学合理的鉴定标准和申诉渠道,是学术共同体需要共同攻克的问题。 从宏观角度看,AI检测技术推动了学术出版与审稿流程的深度改革。期刊编辑部利用检测数据优化稿件筛选和专家匹配,提升出版质量。

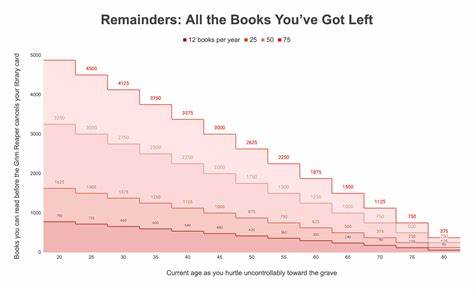

学术机构通过AI辅助评估科研产出,推动透明诚信的科研文化建设。政策制定者也应关注制定针对AI使用的明确法规,保障科研环境的公平有序发展。 未来,随着人工智能技术的不断演进,AI生成文本的检测将不仅局限于识别写作内容,还将拓展到图像、数据、实验结果等多模态信息领域。跨领域合作和国际间标准统一将成为推动检测技术提升的关键。学术界必须保持开放与警觉意识,积极拥抱技术进步的同时,严格把控学术道德防线,确保科学创新的可信度和价值。 综上所述,人工智能检测工具在学术论文和同行评审中识别大语言模型生成文本,已成为维护学术诚信的必备利器。

它不仅助力期刊和研究者识别潜在的虚假内容,防止学术不端行为的发生,也推动了科研管理的现代化和智能化转型。只有多方协作,建立完善的规范体系和技术手段,才能真正发挥AI检测的最大效用,促进科学事业的健康可持续发展。 。