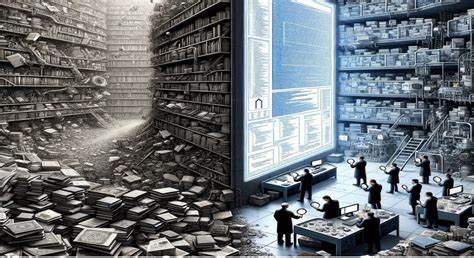

在当今数字时代,大型语言模型(LLMs)如ChatGPT、Claude、Gemini等迅速成为人们获取信息、解决问题的强大工具。它们能够在短短几秒钟内回答复杂问题,帮助用户节省大量时间。然而,当专家或熟悉某一领域的用户深入探讨相关细节时,模型的回答往往会显得不那么精准甚至充满错误。然而,随即提问其它领域又会再次感受到其惊人的智能水平。这一现象令人不禁联想到作家迈克尔·克莱顿提出的“盖尔-曼失忆效应”,即人们在熟悉领域发现媒体报道错误时会产生怀疑,可转而对其他领域的报道照单全收,忘却先前的怀疑。大型语言模型也似乎成为了这种效应的终极载体。

盖尔-曼失忆效应最初描述的是人们面对报纸报道时的矛盾心态。当读者在自己熟悉的专业领域看到显然错漏百出的内容时,会产生失望甚至质疑对方的知识水平。然而当他们翻到其他不熟悉的版面时,却会自然而然地相信那些信息的真实性,把之前的怀疑抛诸脑后。这种心理机制在信息爆炸、真假新闻交错的当代社会尤为突出。大型语言模型作为汇聚大量互联网文本信息和人类知识训练的产物,也展现出类似特征。当面对某个细分领域的问题时,它可能因为训练数据质量参差不齐或缺乏深入上下文理解而出现偏差。

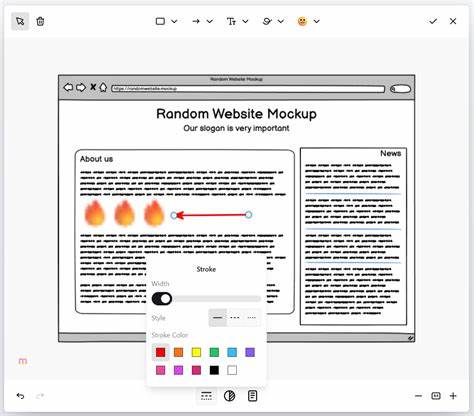

此时,拥有专业背景的用户会迅速识别错误,降低对模型的信任度。但当问题转换到自己不熟悉的领域时,模型的回答看似合理,用户便又恢复信任,形成一种反复的信任“波动”。 这种失忆机理对不同身份和技能水平的用户意义不同。经验丰富的开发者、工程师能够在使用LLMs进行“氛围编码”(即让模型自动生成代码)时,意识到模型生成代码的局限,主动校正或引导其输出,从而达到提高工作效率的目的。通过批判性地审视模型产出,他们既享受了快速产出的便利,又避免陷入错误或低质量代码的困境。相反,缺乏相关背景知识的普通用户则难以辨识模型错误,极易把浮夸的结果误认为是科技颠覆性的奇迹,盲目崇拜或产生不切实际的预期,甚至可能在关键场合做出错误决策。

LLMs所体现的盖尔-曼失忆效应为我们重新审视人工智能的角色和局限性提供了深刻启示。机器学习模型并非“全知全能”,其回答依赖于训练数据的广度与深度,也受限于自然语言处理技术本身。人类应当保持理性和怀疑精神,尤其是在涉及细节和专业知识时,结合自身判断力对模型生成的内容进行甄别确认。与此同时,模型开发者也需不断优化训练策略,提高模型对专业领域知识的准确理解与表达能力,减少误导性信息的产生。 此外,这一现象提醒企业和技术创新者,盲目依赖自动化、智能化工具可能带来潜在风险。只有具备必要专业知识和辨识能力的用户,才能充分发挥AI助手的辅助作用。

培训和普及相关技能的重要性不容忽视。从教育层面而言,也应强调信息识别和批判性思维培养,帮助大众在面对日益智能化的信息环境时,既能享受便捷也能保持清醒。 总的来看,大型语言模型作为“终极盖尔-曼失忆机”,既彰显了人工智能在信息处理上的巨大潜力,也暴露出因知识盲区导致的信任陷阱。它们加速了信息获取和创作的速度,正改变着人类的学习和工作方式,但同时要求我们更有智慧地与技术共处。明智地辨别其回答的准确性和适用范围,将有助于推动人工智能健康发展,确保技术红利惠及更广泛的人群。未来,期待技术不断进步,模型能够学习到更多细致入微的专业知识,减少误导风险,实现更智能、更可信的交互体验。

与此同时,用户的不断成长和自我反省将是利用人工智能真正创造价值的关键所在。