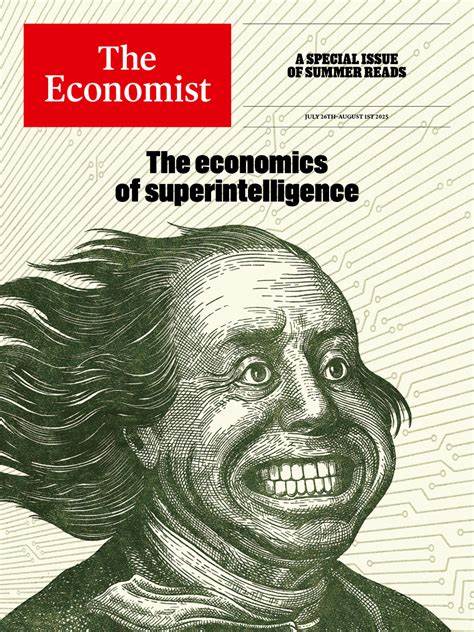

随着人工智能技术的日益成熟,世界各地的AI实验室正陷入一场“全有或全无”的竞赛中,目标是率先实现具备广泛能力的通用人工智能(AGI)甚至是远超人类智能的超级智能。尽管技术潜力不可估量,但这一竞赛带来的安全隐患同样令人担忧。众多开发者在明知风险的情况下,依然选择快速推进项目,反映出当前AI行业内存在的伦理与安全困局。近年来,人工智能的突破速度超出许多人的预期,从图像识别、自然语言处理到复杂决策支持,AI系统开始渗透到社会的方方面面。这些进步为经济发展和人类生活带来巨大潜力,但同样引发了关于技术失控和不可预见后果的深刻担忧。尤其是AGI的出现,它不仅能够替代大部分需要脑力劳动的工作,还可能具备超越人类的推理和创新能力,安全风险被进一步放大。

AI实验室内部对此的认识往往十分复杂。一方面,研发团队深知AI系统若失控可能带来的灾难性后果,另一方面,激烈的市场竞争和资本压力使他们无法停下脚步去充分审视和完善安全机制。安全的研究与测试往往被视为拖慢进度或削弱竞争力的因素,从而在激进的创新氛围下被边缘化。许多AI开发者已提出多种手段来约束和管理“失控”的AI模型,例如设定严格的行为限制、多层级监控和审计机制,甚至是设计内置伦理与价值系统。然而,在实际应用中,如何平衡创新速度与安全防护,却成为一大挑战。具备强大自主学习能力的AI模型可能在未预期情境下做出不可控反应,增加了安全治理的复杂度。

企业和研究机构之间的竞赛不单是一场技术较量,更是战略和资源的争夺。由于通用人工智能一旦实现,其深远影响将遍及经济、军事、社会治理等多个层面,谁先突破谁就掌握未来的主动权。从这个角度看,安全考虑常常被视为次要,谁也不愿意因为过度谨慎而在竞争中落后。公众和监管机构的声音逐渐提高,许多专家呼吁在AI发展过程中设立更严格的伦理标准和监管框架,避免盲目追求速度引发的灾难。然而,目前的政策和监管体系尚未能快速适应AI技术的变化,监管滞后效应明显。或许,我们亟需建立国际层面的合作与共识,通过透明的研究机制和多方参与的监督体系来促进AI技术的安全发展。

同时,真正意识到技术创新和安全保障是双轮驱动,缺一不可,才能推动AI行业走向可持续和负责任的未来。未来的人工智能若要造福人类,必须超越“盲目竞速”,在追求突破的同时,将安全放在核心位置。只有如此,我们才能避免因急于求成而埋下不可挽回的隐患,迎接一个更加智能且安全的时代。