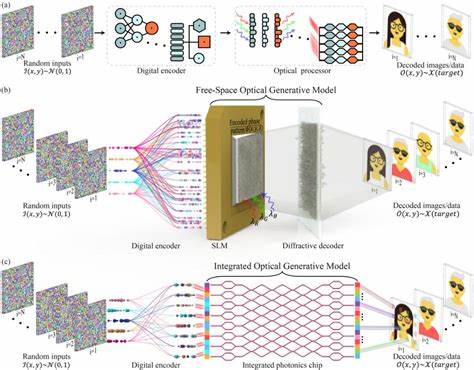

在大型语言模型的训练中,预训练步骤通常占据了绝大多数的计算资源,这使得选择合适的优化器成为提升训练效率的核心问题。近年来,随着深度学习技术的飞速发展,越来越多新颖的优化器被提出,声称能够带来显著的训练速度提升,尤其是与业界标准AdamW相比。然而,最新的研究表明,关于这些新优化器效果的宣传往往被过度夸大,核心原因主要源自基线模型调参不充分和未能在多样化环境中系统评估。这项由Kaiyue Wen等学者带来的研究通过细致严谨的三阶段调参方法,对包括AdamW在内的十一种优化器进行了统一、公正的比较,覆盖了从百万到十亿参数级别的多种模型规模和数据规模,推翻了许多广为流传的速度提升说法。该研究从根本上强调了公平基线调优的重要性,并为优化器benchmark设立了新标准。研究采用的调参流程极为细致,首先通过逐一扫描各超参数,找到针对小到中等规模模型的局部最优配置,确保每个优化器的表现都得到最大化发挥。

接着聚焦那些会随着模型规模和数据量变动的关键超参数,进行针对性优化,显著减少大规模调参成本。最后基于拟合的规模定律,将优化器参数推断至1.2亿参数规模,确保了结论具有前瞻性。该方法论上的严谨避免了许多以往研究中由于过早停止调参导致的偏差和误判。实验证明,在彻底调参后的AdamW基线表现远超未充分调优状态,能够带来近两倍的训练加速,缩小了与新兴优化器之间的性能差距。部分新式矩阵预调节类优化器,如Muon和Soap,在小模型和低数据规模下确实能够实现约1.4倍提速,但该优势随着模型和数据规模增长迅速减弱,甚至只剩约1.1倍的微弱提升。这表明,要想实现真正可扩展到大规模模型的优化器突破,现有方法仍有较大提升空间。

矩阵基优化器相较于传统的标量调整方法,能够在梯度更新中捕捉更复杂的几何关系,提供更精准的优化方向调整。针对不同数据与模型比例的训练场景,最优的优化器选择也有所不同,说明没有万能的解决方案,需要根据实际训练需求做出权衡。该研究还发现,不同优化器之间的超参数最优配置存在显著差异,简单地将其他优化器的参数直接套用至AdamW等基线优化器是不科学且不公平的,这呼吁研究者在未来进行优化比较时必须保证各优化器均经过充分而独立的调优。此外,早期训练阶段损失曲线的表现并不能可靠反映最终优化效果,多次排序翻转表明最终训练预算完成后的结果才是真正有效的评判指标,避免过早结论。当前的深度学习社区迫切需要更加严谨透明的评测标准和方法,避免陷入表面增益而忽视实质效能的误区。该论文以科学的"现实校准"姿态,推动了对深度模型优化器研究的理性认知,挑战了"快速进步"的宣传噱头。

未来优化器研发应更多聚焦于扩展性和训练稳定性的设计,确保在模型和数据大规模增长时依然维持显著优势。虽然本研究主要覆盖至十亿参数级别,但其严谨周全的方法论为后续更大规模模型的优化器评估提供了宝贵范例。研究结果也隐含了一种警示,简单地依靠复杂的预调节结构并不能立竿见影地取得大幅加速,深入理解训练动态和优化理论基础仍然不可或缺。对于工业界工程师而言,选择适合实际规模和预算的优化器,结合系统的超参数调优管线,是保障训练效率的关键。整个研究过程体现了严密的科学精神和实证主义态度,为社区树立了标杆。总的来看,预训练优化器的寻找之路依然漫长且充满挑战,唯有通过持续的努力和创新,方能实现深度学习训练效率的质的飞跃。

只有秉持严谨评估和透明分享的原则,才能真正发掘出"绝佳的预训练优化器",推动人工智能技术迈向更高峰。 。