随着人工智能技术的快速发展,许多开发者开始关注如何在本地环境中运行强大的AI模型,摆脱对云端服务的依赖,实现更高的隐私保护和成本控制。最近,一位开发者在一次长达七小时的飞行途中,进行了基于本地AI模型的离线编程实验,开启了对本地AI编程可行性的新思考。本文将深入剖析这次独特的实践经历,探讨本地AI编码的现实挑战与未来机遇。 这次实验的起因很简单 - - 在没有网络的漫长飞行中,如何利用时间进行高效、有趣的开发工作?带着这个疑问,开发者提前在机场休息室下载了13GB的AI模型数据,计划依托本地运行的AI助手,完成一个关于管理订阅服务的简单应用开发。整体流程搭建在熟悉的Next.js技术栈之上,融合了TailwindCSS、Zod和ts-pattern等前端工具,目的是避免因工具不熟导致额外的学习成本,将精力集中在AI编码体验上。 本地AI模型的选择过程充满了试错。

开发者尝试了Mistral的Devstral、Qwen3、Crush、OpenCode以及Ollama-code等多个方案,但只有gpt-oss模型经过OpenCode工具的支持后成功运行。在一台配置为MacBook Pro M4 Pro、搭载24GB内存的设备上,本地运行这一13GB的模型对性能需求相当高,也预示着当前本地AI开发的硬件门槛仍然较高。 应用选择了极为基础的订阅服务管理功能,涵盖添加、显示、编辑和删除订阅条目,使用浏览器本地存储作为数据持久层,设计之初便考虑了未来扩展至API或Supabase的可能。这种设计确保了实验环境的简洁,同时符合离线工作的要求。 在飞行途中,开发流程遵循"先规划、再实现、持续更新规划文件"的思路,以确保AI编程助手能够按步骤完成任务。令人惊喜的是,AI在功能规划阶段表现良好,仅需极少修改便获得认可。

这体现出本地AI模型在中低复杂度任务中的实用价值,尽管实现过程中速度明显低于云端高性能助手,约为后者的五分之一。 性能上的差距使得体验更显耐心,有时需要等待几分钟生成代码,虽然飞机上的娱乐设施提供了必要的分散注意力手段。此外,设备发热和能耗问题也出乎意料,笔记本电脑散发的热量使腿部感受明显,机舱内的插座输出功率不足以持续供电,迫使开发者不得不间断使用,依赖电池续航。这些现实问题提醒我们,当前本地AI编码的能耗控制还有待突破。 关于代码质量,本地AI表现大致可靠,但细节上的瑕疵依然存在。部分问题包括代码类型不严谨、UI组件丢失、ESLint警告等,修复这些问题往往需要多次迭代调整。

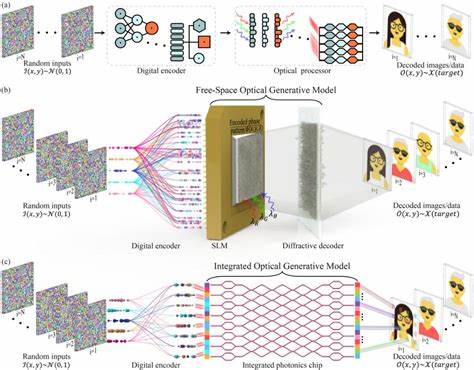

虽然AI能够自主纠正错误,但过程繁复且耗时,加之调试体验不如云端环境流畅,反映出现阶段本地AI编程辅助在成熟度和效率上的不足。 完成的应用虽简单,界面设计尚不完善,但功能完整可用。开发者在七小时的飞行中实际编码时间大约三至四小时,其余时间用于休息和娱乐,这种时间分配也让体验更接近现实办公场景。实验成果证明,借助本地AI模型,在完全离线的情况下,完成基础编程任务已非不可思议。 本地AI编码带来的最大自由感在于完全脱离了网络限制,无需担心API调用次数和费用,整体自主掌控感强烈。然而,延迟、硬件消耗和效率问题仍是亟待攻克的难题。

普及度较低和使用门槛较高限制了它在专业大规模项目中的应用,官方文档资源稀少,社区支持尚在初级阶段。 展望未来,硬件性能的提升以及AI模型轻量化的发展将成为催化剂。更高效、更节能的模型可能使本地AI编程成为主流,尤其是在数据隐私要求高、网络不稳定或成本敏感的场景下。此外,结合云端与本地的混合架构策略,也许是目前最实际的发展路径,即通过云端处理重负载任务,本地承担辅助和缓存,兼顾性能和自主性。 总之,七小时的高空离线编程实验,既是一场技术能耐的挑战,也是对当下AI编程生态的真实写照。虽然还未达到完美体验,但已足够令人振奋,预示着未来本地AI开发的广阔潜力。

开发者们应持续关注该领域的最新进展,积极参与社区生态建设,以推动技术成熟与应用落地。 回到网络环境下,重启云端AI辅助工具时那种响应迅速、操作流畅的体验无疑值得珍惜,但本地AI编码的独立性和自由度让人难以忽视。正如实验者所言,我们尚未完全到达"本地AI开发"的理想状态,但"从这里开始",未来几年的改变或将彻底改写软件开发的方式。 。