在当今信息爆炸的时代,文字成为人们交流、表达和传播思想的重要媒介。然而,许多文字作品中潜藏着无意识的偏见,这些偏见不仅影响信息的客观性,也可能加剧社会的分裂和不公。如何有效地识别和纠正这些隐形的偏见,成为推动更加公平社会的重要课题。Veritas,作为一款专注于检测日常写作中隐藏偏见的创新工具,正站在这一技术变革的前沿,赋能用户以更加理性和包容的视角去审视和优化文字内容。Veritas的出现源于对于公平表达和无偏沟通日益增长的需求。无论是在新闻报道、学术论文还是社交媒体发布的文字内容中,隐性偏见往往不易被作者自身察觉。

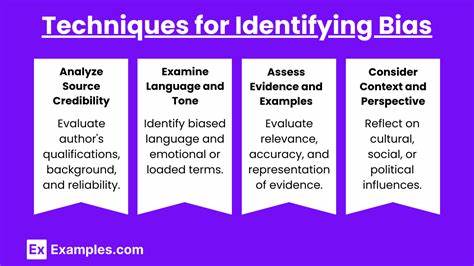

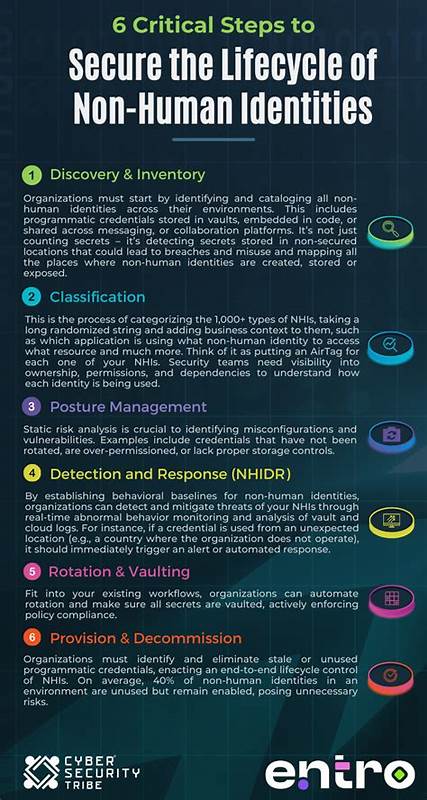

这些偏见可能涉及性别、种族、文化、年龄甚至职业等多个维度,潜移默化地影响受众的认知和判断。借助人工智能和自然语言处理技术,Veritas能够深入解析文本结构和语义,识别出潜在的倾向性用词和表达方式。其核心算法结合了大量语言行为数据和社会心理学研究成果,实现了对多种偏见类型的精准检测。通过对文档的全面扫描,Veritas不仅指出可能存在的偏见点,还提供相应的修改建议,帮助作者在保持原意的基础上,提升语言的包容性和中立性。这种功能对于新闻媒体、教育机构以及企业沟通部门尤为重要。例如,在新闻报道中,避免性别刻板印象的语言能够促进受众的多元理解,而在企业内部文档中,去除文化偏见有利于建立更加和谐的工作氛围。

另一方面,Veritas的用户界面设计直观友好,不需要复杂的专业背景即可上手,广泛适用于不同层级的写作者。通过实时反馈和交互式建议,用户能够边写边改,不断提升自身对偏见的敏感度,培养更具批判性的写作思维。这种持续的学习过程亦有助于推动更广泛的社会认知升级。值得注意的是,虽然Veritas在偏见检测方面表现优异,但依然面对诸多挑战。语言的多义性和文化背景差异使得偏见识别的准确性存在一定局限,同时偏见本身具有动态性和主观性,如何平衡技术判断与社会价值观,是Veritas持续优化的重要方向。开发团队积极与语言学专家和社会学研究者合作,致力于不断完善算法,拓展模型的文化适应性,确保工具能够适应多元环境下的写作需求。

未来,随着技术的迭代和数据量的积累,Veritas有望拓展至更多语言和领域,进一步深度整合到写作软件、编辑平台乃至内容管理系统中,成为创作者不可或缺的辅助伙伴。它不仅能帮助个人提升写作质量,更将在更大范围内推动信息传播的公平与透明。综上所述,Veritas作为检测日常写作中隐形偏见的先进工具,体现了人工智能在促进社会公平方面的巨大潜力。通过精准识别并指导用户改进语言表达,Veritas帮助我们趋向更加包容和理性的信息环境。在全球多元文化交融与信息高度互联的背景下,这样的创新不仅改变了写作方式,更对塑造健康的公共话语空间意义深远。未来,借助持续技术创新与跨领域合作,我们期待Veritas能够成为促进理解、消除偏见的重要桥梁,为构建更加公正和谐的社会贡献力量。

。