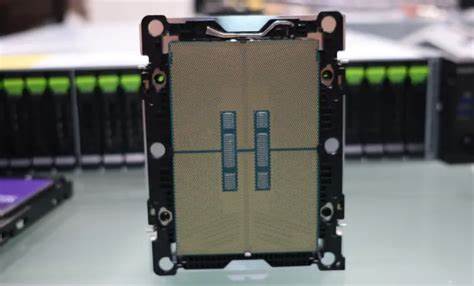

随着人工智能技术的快速发展,数据中心和服务器硬件的性能提升成为支持AI计算能力的关键。英特尔作为计算领域的领军企业,持续推动其服务器处理器架构升级,在最新推出的Xeon 6 "Granite Rapids"系列中,Advanced Matrix Extensions (AMX) 作为一项重要特性,再次将AI推理性能推向新高。AMX不仅优化了矩阵运算的效率,还为多样化的AI应用场景带来了显著性能提升。本文将围绕Intel Xeon 6 "Granite Rapids"处理器中的AMX技术展开,分析其性能优势、实际应用效果,以及对未来AI硬件发展的影响。 首先,了解什么是高级矩阵扩展(AMX)技术至关重要。AMX是一种硬件层面的指令集扩展,专门为加速矩阵乘法和其他关键线性代数运算设计。

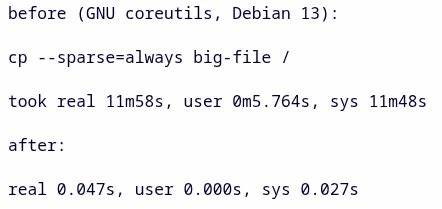

由于矩阵运算是深度学习及许多AI模型中最基础且最频繁的计算,AMX能够大幅度提高这些运算的执行速度,降低延迟,并提升整体能效。在2023年,英特尔于Sapphire Rapids处理器首次引入AMX,随后在Granite Rapids系列中持续优化和强化,旨在应对更广泛且复杂的AI计算需求。 Granite Rapids系列采用了创新的硬件架构和更高带宽的MRDIMM-8800内存支持,为AMX发挥提供了坚实基础。通过在双Xeon 6980P处理器配置中测试,实测表现显示AMX启用时,在包括OpenVINO、Llama.cpp等流行AI软件的多种推理工作负载下,系统性能明显优于关闭AMX功能时。测试环境采用Linux 6.17操作系统和Ubuntu 25.10分发版,确保了较为前沿且稳定的软件基础。性能对比中可以观察到,启用AMX后整体推理吞吐量提升显著,有时甚至达到数倍增长,这归功于AMX在指令级别减少了矩阵计算所需周期。

同时,功耗和CPU温度监测显示,尽管性能大幅提升,能效曲线得到优化,AMX的高效设计避免了传统高性能运算带来的功耗飙升。 即便如此,AMX的生态和软件适配仍在逐步完善阶段。事实上,两年多以来支持AMX的应用软件数量虽有限,但涵盖了不少主流AI框架,说明英特尔社区和合作伙伴持续在推动AMX的广泛部署。用户可通过配置Intel oneDNN库中的环境变量选择性开启或屏蔽AMX功能,满足不同应用场景的需求。与此同时,内核参数配置也提供了灵活性,通过隐藏AMX能力控制特定测试和兼容性问题。这种软硬件的协调设计极大地方便了研发人员进行性能调优和功能验证。

在AI领域,低延迟和高吞吐量是技术竞争的核心。Granite Rapids所搭载的AMX技术不仅针对大规模云端AI推理进行了优化,也对边缘计算场景中资源受限的推断任务提供支持。尤其是在实时数据处理、自然语言理解及图像识别等应用中,AMX释放的性能优势能够提升服务响应速度,降低整体的运营成本。此外,通过与最新DDR5内存以及高带宽缓存系统配合,Xeon 6 Granite Rapids展现出了卓越的综合性能,满足未来几年AI工作负载快速增长的硬件需求。 与其它竞争对手相比,Intel最新的Xeon 6处理器通过AMX在特定AI任务中的优势更加明显。AMD和NVIDIA虽然在AI计算市场占据重要位置,但Intel在服务器级CPU端引入AMX,填补了高效矩阵计算指令集的空白,为多样化AI软件生态注入活力。

该技术的硬件加速特征对于数据中心构建混合计算架构提供了更多选择,有助于实现算力资源的更灵活分配和更低延时的智能推理。 结合未来趋势,Advanced Matrix Extensions的进一步发展值得期待。随着AI模型规模不断扩大和推理复杂度提升,对矩阵计算性能的需求也在快速增长。Intel计划在后续处理器迭代中继续丰富AMX指令集,提升硬件单元的并行度和智能调度能力。与此同时,软件生态的完善和广泛支持也将使AMX技术能够在更多应用领域释放潜力,推动人工智能技术在医疗诊断、自动驾驶、金融风控等领域的实际落地。 总结来看,Intel Xeon 6 "Granite Rapids"处理器搭载的Advanced Matrix Extensions展现了显著提升AI推理性能的能力。

性能提升以高效矩阵运算为核心,不仅缩短了计算时间,提升了能效,同时也为复杂多变的AI应用提供了硬件保障。随着软件生态的持续扩展和优化,AMX技术有望成为未来服务器AI计算的新标杆。对于依赖大规模AI推理的企业和开发者而言,Granite Rapids处理器所具备的硬件优势将显著提升应用表现与部署效率,助力AI技术广泛应用于各行业,推动数字智能时代的加速发展。 。