近年来,随着大型预训练语言模型(Large Language Models,LLMs)的快速发展,零样本学习(Zero-shot Learning)因其能够无需专门训练即完成特定任务的能力而备受关注。所谓零样本,意指模型能够在没有任何针对目标任务的训练样本情况下,仅凭先验知识和上下文提示完成分类、实体识别等任务。尽管这听起来极具吸引力,但“零样本并非免费午餐”的事实提醒我们,依赖这一技术同样存在诸多隐患和限制。本文将全面分析零样本学习的优势与弊端,解析其在实际应用中的挑战,并探讨如何结合传统机器学习方法实现更稳健的模型表现。零样本学习之所以令人兴奋,主要源于大型语言模型已内嵌了丰富的世界知识。这些模型通过海量文本数据的学习,理解了广泛领域的基本信息,使得当给予适当的提示(prompt),即可开启对新任务的推理和预测能力。

相较于传统机器学习中的繁琐特征设计和模型训练流程,零样本利用提示工程快速适配任务的方式无疑为开发者节省了大量时间,特别是在资源有限或训练数据匮乏的场景里,表现尤为抢眼。举个形象的比喻,零样本学习就像是向普通路人提问,他们可能并非领域专家,但凭借常识和生活经验,对很多任务能给出合理且令人信服的答案。这种“常识决策”模式使得问题能迅速得到解决,大约能达到任务完成的80%效果,成为快速验证和初步应用的利器。对于刚起步的团队而言,通过零样本技术进行“差不多可以”的测试,快速获得初步成果,有助于确立产品思路及后续优化方向。因此,从项目启动阶段看,零样本为团队打开了一扇便捷的大门,降低了项目门槛和时间成本。然而,深入实践中,零样本学习的局限也逐渐浮出水面。

最大的难题在于模型往往缺乏对特定领域细节的深入理解,导致结果难以完全符合业务需求。例如,在家具分类任务中,某些名词的实际含义和通用知识存在偏差。像“bistro table”一词被模型误解为与经营场所有关的“bistro”概念,而忽略了其实指的是一种常用于户外的桌子。这种不准确判断让结果无法满足专业要求。此外,尽管可以通过增加示例进行少样本(few-shot)微调,来改善模型表现,但这种做法牺牲了原本零样本的简洁性,且会降低模型的泛化能力。提示设计变得越来越复杂和脆弱,出现了“打地鼠”式的修正悲剧,即为纠正一处错误,不断添加各种边界情况测试和提示补丁,最终导致维护难度骤增。

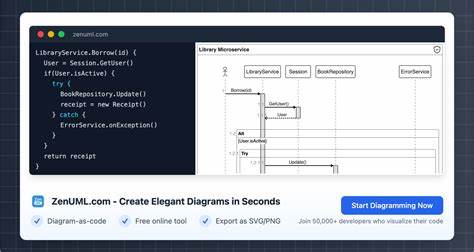

渐渐地,使用场景演变成了构造详尽评估集的过程,这不正是传统机器学习中训练数据构建的核心环节吗?在拥有强评估机制后,为何不直接基于数据训练模型呢?这引发了一个根本性问题:是否应回归机器学习本源,采用系统性训练、交叉验证以及统计意义上的模型评估,以确保模型既不过拟合,也不过于简单且具备足够的表征能力。重要的是,传统机器学习流程注重选择合适的模型架构,构建富含信息的特征集合,为准确决策提供坚实基础。相比之下,单纯依赖巨大参数量的语言模型通过复杂提示实现任务,虽有惊喜但更多是“黑盒”试探,缺乏明确科学原理的支撑,更容易受到模型更新及随机性干扰。更令人烦恼的是,大型模型扩张和版本迭代快如奔马,造成提示行为异变。就像一群打字机猴子轮换上岗,微小提示改动使结果产生巨大变化,甚至出现不连贯和困惑。团队难以掌控模型行为,维护成本居高不下。

面对上述挑战,一种有益的思路是将大型语言模型作为辅助工具——即利用其生成简洁、稳定的特征输入,再交由传统机器学习模型完成最终推断。比起构造复杂冗长的提示,大幅简化变成类似“这段文本是否涉及法国?是或否”这类简单问答,更易于评估和降低输出噪声。在特征层面,还可利用语言模型的文本嵌入、主题概率等多样化数值特征,作为后端模型的输入。通过缓存这些特征,结合外部信息,甚至调用多种LLM资源,构建“语言模型+传统机器学习”混合框架,既发挥了语言模型的知识优势,又兼具传统方法的稳定可靠。实际上,这种方案在某些文本判别与搜索应用中表现良好,提示我们自然语言处理或将逐步脱离对单一提示方式的依赖,回归经典机器学习的根基。综上所述,零样本学习虽是当前AI领域的热门技术,其快速便捷的优点无法小觑。

但实际运用时,我们必须认识其局限,不断补充领域知识,优化提示,构建稳健评估体系,并与传统机器学习方法有机结合,方能真正发挥最大效用。对于寻求长远发展与高准确率的团队而言,迷信零样本“免费”的表象,有可能陷入性能瓶颈和维护困境。未来,随着模型架构与训练技术的进步,或许我们将见证更多融合创新的新范式,兼顾泛化能力和细节精度。对AI工程师和决策者而言,理性看待零样本学习,厘清其优势与不足,灵活地结合各种方法,才是成功应用的关键路径。