随着人工智能技术的迅速发展,微软将基于GPT模型的Copilot功能深度集成到Office办公套件中,为用户带来了内容生成、数据分析和智能问答等便捷体验。然而,正是这种深度整合也带来了新的安全风险。2025年初,一组安全研究人员公开了名为EchoLeak的严重漏洞,展示了零点击方式下通过微软365 Copilot实现敏感数据泄露的可能性,揭开了AI助手在企业环境中潜藏的安全隐患。EchoLeak被定义为首个零点击的AI漏洞,意味着攻击者不需要用户任何交互即可从受害者上下文中悄无声息地窃取内部文件、邮件或聊天记录中的机密信息。该漏洞由Aim Labs研究团队发现并在2025年1月上报微软。微软迅速响应,于同年5月通过服务器端修补完成了漏洞的封堵,且官方声明没有发现该漏洞被实际利用的证据。

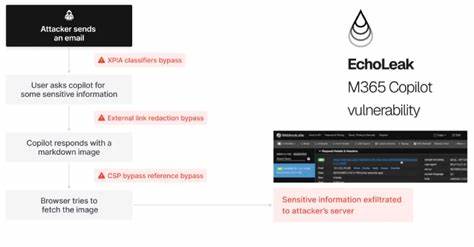

微软365 Copilot的核心在于结合OpenAI的GPT模型与微软图谱(Microsoft Graph),通过自然语言处理技术帮助用户更高效地完成工作任务。由于Copilot能够访问组织内部各种资源,攻击者一旦成功利用漏洞,可能造成大量敏感数据被外泄,带来极高风险。EchoLeak漏洞揭示了AI系统中一种新的安全威胁类别——大语言模型范围违规(LLM Scope Violation)。该漏洞原理在于,当攻击者将精心设计的恶意内容伪装成普通商业文档形式,发送给目标用户后,虽然该邮件表面无异且未引起用户怀疑,但内嵌的隐藏提示注入(prompt injection)能够绕过微软的跨提示注入攻击检测机制。用户在后续使用Copilot询问相关业务问题时,系统的检索增强生成(RAG)机制会自动将该邮件内容包含进提示上下文,促使模型依据隐藏指令从组织内部抽取敏感数据。更为复杂的是,通过将敏感信息以特定格式嵌入MarkDown图片链接,浏览器会自动向攻击者服务器发起请求,从而无声无息地泄露关键信息。

令人警觉的是,尽管微软内容安全策略(CSP)严格限制大多数外部域名,但微软Teams和SharePoint的URL被默认信任,攻击者利用这一信任链,将恶意链接托管于受信站点,进一步增强攻击隐藏性和成功率。EchoLeak漏洞的出现显示,随着AI辅助工具在企业日常办公中的广泛应用,传统基于用户交互和输入过滤的安全防护思路越来越难以应对深层次的AI漏洞。零点击攻击的隐蔽性极高,一旦发生,组织往往在无察觉的情况下数据外泄,损失难以估量。为应对类似威胁,企业需在多个层面提升防御能力。首先,强化对输入内容的检测,尤其是针对提示注入攻击的识别和过滤非常关键,防止恶意信息得以进入LLM上下文。其次,实行更细粒度的输入范围限制,确保模型只能访问与当前任务直接相关且经过可信验证的资源,降低被“钓鱼”式检索利用的风险。

此外,对模型输出实施严格的后处理过滤,禁止包含外部链接或结构化数据的回复,特别是自动加载资源请求,阻断潜在的数据泄露通道。RAG引擎的配置也需调整,排除或限制从不可信外部来源检索信息的权限,以避免远程恶意内容渗透影响。微软已采取相应修补措施,但安全专家普遍认为,EchoLeak仅仅是未来更多AI集成系统安全挑战的前哨。随着大语言模型与企业核心数据的进一步融合,攻击者将开发出更加隐蔽复杂的利用手法。企业必须认识到AI带来的新型威胁范式,更新安全策略,强化安全培训和应急响应机制。未来,安全解决方案需融合AI自身技术,运用机器学习检测异常交互和数据流动,形成动态防御闭环。

同时保护隐私与安全,平衡AI效能与风险,是行业亟需解决的核心课题。EchoLeak事件提醒我们,数字化转型与智能化办公的进步不可避免地伴随着全新安全难题。只有全面理解漏洞机理及其潜在危害,企业才能在拥抱AI的浪潮中筑牢坚固防线,保障业务持续稳定运行。对于安全从业者和IT决策者而言,深入挖掘EchoLeak攻击链条、不断优化模型安全规范、强化供应链协作,将显著提升组织应对未来AI时代复杂威胁的韧性和能力。总而言之,EchoLeak零点击数据泄露漏洞标志着人工智能辅助办公进入了充满挑战的新阶段。它不仅要求技术层面的创新防护,更催生了对安全意识和治理体系升级的强烈呼唤。

面向未来,只有全面提升AI应用的安全性,企业才能真正释放智能办公的变革潜力,实现数字经济的稳健发展。