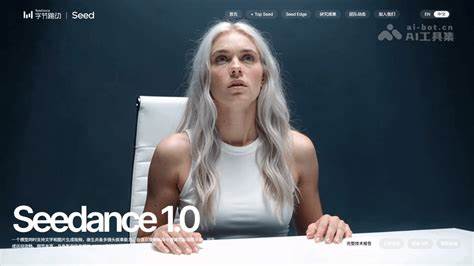

视频生成技术作为人工智能领域的重要研究方向,近年来因扩散模型的突破性发展而得到了极大提升,其在影视制作、游戏开发以及虚拟现实等领域展现出广阔应用前景。然而,当前视频生成模型仍面临如何兼顾文本提示的准确理解、运动的合理流畅以及画面视觉质量三大核心难题。字节跳动发布的Seedance 1.0,以其独特的技术策略和系统优化,成功攻克了这些瓶颈,成为业界关注的焦点。Seedance 1.0是一款高性能、推理高效的视频生成基础模型,它融合了多项关键技术创新。首先,Seedance 1.0通过多源数据的精准策划并结合富有意义的视频字幕,实现了在多样化场景下的全面学习。多源数据不仅包含丰富的视频类型,还兼顾了不同领域和文化背景的视频素材,这为模型提供了多维度的信息输入,极大提升了生成视频的广度和深度。

另一方面,模型采用高效的架构设计与创新的训练范式,支持多镜头视频内容的生成,并且能够联合进行文本到视频和图像到视频的双重任务学习。这种设计不仅提升了模型的适应性,也使得生成的视频在叙事连贯性和主体一致性方面表现突出。更为重要的是,Seedance 1.0进行了精细化的后期训练,运用了视频特定的强化学习与人类反馈机制(RLHF),结合多维度的奖励体系,有效增强模型在复杂多主体环境中的指令遵循能力和动态表现力。这种视频专属的微调方法,使得生成内容不仅视觉效果优异,而且具有高度的运动合理性和结构稳定性。系统层面的优化同样值得赞誉。Seedance 1.0通过多阶段模型蒸馏技术,大幅提升推理速度,实现了达到1080p分辨率5秒视频仅需约41.4秒生成时间(基于NVIDIA-L20硬件环境),相较同类模型有十倍的速度提升。

这种高效性能极大拓宽了视频生成模型在实际应用中的适用范围,使实时性要求较高的场景成为可能。在性能表现上,Seedance 1.0在人工智能分析的视频生成排行榜上名列前茅,无论是文本驱动的Text-to-Video,还是基于图像的Image-to-Video任务上表现出色。它不仅在生成质量和运动连贯性方面优于同行,还具备复杂多主体视频场景中的精准指令执行能力和叙事连贯的多镜头生成优势。Seedance 1.0的成功为视频生成领域注入了强大的动力,同时也为未来视频内容创作方式带来了全新可能。随着视频需求日益多样化与个性化,Seedance 1.0的多任务学习能力和高效推理性能将在广告制作、动画创作、虚拟偶像、教育培训等多个行业中发挥关键作用。展望未来,Seedance团队计划进一步完善模型的多模态理解能力,提升对复杂语义指令的响应精度,并且加强视频表情和动作的细节表现,力争打造更加真实且富有情感感染力的视频内容。

此外,随着硬件性能的发展和算法的不断迭代,视频生成模型将在生成速度和视觉表现之间达到更佳平衡,让普通用户也能轻松享受高质量的个性化视频生成体验。Seedance 1.0作为视频生成技术的标杆,不仅展示了深度学习应用的最新成果,更体现了对用户需求的深刻洞察与技术追求的完美结合。它不仅是视频生成研究的重要里程碑,更是推动数字内容创作生态革新的关键力量。未来,Seedance将继续领跑视频生成技术前沿,助力创造更加多彩、生动的视频世界。