近年来,基于大型语言模型的智能代理迅速进入行业前沿,成为许多企业在产品原型设计、演示乃至实验阶段的热门选择。面对这种新兴技术的冲击,平台工程师们亟需应对诸多问题,包括是否需要完全变革部署模式,从监控策略的革新到架构重写的可能。但经过深入观察与研究,事实表明,主流架构模式依然经受得住考验,真正面临挑战的却是平台本身的工具链、安全策略和运行假设。现有的“2020年代架构”,即以前端单体应用为核心,外围辅以微服务和数据平台的设计,依然有效和可靠。整合了多种技术元素的复杂生态虽面临智能代理引入的特殊需求,但底层架构并非被本质破坏。问题在于平台层面的适应能力,比如如何确保系统的可观察性,保证安全防护,以及管理代理运行流程是否高效可控。

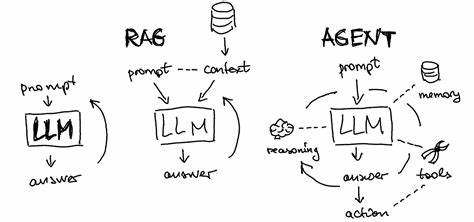

大型语言模型代理不同于传统服务,它并非简单执行预定义指令,而是具备一定的“自主权”,会基于当前环境和上下文动态选择使用工具和决策路径。这种智能体与工作流的区别在于是否由代码主导行动,或是模型自身决定下一步操作。现实中二者常常交织混合,形成模糊边界,而“代理”这一名词往往既指完全自治的智能体,也包括半自主的编排系统。正因如此,智能代理更像是一种全新形式的微服务:外延结构可识别且具备稳定的接口,但内部运作基于概率模型和自然语言驱动,行为难以完全预测。现有平台为何难以应对?首先是观察性挑战。传统服务架构中,一个请求失败通常可以通过复现相同调用重现故障,但对于大型语言模型代理,同一请求可能因模型浮点运算差异、分词器漂移、微小上下文改变等原因产生不同响应。

普通日志和追踪工具无法捕捉关键的中间推理过程和上下文状态,难以还原代理“思考”的轨迹。为此,工程团队必须构建更加细致且语义丰富的日志体系,涵盖提示词版本、推理链路和检索信息,以实现故障重现和调试。同时,提示语本身成为业务逻辑的核心,细微变化就能影响输出格式和工具调用,这要求引入提示版本管理、回滚和渐进式投放策略,与代码部署管理同样重要。其次,安全问题尤为突出。传统REST API依靠明确的schema和接口契约保证通信规范,而自然语言交互打破了这些边界。用户输入含糊甚至恶意指令时,代理可能执行意料之外的操作,比如删除关键数据或泄露内部信息。

提示词注入攻击带来的风险不容忽视。为此,平台团队需要设立严密的流量网关,实时检查和控制代理与语言模型间的交互,类似LiteLLM的模式,通过审计、日志记录和生成内容的验证确保安全性和可控性。此外,调用第三方工具的权限验证必须严格执行,敏感信息应从可信上下文中获取,避免代理输出直接影响敏感操作。最后,执行流程的挑战亦不可小觑。以往软件系统多构建于两种模式:一种面向交互,要求极低延迟和无状态响应,如电商网站页面渲染;另一种则为批处理,容忍长时间延迟,注重任务重试和失败容忍,如订单交易处理。大型语言模型代理打破了这两极分化,它们既非真正的快速响应请求,也非可预先计算批处理,拥有数秒的上下文计算时间和频繁动态交互。

执行环境必需支持状态持久化、失败恢复和灵活的重试机制,此外,还要识别模型生成的非确定性流程,因为代理在执行时常临时生成逻辑,而非遵循固定分支。这使得传统工作流引擎显得笨重且不匹配,催生了如LangChain、Guardrails乃至E2B等新兴解决方案,它们分别致力于编排策略、输出约束和专门设计的执行环境,适应智能代理动态、不可预测的特性。面对上述多层面挑战,平台团队该如何应对?当前不宜盲目启动大规模平台改写。智能代理技术和最佳实践尚在快速发展,盲目预判和全盘重构会导致资源浪费与风险积累。更为务实的做法是聚焦于边界保护,建立安全稳固的接口实现代理与工具间的隔离;支持早期采纳者试验新技术,允许灵活演进尽管可能存在混乱;保障先锋产品团队能够在不依赖平台全面批准的情况下快速迭代,收集反馈和经验。这样一条渐进式赋能路径优于试图通过统一抽象封装所有细节的中央化方案。

可以预见的是,未来6至12个月,代理技术及其应用形态会经历巨大变革。平台团队必须保持敏锐并富有弹性,不断调整监控、安全和执行策略,以跟上技术迭代和业务需求。这不仅是对架构的考验,更是对平台能力的深刻挑战。总结来看,大型语言模型代理并不会瞬间颠覆现有的服务架构,但对平台层面的要求提出了全新标准和压力。只有注重提升平台可观察性、加强安全治理,并革新执行环境,才可为智能代理的长远落地和规模化应用提供坚实基础。企业应当以开放且谨慎的态度,迎接这场由智能自动化驱动的技术浪潮,在变革中实现稳健发展,而非被未知风险所困顿。

。