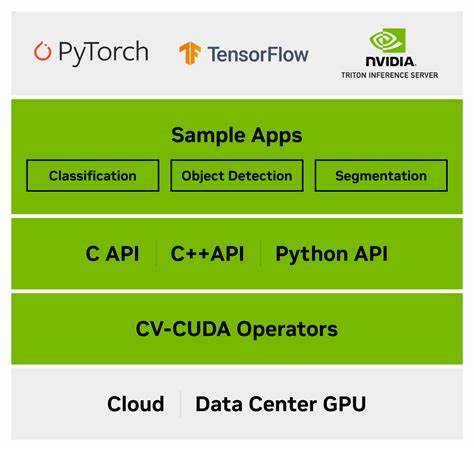

随着人工智能和深度学习技术的迅猛发展,张量库作为机器学习模型计算的基石,其性能和易用性受到了极大的关注。本文分享了一个由开发者从零开始构建的C++/CUDA张量库的设计思路和实现经验,这款名为DSC的张量库不仅兼容PyTorch,还通过一系列创新特性提供了优异的计算性能和广泛的设备支持。张量库的重要性体现在它对数据进行高效存储和计算的能力上,尤其是在深度神经网络训练和推理阶段,对于大规模数据和复杂计算,性能瓶颈常常集中在张量运算的效率与系统的资源管理。另一关键挑战是在不同硬件后端间实现无缝迁移,以满足多样化的计算需求。DSC应运而生,旨在解决上述痛点。其核心设计包含了与PyTorch类似的API接口,极大地降低了学习曲线,使得从PyTorch迁移过来的开发者能快速上手。

同时,DSC并未依赖外部库,全部核心操作采用可移植的C++代码实现,保障了跨平台的稳定性和可维护性。更为亮眼的是,DSC支持多后端计算,涵盖CPU和基于CUDA的GPU加速平台,且未来还计划支持更多计算架构。用户可通过简单的函数调用切换默认设备,无需修改现有代码,即可享受硬件性能提升。内存管理方面,DSC采用了自定义的内存分配器,预先在启动时分配所需内存,避免了运行时频繁的malloc和free调用,显著减少了内存碎片与分配延迟。这种设计不仅提升了计算效率,也增强了内存使用的可预测性和稳定性。针对计算设备,DSC对CUDA和ROCm两大GPU生态均提供支持,确保用户可以利用主要厂商产品实现加速。

通过编译选项,用户可灵活开启GPU支持,并通过Python API检测当前所使用的后端类型,例如判断是否为CUDA或ROCm,方便动态调整计算资源策略。在神经网络支持方面,DSC内置了类似PyTorch的nn.Module模块结构,实现了模型定义、训练以及推理的完整流程。用户可轻松导入已有的PyTorch模型示范,快速完成模型移植与性能验证。此外,DSC提供了丰富的测试套件,结合了NumPy及PyTorch两个知名库作为验证标准,确保了计算的正确性与一致性。支持多线程并行计算,用户可根据硬件条件调整线程数,以提升CPU性能,在多核环境下实现高效资源利用。对于开发者而言,DSC的构建流程也相对简单,采用GNU Make管理构建,完全基于现代C++20标准,可兼容主流Linux发行版。

安装步骤涵盖从源码克隆、环境搭建、依赖安装到库编译,支持调试模式与发布优化选项。为满足高性能需求,开发者还可启用日志级别配置、内核跟踪及内存分配器切换等功能,帮助排查性能瓶颈及调优。DSC不仅是一个技术实现,更展现了深度学习框架自研的趋势,打破对大型闭源库的依赖,促进生态多元化和创新。其开源BSD-3-Clause许可证让用户在商业和研究应用中拥有极大自由度,同时社区活跃度逐渐提升,吸引了功能扩展和性能优化的贡献者。展望未来,DSC团队计划支持更多后端设备,继续优化内核性能与内存管理,提升Python绑定的便捷性,增强模型兼容性。随着AI应用不断下沉至边缘计算与多样硬件环境,像DSC这样的轻量级、高效、多平台支持的张量库将发挥重要作用。

总的来说,DSC以其从零开发、轻量高效、多后端支持和简洁API设计切中了当前张量计算框架的需求核心,成为了深度学习从业者和研究人员值得关注的新兴方案。它不仅推动了C++与CUDA在AI领域的深度结合,也为未来张量计算提供了可持续发展的技术范例。开发者如果愿意尝试底层技术栈,体验自定义张量计算的强大与灵活,DSC无疑是理想的入门实践项目。它的开源代码、完善的文档和案例示范为学习及二次开发提供了有力支持。随着社区的发展,相信DSC将不断进化,助力更多AI项目在性能与灵活性上实现跃升。