随着人工智能技术的不断进步,尤其是生成式AI和大规模语言模型(LLM)的广泛应用,计算资源的需求日益增长。企业和开发者们面临着如何快速、高效、安全地部署和调用复杂AI模型的难题。AWS Marketplace上的Cerebras推理云(Cerebras Inference Cloud)正是在这一背景下应运而生,为用户提供了一个极具竞争力的AI推理解决方案。Cerebras推理云不仅实现了推理速度的大幅提升,还以其简单的接入方式和深度兼容性,帮助用户极大地缩短开发周期,提升业务价值。 Cerebras推理云的核心优势是其搭载的革命性硬件——Cerebras Wafer-Scale Engine(WSE)。这是一种基于晶圆级封装的超级AI加速器,拥有远超传统GPU的并行计算能力和内存带宽,能够支持高达数千亿参数级别的模型推理。

相比现有GPU方案,Cerebras推理云实现了多达70倍的速度提升,每秒可处理超过2500个tokens,确保推理过程几乎零延迟,特别适合需要实时交互的应用场景。 这种超高速的推理能力意味着用户无需担心多步复杂推理带来的延时问题。无论是进行复杂的多步骤推理链,还是需要快速响应的智能问答和对话系统,Cerebras推理云都能在不足一秒的时间内输出完整、准确的答案。这对于医疗诊断、金融分析、智能客服以及自动化决策等领域具有极强的应用价值,能够显著提升用户体验和工作效率。 AWS Marketplace作为全球领先的云服务交易平台,为Cerebras推理云的用户提供了极致便捷的使用体验。用户只需通过简单的API调用,即可快速访问诸如Llama、Qwen、DeepSeek、Mistral等顶尖开源模型,无需繁琐的GPU硬件配置和系统调优。

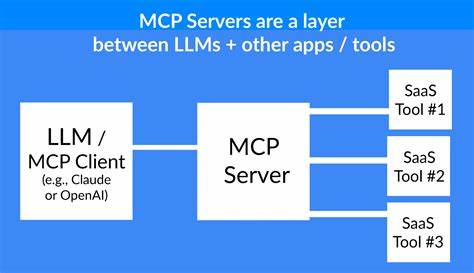

这样不仅节省了大量的人力和时间成本,还加速了创新产品从概念到市场的转化速度。借助AWS市场的广泛生态,Cerebras推理云完美融合了AWS的可靠性和弹性,确保推理服务的稳定性与可扩展性。 此外,Cerebras推理云采用“软件即服务”(SaaS)交付模式,通过云端统一管理和运维,用户无需担心底层基础设施的复杂性。契约式的计费方式让企业能够根据实际使用量灵活调整,避免了传统硬件投资的高额前期支出。AWS本身强大的计费和安全机制,也保障了用户数据和推理过程的安全合规。 在面对日益多样化的AI应用需求时,Cerebras推理云具备极强的模型兼容性和扩展能力。

不仅支持主流开源大型语言模型,还能快速适配用户自定义模型,满足个性化推理需求。无论是金融风险评估、基因数据分析,还是智能制造中的复杂决策支持,都能找到合适的应用场景。同时,Cerebras团队还提供全天候技术支持,确保客户在使用过程中遇到技术难题时能够及时获得专业帮助。 随着生成式AI的兴起,企业对高效推理平台的需求日益增长。Cerebras推理云通过领先的芯片设计和云端高效服务,帮助企业显著提升AI推理性能和应用响应速度,赋能智能化转型。尤其是在竞争激烈的科技和金融行业,快速准确的推理能力成为关键竞优势,Cerebras推理云无疑是行业内的顶尖选择。

展望未来,Cerebras将持续推动硬件和软件的协同创新,不断优化Inference Cloud的性能和功能,致力于为更多行业和应用场景提供定制化的AI解决方案。结合AWS的全球云计算资源,用户可以在全球范围内获得低延迟、高可靠的AI推理服务,助力智能时代的数字化飞跃。 总的来说,Cerebras推理云不仅是硬件技术革新的结晶,更是实现AI应用规模化落地的关键枢纽。通过AWS Marketplace这一开放、便捷的平台,企业能够以极低的门槛快速接入全球顶尖的AI能力,利用超高速的推理性能,打造差异化的智能产品和服务。未来,随着人工智能应用的不断深入,Cerebras推理云必将继续引领推理技术的新纪元,为全球用户带来更快、更强、更可靠的AI推理体验。