随着人工智能技术的快速发展,OpenAI推出的Codex技术成为程序员和开发者的得力助手,显著提升了代码生成和自动化水平。与此同时,涉及到用户数据安全和隐私保护的问题也日益引起关注。很多开发者关心的问题是,如果使用Codex CLI工具或自定义提供者(如Azure OpenAI服务),OpenAI是否会对上传的数据进行训练,或者收集任何遥测数据?能否保证数据只流向指定的终端节点,而不会被发送给OpenAI其他系统?这些问题关乎企业的数据合规风险和使用信心。了解官方最新声明,可以帮助用户做出明智选择,避免潜在隐私泄露。OpenAI官方在GitHub的相关讨论中曾明确表态,使用自定义提供者时,并不会将数据传递至OpenAI的默认服务器,也不会进行数据训练或保留用户数据。具体而言,在相关仓库中,开发者提出了是否会有遥测数据发送以及数据是否会被用于模型训练的担忧,这一话题引起了社区高度关注。

OpenAI团队及时回复,确认“无数据保留”的政策同样适用于通过自定义提供者接入的用户。也就是说,除非用户明确同意,否则OpenAI不会收集、保留或分析利用传输的数据,这给予使用者更多隐私保障。除了这一点,官方还特别说明,遥测数据不会被自动发送给OpenAI,所有数据流只经过并停留在用户指定的终端节点。这对需严格把控数据访问权限的企业和开发者非常关键。尤其是在金融、医疗等敏感行业,对数据合规性要求极高,无法容忍任意访问外部服务器的行为。借助这样的政策,用户能够放心部署Codex CLI或者借助Azure等自定义AI服务提供者,无需担心数据泄露或被第三方利用做模型训练。

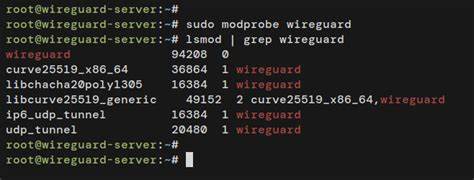

至于模型训练方面,OpenAI的策略是一贯透明且尊重用户隐私的。默认情况下,OpenAI不会利用客户的查询作为训练数据,除非客户选择激活某些特定选项。对于通过自定义提供者进行的请求,系统同样不会自动参与训练模型。这意味着,企业用户和开发者可以专注于自身业务创新,而不用担忧自己的独立数据会反馈到模型训练中,从而影响知识产权保护或导致信息外泄。使用Codex CLI连接自定义提供者的方式,也增强了用户对自身数据管控的能力。因为所有网络请求都直达用户指定的API端点,数据不会被中转到其他服务器,且网络传输过程采用了强加密技术,保障数据在传递过程中不被窃取或篡改。

结合官方提供的“零数据保留”(Zero Data Retention)机制,用户的数据风险被最大限度地降低。这种生态环境适合企业开发定制化AI产品,支持自主检测与审计,满足严格法规如GDPR或CCPA要求。除了隐私和训练相关的保证外,OpenAI不断完善文档支持,针对自定义提供者和Codex CLI的用法进行了详细介绍。任何潜在用户均能通过官方渠道清晰了解接口调用逻辑、数据流向、权限管理及安全防护措施。社区讨论也促使官方持续更新README和相关指引,保障信息的及时性和准确性。对于广大开发者而言,理解这些政策不仅提升使用时的信心,而且能促进OpenAI产品的合理合规应用,打造可信赖的智能工具。

利用自定义提供者,用户能够灵活适配自身业务需求,结合OpenAI强大的语言处理技术,安全构建个性化代码生成、自然语言理解等应用场景。综上所述,使用OpenAI Codex CLI和自定义提供者时,用户数据不会被用于训练模型,也不存在自动的数据遥测上传,确保了个人和企业数据在传输和处理过程中的高度私密性与安全性。这为AI技术在现实业务中的落地提供了坚实保障,也回应了公众对数据隐私保护的核心关切。随着人工智能和云服务的持续融合,OpenAI及其生态合作伙伴将继续强化数据安全与透明度,让创新步伐和用户权益并驾齐驱。在数字化转型浪潮中,做好数据使用的规范和技术保障,是各方共同的责任。牢记官方政策和最佳实践,有助于每一位技术从业者在拥抱智能新时代的同时,保持对信息安全的敬畏与守护。

。