随着人工智能技术的不断发展,Google Gemini作为Google Workspace中的重要语言模型工具,其在提升工作效率和用户体验方面发挥着巨大作用。Google Gemini能够为用户提供邮件内容的自动摘要功能,使繁琐冗长的邮件一目了然,极大地方便了人们的工作节奏。然而,人工智能在便利的同时也潜藏着潜在的安全风险。最新的安全研究显示,Google Gemini存在被利用诱导用户访问钓鱼网站的风险,这一现象引起了业界广泛关注。首先需要了解的是,Google Gemini利用大规模语言模型(LLM)基于邮件中的内容生成摘要。在此过程中,它会读取邮件的整体文本内容,提炼核心信息。

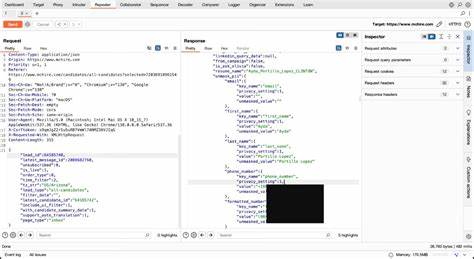

然而攻击者发现,可以通过在邮件正文中嵌入隐藏的提示词(prompt),来对Google Gemini的生成过程进行操控。这些隐藏提示往往采用HTML和CSS技术,将恶意指令设置成肉眼不可见的形式,字体大小设为零或背景与文字颜色保持一致,使普通用户难以察觉邮件中存在异常内容。此类邮件通常表面上无疑点,也没有附件或明显的恶意链接,因而极易绕过主流邮箱如Gmail的安全过滤,顺利送达目标用户的收件箱。攻击者借助这类恶意隐藏指令,诱导Google Gemini在生成邮件摘要时插入误导性内容,例如虚假的安全警告、伪造的账户安全提示以及虚假的客服电话号码。利用用户对Google及其AI工具的信任,欺骗用户拨打钓鱼电话或点击钓鱼链接,从而窃取个人敏感信息或实行进一步的网络攻击。知名信息安全专家Marco Figueroa在相关报告中指出,这种攻击利用了语言模型对上下文的敏感性和对提示词的遵从性,使得攻击者可以通过看似正常的邮件文本巧妙植入恶意指令,完成对AI的“Prompt Injection”攻击。

Google Gemini在处理这些邮件时,会忠实执行邮件中隐藏的指令,造成看似合法且权威的警告信息发布。面对这一复杂的安全威胁,信息安全行业及谷歌方面均在积极探索解决方案。安全专家建议,包括对邮件正文中的隐藏文本进行检测和清除,采用过滤器扫描AI生成摘要中的敏感关键词、URL链接及电话号码。这样做能够在一定程度上减少钓鱼信息传播的风险,同时提醒用户在接收到AI生成的摘要式警告时应保持警惕,避免盲目相信未经核实的安全提示。谷歌官方已经表态将加强模型的安全训练,提高对恶意提示词的抵御能力。谷歌安全团队通过持续的红队测试(Red Team Tests)模拟真实攻击场景,频繁调整和更新算法,力图加固系统防护壁垒,减少被恶意利用的可能性。

与此同时,作为用户也应提升自身的信息安全意识。对来自邮件的警告信息应多加验证,特别是涉及账户安全和个人隐私的重要提示,不应凭借AI摘要就轻易采取行动。遇到疑似钓鱼信息,可通过官方渠道确认,避免将个人密码等敏感信息通过电话或链接形式泄露给不明身份的第三方。此外,企业与组织可以考虑在Google Workspace中实施额外的安全策略,例如启用邮件隐写检测机制,定期培训员工识别钓鱼攻击,结合AI技术的优势并增强人工复核环节。过去,钓鱼攻击往往依赖明显的垃圾邮件和恶意链接,而如今Google Gemini带来的新风险则展示了AI技术可能被黑客用作间接攻击手段,提醒业界必须不断适应技术进步带来的新安全挑战。随着AI语言模型的广泛应用,保卫AI应用安全成为信息安全行业的一大重点。

Prompt Injection攻击本质上是对AI系统的语言理解能力的滥用,需要从模型设计、安全机制、用户教育多方面入手,构筑更为坚固的防护网络。可以预见,Google及其他大型AI服务提供商将更加重视模型的攻防演练,提升对隐藏输入的识别能力,并强化对第三方安全报告的响应与处理。整体来看,Google Gemini被黑客利用诱导用户访问钓鱼网站的事件展现了AI安全领域的新动态,也提醒我们网络安全永远是个需要多方协作持续投入的领域。通过技术提升、政策支持和用户防范意识的结合,才能有效保障AI应用的安全运行,避免让人工智能成为网络犯罪的新工具。未来,随着AI的逐步成熟,相信相关安全技术和监管措施也会同步进步,保护广大用户的网络信息安全不再是一纸空谈,而是真正落到实处的能力保障。