在当今人工智能和大数据时代,向量搜索技术已成为支撑语义理解、推荐系统以及自然语言处理等多个领域的核心基础。然而,面对海量高维度向量数据的存储和检索,传统方法难以兑现低延迟和高精度的承诺。近期,开源项目CoreNN通过创新设计,实现在单台机器上以15毫秒的惊人速度搜索10亿条向量嵌入,彻底改变了向量数据库的性能和成本范式。CoreNN的出现不仅是技术层面的突破,更为实际场景中大规模向量搜索提供了切实可行的解决方案。传统向量搜索方法多基于图算法,如著名的HNSW(Hierarchical Navigable Small World)结构,能够高效地实现近似最近邻(ANN)搜索。然而,要支撑10亿条768维的嵌入数据,这些方法往往要求高达数TB级别的内存资源,使得部署成本和维护难度飙升,不易在常规硬件环境中使用。

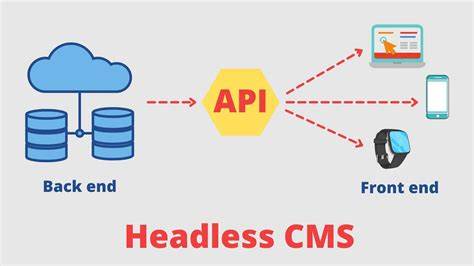

更重要的是,传统索引对增删改操作的支持较弱,插入或删除往往需要全量重建索引,严重影响实时性和系统稳定。CoreNN的设计理念正是在保障查询高精度的同时,大幅降低对内存的依赖,转向性能价格比极优的闪存存储方案。它通过多阶段存储布局,实现内存与磁盘之间的高效切换,保证用户无需为扩展配置复杂参数,也不会产生系统停机。其核心技术来自在近似最近邻搜索领域极具影响力的DiskANN与FreshDiskANN论文,但进行了一系列原创优化,诸如利用RocksDB作为底层持久化引擎,解决了大规模数据写放大和更新延迟的问题。RocksDB以其快速稳定和压缩高效的特性,成为CoreNN的理想落地平台。存储节点的每条记录中同时存放了节点的邻居列表和完整向量,不仅使得查询时能够借助邻居列表近似路径快速定位,还能利用“隐式重排名”技术用全精度向量进行精细筛选,这样有效避免了大量额外的磁盘I/O操作,从而极大提升检索速度。

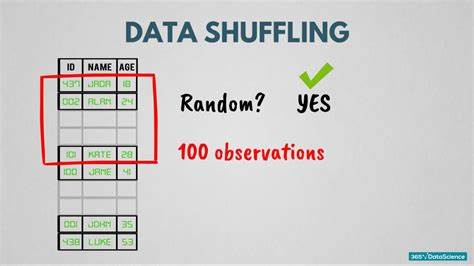

为解决大量更新场景中邻居反向边更新造成的写放大,CoreNN采用"附加邻居"机制,将新增邻居单独存储,不频繁修改原邻居数据,降低了磁盘写入负载,同时通过配置参数调节节点度数上限,平衡了更新频率和查询效率,利用闪存高并行的I/O优势优先保障查询性能。计算层面,CoreNN成功引入产品量化技术,使得存储在内存中的向量均为压缩版,极大地减少了内存占用,典型压缩比达到32倍。产品量化通过将每个向量划分为若干子空间,并对每个子空间内的数据点进行聚类,以聚类中心编号代替原始浮点数存储,实现了高效的向量压缩而不牺牲过多精度。尽管内存中的向量为量化版本,图结构和搜索路径均基于全精度向量建立,因此整体召回率优于传统HNSW索引。在数值精度方面,CoreNN支持float16、bfloat16以至于1位二值量化,针对文本嵌入表现出极强的适应性,这也为海量语义数据处理提供了更经济的储存方案。此外,它使用AVX-512等高级指令集优化计算性能,兼具高吞吐和低延迟。

程序执行架构上,实际生产环境中CoreNN采用同步设计,避免了异步环境下对低级库支持不佳和调试复杂度提升的问题。同步架构畅通无阻地兼顾了计算密集型任务和磁盘I/O,结合多线程调度及硬件加速,实现了稳定高效的并发查询。针对不同规模的应用,CoreNN可无缝在内存模式和磁盘模式间切换,保证即使随着数据海量增长,查询性能无明显下降且无须停机维护。这样灵活且智能的资源管理让开发者和运维人员极大降低维护成本,并能动态应对流量变化和数据更新。在实际应用中,CoreNN广泛适用于大规模社交媒体内容的语义搜索、实时推荐系统、高维度特征匹配以及交互式数据分析。无论是研究原型构建、高并发生产服务,还是个人开发者进行巨量数据的单机查询,CoreNN都能轻松应对。

其类SQLite的单文件化设计与丰富语言绑定(Node.js、Python、Rust)也极大降低了集成门槛,为更多领域引入语义搜索技术铺平道路。作为一个开源项目,CoreNN具备高度的可扩展性和灵活性,欢迎社区贡献和反馈,共同推进向量数据库技术的发展。未来,随着硬件不断进步和算法持续演化,CoreNN有望继续通过创新存储布局、并行计算和量化技术,提高精度和性能极限,赋能更多复杂AI场景,助力海量信息的智能化理解与挖掘。总而言之,CoreNN突破了传统向量库依赖巨额内存的限制,开创了单机低成本高效搜索10亿高维度向量的新纪元,是迈向大规模语义搜索商用化的重要里程碑。随着其完善生态和不断优化,实现更快、更准、更省的向量检索将成为现实,推动人工智能应用更广泛渗透进各行各业,为未来的信息检索与知识发现带来强大动力。