在企业信息化进程中,将大量本地文件迁移到 SharePoint Online 是常见而具有挑战性的任务。微软提供的 Core.BulkDocumentUploader 示例加载项是一个用于批量上传文档的参考实现,采用控制台应用程序结合 REST API 调用的方法,可以为自定义迁移工具和批量上传场景提供实战参考。本文将从配置、运行机制、关键代码解析、认证与安全、性能优化、错误处理、扩展方法以及替代技术等多维度,系统讲解如何利用该示例加载项实现稳定可靠的批量上传解决方案,并提出在迁移到 Office 365 时的最佳实践建议。 先从准备工作说起。要运行示例,需要从 Office 365 Developer Patterns and Practices 项目中下载 Core.BulkDocumentUploader 源代码。示例的配置通过一个 XML 文件(示例中为 OneDriveUploader.xml)和一个 CSV 映射文件(SharePointSites.csv)完成。

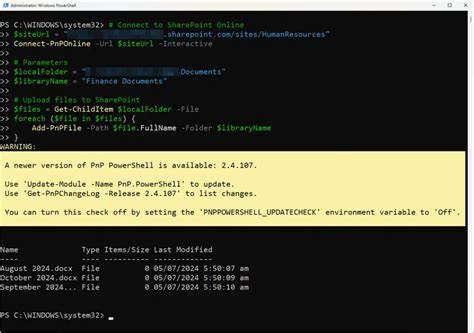

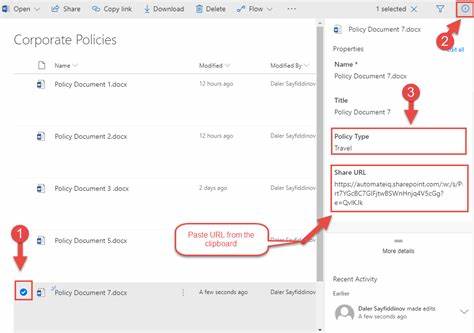

XML 文件包含日志路径、CSV 路径、文件目录、SharePoint Online 凭据、文档操作类型(Upload 或 Delete)以及上传后文件的新名称等重要设定。CSV 文件用于映射目标站点与要上传的本地文件名。正确配置这两个文件后,需要在 Visual Studio 的项目调试属性中将 OneDriveUploader.xml 的路径作为命令行参数传递给应用程序。 从代码执行流程角度来看,Main 方法通过 RecurseActions 调用 OneDriveMapper.Run,Run 方法会打开 CSV 并对每行执行回调,最终调用 IterateCollection 逐条处理映射项。IterateCollection 的核心逻辑包括构建 ClientContext、使用 SharePointOnlineCredentials 进行身份验证、获取待上传的本地文件、校验权限、构建 REST 请求并将文件流写入到目标库。上传使用的 REST 端点形式为 /_api/web/lists/getByTitle('Documents')/RootFolder/Files/add(url='{filename}',overwrite='true'),HTTP 方法为 POST,同时在请求头中传递 X-RequestDigest 以通过防伪请求校验。

认证细节是该示例的核心之一。示例通过 SharePointOnlineCredentials 获取身份 cookie,进而在 HttpWebRequest 中使用 CookieContainer 添加名为 SPOIDCRL 的 cookie,确保 REST 请求在 SharePoint Online 端被识别为已认证请求。与此并行,示例使用 ClientContext.GetFormDigestDirect() 或等效方法获取 Form Digest(用于 X-RequestDigest 头),这是 SharePoint 要求的服务器端防伪校验手段。注意保护凭据安全,避免在生产环境中以纯文本形式存放用户名和密码,推荐结合 Azure Key Vault、Managed Identity 或 OAuth 应用注册等更安全的认证方案替代明文凭据。 示例实现中采用了权限预检逻辑,使用 BasePermissions 设置 PermissionKind.AddListItems,然后通过 context.Web.DoesUserHavePermissions 检查当前账户是否有向目标库添加项目的权限。权限检查通过 ConditionalScope 包裹核心上传逻辑,若权限不足则会提前失败并在日志中记录。

文件读取使用 FileInfo.OpenRead 将本地文件流写入 SPORequest 的请求流;写入结束后,通过 GetResponse 获取 HTTP 响应,从而确认上传是否成功。 对于需要上传大量文件或多个站点的场景,示例仅上传单个文件并将文件名覆盖为配置文件中指定的 FileUploadName。要扩展为真正的批量上传,需要在 CSV 映射中列出多个文件或实现文件夹遍历逻辑,并在 IterateCollection 中循环处理多个文件项。并发上传可以显著提升吞吐量,但需注意 SharePoint Online 的限制与节流规则。建议采用可配置的并发度,结合重试与指数回退策略处理 429(Too Many Requests)或 503(Service Unavailable)响应。同时在每次请求前后观察返回的 Retry-After 头,合理调整重试间隔以避免被持续限流。

性能优化方面有若干重点。首先,尽量减少不必要的上下文创建和凭据初始化,批量处理时复用 ClientContext,并重用获取的 Form Digest,注意其有效期通常为有限时间,必要时刷新。其次,上传大文件或大量小文件时需要采用合适的分片上传或并行流式传输策略。虽然示例使用简单的 Files/add 接口适合小到中等大小文件的原型,但对于几十兆甚至数百兆的大文件,应考虑使用 SharePoint 的分块上传接口或 Core.LargeFileUpload 示例中演示的分片方法。再次,网络带宽与延迟直接影响上传时间,建议在可能的情况下将迁移工具部署在与目标 Office 365 区域接近的云或区域内,以最小化网络往返时延。 日志与监控是保持迁移质量的保障。

示例通过 LogHelper 记录详细的调试信息、成功或失败的结果,以及每笔操作的耗时。实际生产中应将日志输出集中化,使用可搜索的日志仓库或监控平台,方便事后分析和回滚。建议为每条上传记录保存原始文件路径、目标 URL、上传时间戳、HTTP 响应状态码、任何异常信息以及尝试次数,便于在失败后进行重试或手工查证。同时对失败原因分类,区分权限不足、网络超时、文件损坏或目标路径不存在等常见问题,有针对性地实现自动恢复或人工干预流程。 安全与合规不可忽视。上传文件到 SharePoint 不仅仅是把字节写入目标库,还涉及元数据、访问控制、敏感信息处理和审计。

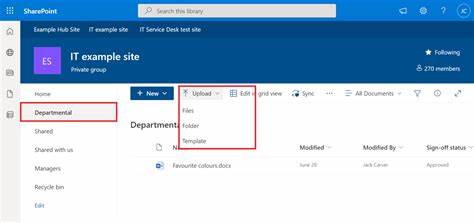

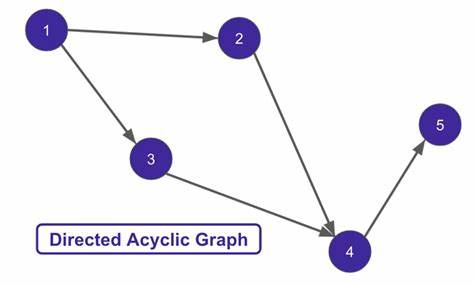

示例仅演示文件的二进制上传,实际迁移时通常需要设置文档库的字段、应用内容类型、设置合适的权限继承或断开继承、对敏感数据进行标记或加密。同时要遵循组织的合规规范,确保在迁移过程中不违反数据驻留或隐私政策。建议在迁移前进行试点验证,采用最小权限原则的服务账户,并在迁移后进行权限审计和完整性校验。 在扩展性方面,示例代码结构清晰,适合作为二次开发基础。可以将 CSV 映射替换为数据库或队列驱动方式,实现断点续传和任务调度。对于企业级迁移,结合 Azure Functions、Logic Apps 或自研的分布式工作器可以实现弹性扩缩容。

上传失败的任务可以写入死信队列并由专门的补偿进程处理,保证迁移过程的可靠性和可恢复性。考虑到大规模迁移可能需要数十万条记录,建议引入任务分片、进度跟踪和去重机制,避免重复上传和资源浪费。 还有替代方案值得比较。对于不想自行实现复杂逻辑的团队,可以评估 Microsoft 官方或第三方迁移工具,如 SharePoint Migration Tool(SPMT)、Microsoft FastTrack 或商业迁移平台,这些工具在处理权限、版本历史和元数据保留方面更为成熟。如果更倾向于编程扩展,PnP(Patterns and Practices)库提供了更高层次的 API 封装,PnP PowerShell 和 PnP Core SDK 能够简化常见操作,并提供了社区支持的最佳实践实现。根据项目规模和合规需求选择合适的技术栈,往往能节省大量开发与测试成本。

故障排查的常见步骤包括重现问题、检查凭据与权限、查看 HTTP 响应码与响应体、检查 X-RequestDigest 是否有效、验证 Cookie 是否正确传递以及确认目标库名是否与 REST 路径一致。示例代码默认指定列表标题为 'Documents',在实际环境中目标文档库名称可能不同或含有本地化名称,建议通过 API 先查询目标库的 Title 或使用库的 GUID 来避免名称变动带来的错误。对于 SSL 或证书相关的网络错误,需要检查客户端环境信任根证书、代理配置以及防火墙设置。 最后给出实践建议。先在测试环境中以小批量文件运行审核配置与权限,逐步扩大规模并监测性能指标。将敏感凭据与配置文件集中管理并加密存储。

为长时间运行的迁移任务设计心跳与状态检查机制,保证在中断后可以从上次已提交的位置继续。针对大文件采用分片上传并在远程端进行完整性校验,确保文件未损坏。结合现有的迁移工具和 PnP 生态可以显著缩短开发周期。 Core.BulkDocumentUploader 示例提供了一个直观的起点,通过理解其核心机制、掌握 REST 上传的细节、并结合安全、性能与可扩展的设计原则,开发者可以构建出符合企业级需求的批量上传与迁移解决方案。迁移不是简单的数据搬运,而是一次机会,用来优化信息架构、提升文档治理并为用户提供更可靠的协作平台。遵循最佳实践、做好前期规划和充分的测试,能让你的 SharePoint 批量上传与迁移工作既高效又稳健。

。