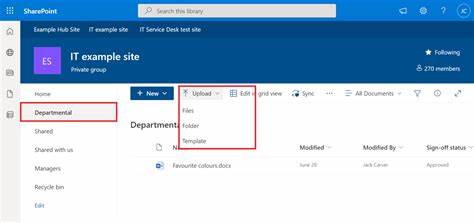

在现代企业内容管理(ECM)和 Office 365 迁移场景中,批量上传文档到 SharePoint 或 OneDrive for Business 是一个常见且关键的任务。GitHub 上的 Core.BulkDocumentUploader 样例为开发者提供了一个基于 SharePoint REST API 的控制台应用模板,演示如何通过配置文件和映射文件将文档自动上传到目标库。了解该样例的实现细节、常见问题和优化策略,能帮助团队在迁移或日常批量操作中节省大量时间并降低风险。本文从准备工作、实现流程、关键配置、安全与性能建议、故障排查到升级路径等方面进行系统讲解,帮助开发和运维人员快速掌握并扩展该样例,以满足真实生产环境需要。 准备与配置是成功运行批量上传工具的第一步。Core.BulkDocumentUploader 以 OneDriveUploader.xml 和 SharePointSites.csv 两个配置文件为中心,XML 文件包含全局设置,例如日志文件目录、CSV 映射文件路径、要上传的源文件夹、SharePoint Online 凭据、要执行的文档操作类型(Upload 或 Delete)以及上传后目标文件名等。

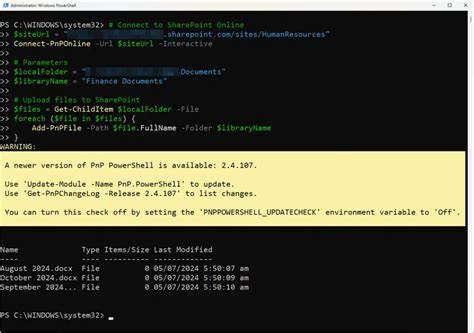

CSV 映射文件则列出目标站点 URL 和对应要上传的文件标识。运行时需要将 OneDriveUploader.xml 的路径作为命令行参数传入控制台应用。实际使用时应注意不要在配置中明文存储敏感凭据,建议使用更安全的凭证存储方案或应用身份验证。 理解程序主流程有助于实现扩展与排错。程序从 Main 方法触发,按配置读取 CSV 映射后逐条处理映射项。核心逻辑在 OneDriveMapper.Run 和 IterateCollection 方法中:Run 方法负责打开并解析 CSV,将每条映射传递给 IterateCollection。

IterateCollection 在每个目标站点上下文中执行具体操作,包括建立 ClientContext、使用 SharePointOnlineCredentials 进行身份验证、从本地目录读取要上传的文件、检查当前用户是否具备添加条目的权限(AddListItems),然后通过 REST 调用将文件流发送到目标库。 在上传实现上,样例通过构造 REST 端点 /_api/web/lists/getByTitle('Documents')/RootFolder/Files/add(url='{文件名}',overwrite='true')? 发起 POST 请求来完成上传,并设置请求头 Accept 为 application/json;odata=verbose,添加 X-RequestDigest 表单摘要以通过防伪验证,通过 CookieContainer 注入 SPO 身份验证 Cookie(SPOIDCRL)来维持会话。上传时以 application/octet-stream 作为请求内容类型,将本地文件流复制到请求流并获取 HTTP 响应以判断操作结果。样例还演示了 DELETE 操作以支持删除文件的场景。异常处理与日志记录被内建在流程中,成功或失败结果会写入日志和 CSV 输出以便审计和重试。 尽管样例结构清晰,但在生产环境中需考虑若干重要扩展和改造点以提升稳定性和安全性。

首先,样例默认使用 SharePointOnlineCredentials 获取凭据并通过 Cookie 验证,这种方式在现代环境中逐渐被 OAuth 和基于 Azure AD 的应用注册替代。推荐使用 Azure AD 应用注册并采用客户端凭据或委派令牌的方式获取访问令牌,通过 Authorization: Bearer 头调用 SharePoint REST 或 Microsoft Graph API,这样更符合云端身份管理及多因素认证(MFA)环境的安全要求。 对于大文件或大量文件的场景,单次将整个文件发送到 REST 端点的方式可能导致超时或性能问题。应采用分块上传或分段上传机制,Core.LargeFileUpload 等示例提供了分片上传的思路。分块上传可以在网络中断或超时后实现断点续传,降低单次请求失败造成的代价。并行上传和队列机制也能显著提升吞吐量,但并发数需结合网络带宽、目标站点的吞吐限制和租户端的节流策略来合理配置,避免触发 SharePoint 的限流(throttling)。

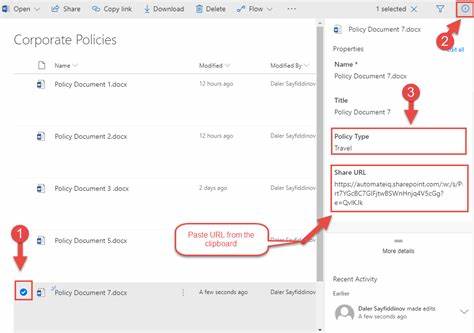

限流响应通常以 429 或 503 返回,需要实现指数退避和重试策略来优雅应对。 性能优化还包括减少不必要的网络往返。上传完成后如果需要设置文档元数据,建议先上传文件获取文件的 ListItem,然后通过一次更新 ListItemAllFields 的调用设置元数据,而非在上传时分多次访问 API。对大量文件进行批量元数据更新时可以考虑合并请求或延迟更新以减少单次事务开销。日志和状态记录需要详细但不可过度影响性能。可将详细日志写入本地文件或集中式日志系统,关键信息应包含源路径、目标 URL、操作结果、HTTP 状态码及错误消息,便于后续回溯与重试。

安全性方面要避免在配置文件中保存明文密码和敏感路径。推荐的做法包括使用 Azure Key Vault 存储凭据和机密,或者采用证书验证的应用身份验证。对于需要以用户上下文执行的上传,应使用委托授予的 OAuth 令牌并确保权限最小化,只授予必要的写入权限。如果采用应用身份验证(App-Only),应为应用设置最小的站点集合范围,并严格管理应用注册的凭据和证书生命周期。敏感操作应有审计记录并在合规需求下纳入 SIEM 系统监控。 在迁移场景中,元数据映射和路径映射是常见挑战。

CSV 映射应包含源路径、目标站点、目标库、目标文件名以及与 SharePoint 列对应的元数据字段。迁移前应进行数据清洗,确保文件名与路径合法,避免非法字符或超过路径长度限制。对于需要保留版本历史或权限结构的迁移,应提前设计好权限重建和版本导入流程。若需迁移大量历史版本,可考虑使用更专业的迁移工具或逐步导入策略以保证数据完整性。 对于错误与异常的排查,常见问题包括身份验证失败、权限不足、请求超时、目标库名称不正确、文件锁定或并发冲突、限流响应以及网络中断。遇到 401 或 403 错误时,应先确认凭据或令牌的有效性与权限范围;遇到 429 或 503 限流时,应加入退避重试逻辑并降低并发;遇到上传失败或超时,检查表单摘要(X-RequestDigest)是否正确以及 cookie 是否已正确注入;遇到大文件失败时,优先采用分块上传策略。

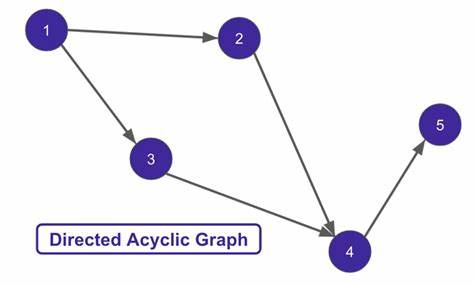

使用网络抓包工具或 Azure Monitor 日志可以帮助定位 API 层面的错误细节。 如果计划将样例扩展为支持真正的批量迁移,应考虑以下工程化要点以提高可靠性和可维护性。第一,设计断点续传和幂等性机制,确保重复执行不会导致数据重复或损坏。第二,采用任务队列与持久化队列状态,支持任务重试、暂停、恢复和并发控制。第三,提供可回滚或回退的审计信息,在异常中断后能够重试失败项并记录成功项以避免重复处理。第四,为大规模迁移构建监控与告警体系,实时监控任务进度、吞吐量、错误率和限流事件,以便及时调整策略。

在技术选型上,现代化改造建议从使用 HttpWebRequest 迁移到更灵活的 HttpClient 并充分利用 async/await 异步模式,提高资源利用率和应用响应性。对于 .NET 平台的开发者,PnP Core SDK 或 PnP Framework 提供了更高层的封装,简化常见 SharePoint 操作;对于跨平台或前端项目,PnPjs 或 Graph SDK 是更合适的选择。对于 OneDrive 或个人站点的访问,Microsoft Graph 提供了统一且持续更新的 API,很多新特性优先在 Graph 上发布,因此在长期维护上优先使用 Graph 能减少未来迁移成本。 部署与运维方面,建议将批量上传工具放在受控的运行环境中,例如自动化服务器或云函数池中,通过调度任务触发或由用户接口提交迁移计划。日志应集中化,错误应具备告警机制。若迁移规模大且网络受限,考虑在与目标租户同区域的虚拟机中运行上传以减少跨区域延迟或带宽限制。

对于高安全性场景,使用私有网络和受限访问的虚拟机运行迁移,配合严格的审计与访问控制。 总结来说,Core.BulkDocumentUploader 提供了一个易于理解的入门样例,展示了通过 REST API 将文件上传到 SharePoint 文档库的基本流程。要把样例用于生产环境,需要增强安全认证、实现分块与并发控制、配套完善的日志与重试机制,并考虑元数据映射与权限保留等迁移细节。通过采用现代的身份验证方式、分片上传策略、指数退避的限流处理和以任务队列为核心的工程化设计,可以将样例演化为稳定且可扩展的企业级批量上传解决方案。最终目标是在保证数据完整性与安全合规的前提下,实现高效、可监控和可恢复的批量文档迁移流程,从而为企业上云与内容管理提供可靠支撑。 。