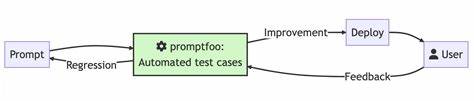

随着大语言模型(LLM)技术的广泛应用,如何确保提示(prompt)与其输出的可靠性和一致性成为业界关注的重点。PromptProof作为一款开源的GitHub动作工具,专门针对LLM提示输出进行测试,帮助开发者在持续集成与持续部署(CI/CD)流程中自动检测异常输出与格式违规,保障产品质量与用户体验。PromptProof最大的亮点在于无需调用网络接口,其测试基于已录制的模型响应数据(fixtures),实现零网络调用的高效测试环境。这不仅提升了测试速度,还避免了测试过程中的成本波动与不稳定性。用户只需在项目仓库中配置相应的promptproof.yaml文件,即可定义测试契约,包括JSON schema校验、正则表达式规则、成本预算限制等多样化校验标准。它支持丰富的检测类型,例如禁止个人信息暴露的正则校验、数值范围检测、字符串包含关系、列表或集合的相等性以及文件差异检测,满足不同项目的严格需求。

PromptProof的设计相当灵活,允许用户针对不同PR运行多轮测试,通过随机种子控制测试的确定性,降低"偶发性""冲突"带来的误报风险。并且,系统通过HTML、JUnit、JSON等多种格式的测试报告,呈现详细的校验结果,直观显示通过、失败的用例以及违例详情,让开发者快速定位并修复问题。同时,PromptProof能够自动在PR中发表评论,列出校验失败项的摘要,加快团队沟通效率。成本预算管控是PromptProof的一大优势,它监控每次测试的API调用预算消耗,设置上限值后,一旦超标即可阻断PR合并,防止超出预期的模型调用费用,有效实现成本控制。参数配置方面,用户可以灵活设定runs次数、预算上限、报告格式,甚至控制当测试通过后自动生成快照,方便后续回归对比。针对不同场景,还可选择'gate'(阻断)或'report-only'(仅警告)模式,满足不同团队对风险接受度的差异。

PromptProof支持Node.js环境,且配合GitHub Code Scanning能够生成SARIF格式报告,提升安全扫描与质量管理的深度和连续性。该项目以MIT协议开源,拥有详细的文档和示例工作流,方便开发者快速集成。此外,它适配矩阵策略测试,可针对多个提示场景或任务类型分别运行,确保多样化业务需求全覆盖。通过PromptProof,团队能够建立起完善的LLM使用质量保障体系,预防敏感信息泄露,杜绝格式混乱等常见问题,守护产品稳定和用户隐私安全。"零网络调用"特性意味着测试环境无需外部模型API密钥,适合严格的安全和合规需求。作为未来智能开发的重要辅助工具,PromptProof推动了LLM提示工程的标准化和自动化进程,提升人工智能项目的开发可靠性与成本效益。

展望未来,随着语言模型的迭代更新,PromptProof也将不断扩展适用的校验项和可配置性,进一步融合更多测试场景和智能分析能力,成为LLM开发不可或缺的利器。综上,PromptProof以其独特的设计理念和强大功能,成为GitHub社区关注的焦点,为面临LLM测试挑战的开发者带来了切实可行的解决方案。无论是初创团队还是大型企业,都能从中获益,实现高效、安全的模型提示测试,推动智能应用走向成熟。 。