随着人工智能技术的迅猛发展,尤其是大型语言模型(LLM)的广泛应用,人机交互的复杂性和规模也在不断扩大。如何高效、准确地在海量数据中对人机对话进行分类,成为提升智能服务体验和系统自我优化能力的关键。通过深入剖析微软研究团队的Semantic Telemetry项目,我们可以洞悉当前业界在大规模人机交互分类方面采取的技术策略及其创新之处。大型语言模型因其在自然语言理解与生成上的卓越能力,已成为现代人工智能系统的核心基础。然而,要实现对数以亿计的对话数据进行实时且精准的分类,仅依赖单一API远远不够,更需要一个具备高吞吐量与高性能的分布式架构,能够智能管理模型调用的并发性、请求复杂度以及远程模型接口的不可预测性。Semantic Telemetry管线便是在此背景下诞生。

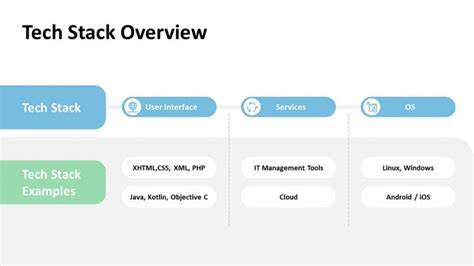

该管线不仅采用了ETL(抽取-转换-加载)结构的通用框架,更在计算框架与模型调用方式上进行了多项创新,帮助系统实现在不同环境及多模型间无缝切换。管线结合了PySpark的分布式计算优势与Polars的高效数据处理能力,实现了在大规模数据集和轻量级任务之间的灵活切换,极大提升了资源利用率和执行效率。管线的核心是一个针对多种大型语言模型端点的多阶段转换层,支持通用模型接口的同时,允许针对特定模型定制优化。通过基于Prompty语言规范设计的提示模板,确保了提示的一致性与可复用性。此外,管线配备了强大的输出解析及清洗机制,能够自动修正模型输出中的格式偏差与标签错误,保证了结构化数据的准确性。工程上,该项目面临着从远程模型端点延迟波动、并发限制到模型版本更新带来的连续迭代挑战。

尤其是远程托管的LLM端点,由于模型负载与网络环境的不确定性,响应时间经常出现大幅波动。为此,团队采用了多端点轮换策略,有效分散请求压力并动态调整负载。同时引入分段异步写出机制,确保即使发生网络故障也不会丢失数据。面对此类动态的服务质量,超时重试结合指数退避算法成为保障系统稳定性的关键。模型迭代更新常带来分类行为的细微变化,为防止性能倒退,开发团队构建了模型评估流程,通过采样测试与输出分布对比,系统地校准和优化提示模板。这一过程不仅允许对新模型性能的深入理解,也启发了灵活接受模型行为正向转变的新视角。

为应对突发的服务速率限制和响应延迟,管线内置了动态并发控制模块。该模块实时监控整个任务执行的成功率、失败率以及响应延时,自动调整并发调用数,从而平衡吞吐与稳定性。如此智能的反馈机制极大地提升了系统的适应能力。除了基础架构上的优化,项目还深入探索并行度提升与成本控制的多种技术路线。利用Azure OpenAI的批量端点,团队实现了大批量提示的离线处理,虽然牺牲了一定的响应时效,但显著降低了运营成本。对话批量合并技术通过一次调用分类多个对话文本,进一步提高了效率,配合引入的评分模型,保障了分类精度不因批量化操作而大幅下降。

多分类器集成于单一提示的做法,有效减少了重复输入对话内容的代价,在保证性能的同时减少了资源消耗。针对需要进一步提升处理速度与成本效益的场景,团队采用了基于文本嵌入的自定义神经网络分类器。通过先行采集一批对话的嵌入特征与对应分类结果,训练多层感知机等模型回归,能够通过单次嵌入调用实现多个分类任务的并行预测。此举虽增加了GPU计算资源需求,却在吞吐量和费用节省上表现突出。语言模型提示压缩与文本截断作为降低令牌数量和提升通量的手段,也被充分实验与应用。压缩后的提示模板减少了无效内容,缩写对模型提示输入有利,但需谨防压缩操作导致信息丢失,影响分类准确度。

对话内容截断限制了单次调用的令牌长度,有效避免了因超长文本带来的性能瓶颈,但须结合分类任务合理选择截断阈值,确保重要信息不被忽视。构建一个可支持多分类任务、易扩展且高弹性的语义遥测管线,也为研究人员和工程师提供了宝贵的经验与模板。其设计思想体现了对模型不可预测性的宽容度、对业务连续性的重视以及对成本效益的考量。随着未来大型语言模型性能持续提升和费用下降,人机交互的实时洞察将变得更加普及,更好地驱动产品的迭代与用户体验的优化。总的来看,Semantic Telemetry项目彰显了大规模人机交互分类在技术层面上的复杂挑战与解决路径。通过多层次的架构设计、动态的资源调配、创新的提示与训练方法,以及严谨的模型版本管理,该系统不仅突破了规模与性能的瓶颈,也为广泛应用AI增强型人机交互分析奠定了坚实基础。

在数字化转型及智能化升级的浪潮下,诸如此类技术方案将成为企业驾驭海量数据、精准把控用户需求及优化智能服务的利器。展望未来,随着多模态模型和更深层次理解能力的引入,基于大语言模型的交互分类技术将进一步扩展应用边界,推动人工智能向更加人性化、高效化的方向发展,为社会生产和日常生活带来更加丰富和智慧的交互体验。