随着人工智能技术的飞速发展,大型语言模型(LLM)已经成为引领科技创新的重要力量,尤其在软件工程领域展现了惊人的潜力。SWE-Bench作为衡量模型解决实际编程问题能力的重要测试集,近年来成为评估这些模型性能的关键工具。许多最新的LLM在SWE-Bench上的表现看似优异,令人对其解决复杂编程任务的能力充满期待。然而,近期一项名为《The SWE-Bench Illusion: When State-of-the-Art LLMs Remember Instead of Reason》的研究揭示,模型在这一基准上的高分表现背后,隐藏着"记忆"而非真正"推理"的问题。这一现象被称为"SWE-Bench幻象",对整个AI评估体系提出了严峻的挑战。 SWE-Bench最初设计之初,是为了模拟真实GitHub问题修复场景,旨在测试模型从问题描述到定位缺陷文件,再到生成修复代码的综合能力。

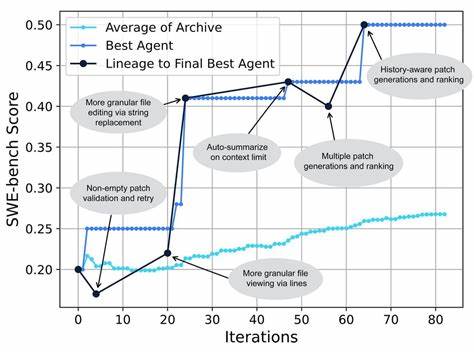

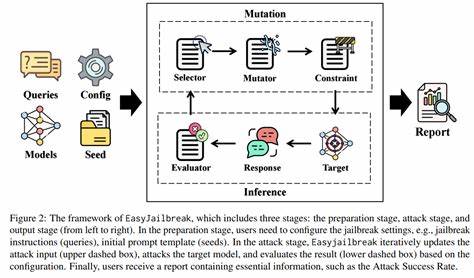

理论上,模型需要理解上下文、分析代码结构、并推理得出有效的解决方案。然而,该研究通过设计两项诊断任务:一是从仅有的issue描述中识别错误文件路径,二是在只有当前文件上下文和问题描述条件下的函数字符精确生成,证明当前顶尖模型的表现大量依赖于已见过的训练数据记忆,而非真正理解和推理。具体而言,模型能以高达76%的准确率从仅仅是问题描述中直接定位出错误文件路径,这在正常逻辑推理的情况下,缺乏对代码库结构信息的支撑应当难以实现。另一方面,当测试扩展到未被SWE-Bench收录的新代码库,准确率骤降至53%甚至更低,明显显示出数据覆盖范围的限制和模型的泛化能力不足。在函数字符的还原任务中,研究还发现模型在SWE-Bench中的连续五元语法字符的准确复现率远高于其他编码测试集,这种高度相似度非但无助于体现创新解决方案,反而暴露了模型对训练数据的机械重复。 这一发现揭露了当前主流评估方法的隐患:过度信任基准测试的分数,忽视了模型可能通过重复"记忆"训练样本而非真正"推理"的实际情况。

对于学界和工业界来说,这既是一场警钟,也是一种启示。模型看似惊艳的表现,在没有严格防止数据污染和重叠训练样本的前提下,难以真正证明模型能胜任复杂新颖的编程挑战。这不仅影响了模型性能的真实性评估,也影响了产品的实际可靠性和用户体验。 从更广泛的角度看,SWE-Bench幻象背后的问题体现了当今AI评估体系面临的普遍难题。数据泄露、训练集与测试集混淆以及模型对大规模数据的机械记忆能力,都使得评估结果难以反映真实能力。如何设计更健壮、抗污染的测试基准,成为推动LLM走向更高阶段的重要课题之一。

未来的研究应更多关注动态、实时更新的评测环境,注重差异化和泛化能力的检验,减少对单一任务依赖。 此外,SWE-Bench幻象的现象也呼吁业界对AI伦理和应用安全提出更高要求。当模型在未充分理解任务本质的基础上,凭借过往记忆生成代码时,存在潜在安全风险和不可控的错误。企业及开发者应谨慎使用LLM辅助编程工具,避免过度依赖其表面"智能",并结合人工审核与多重验证机制提升代码质量。 总的来说,SWE-Bench幻象的曝光不仅是对当前大型语言模型能力评估的一次深刻反思,更是推动行业进步的重要契机。认识到记忆与推理的本质区别,有助于科学设计训练数据和测试标准,推动LLM技术向真正具备思考与创新能力的方向发展。

只有不断强化模型的推理能力和泛化表现,我们才能期待在软件工程领域迎来更智能、更安全的AI助力时代。 。