随着人工智能(AI)技术的迅猛发展,大型语言模型(LLM)如GPT系列在文本生成、数据提取和自然语言交互等领域展现出惊人的能力。然而,当我们欣赏其强大表现的同时,也不得不面对一个关键问题 - - 虚假自信(False Confidence)。这不仅影响AI应用的准确性,也对高风险领域的应用部署构成了不小的隐患。虚假自信指的是模型在回答问题或者生成文本时表现出过度确定性,尽管其答案并非真正正确。理解虚假自信的起源及其后果,有助于更有效地利用AI工具,同时提出合理的验证手段确保结果的可靠性。大型语言模型的设计目标是根据输入内容生成最合适的输出,但它们本质上是概率模型。

模型并非真正"知道"事实真相,而是基于从海量文本中学习到的统计模式预测下一个最可能出现的词汇和句子排列。因此,当模型面对模糊、复杂甚至错误的输入时,它依然会自信地给出响应,而这些响应不一定是事实上的准确答案。这种情况导致的结果是生成所谓的"幻觉" - - 即虚假但看似合理的回答。虚假自信的核心挑战在于,模型并没有机制来判断自身输出的正误,仅凭概率分布进行推理。这种概率上的"确信"并不能等同于现实世界的"正确性",它更类似于统计上的预测确定性。换言之,模型可能高度肯定一个事实错误的答案,而对正确答案却显得犹豫不决。

面对这一现象,如何对模型输出进行有效验证成为关注焦点。传统上,验证信息真伪往往依赖于查阅权威资料或专业核对,但这在自动化和大规模应用场景下难以实现。因此,业界开始探索多种辅助方法来"校验"或给出输出的置信程度,这其中兼具启发性和实用性的策略包括多次自测一致性、跨模型交叉验证和基于概率分布的输出分析。自我一致性检验是一种通过多次调用同一模型、调整采样温度参数,观察输出结果重复性的方法。其核心思想是:如果模型在多次生成中给出一致答案,则该答案可能更可信;反之,答案波动较大则表明模型内部存在较高不确定性。然而,这种方法仍然仅是概率上的不确定度估计,不能百分百保证输出的事实正确性。

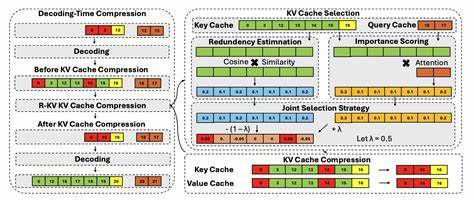

另一种有效手段是跨模型校验。利用不同厂商或不同结构的语言模型对同一问题进行回答比较,若结果高度一致,可以作为某种"共识"的信号。此类方法类似于机学习中的集成学习思想,通过多模型投票降低单一模型偏差带来的错误风险。尽管不同模型间可能存在相似的数据训练基础,但多样化的架构和参数调整仍然可以有效提高验证水平。此外,分析模型内部计算的log概率分布也是判断输出可靠性的一个角度。模型为每个生成的词语分配一个概率值,这些值反映了生成该词的相对"信心"。

通过观察整体序列的累积概率,可以大致推断模型对答案的内部置信程度。然而,由于softmax函数的指数特性,这些概率往往被放大,模型可能表现出对错误答案过度自信的现象,这就是所谓的"注意力陷阱",正在成为相关研究的热点。在现实应用中,单靠上述任一方法仍难以完全杜绝输出错误,因此近年来兴起了检索增强生成(Retrieval Augmented Generation, RAG)技术。RAG通过将模型生成与外部知识库相结合,实现生成文本的实时校对和语义对齐,极大提高了事实依据的准确性。通过比较生成内容与知识库文档间的语义距离(如使用余弦相似度测量向量间相似性),可以评估生成回答的"地面真相"相符程度。综合运用这些方法,构建多层次的验证框架成为现实可行的路径。

这种"真值代理评分"(Veracity Proxy Score, VPS)概念旨在通过弱相关但组合起来有效的指标,减少虚假自信的负面影响,为模型输出提供质量保证。需要强调的是,当前尚无完美的自动验证方案。所有方法无一能做到完全替代人工审核,尤其是在要求极高准确度的领域如医疗、金融及法律等高风险行业。此时引入"人机协同"的设计理念变得尤为关键,人工监督与机器推理相结合,不仅保障结果安全,也促进技术的不断完善。未来的发展有赖于更深入理解语言模型背后的神经机制,包括神经元层级激活模式和决策过程的透明化,帮助设计更具解释性和可控性的系统。另外,更丰富的外部知识整合、智能的验证算法及应用中的伦理规范同样不容忽视。

总的来说,虚假自信是当前大型语言模型局限性的一个重要体现,它提醒我们尽管AI技术极具潜力,但在实际应用中必须谨慎对待其输出。通过多维度、复合式的验证策略结合人为监督,可以有效降低因模型虚假自信而带来的风险,推动AI应用更加安全和可信。拥抱这一挑战,有助于实现AI技术从工具走向真正智能助理的转变,为社会带来更广泛而深远的福祉。 。