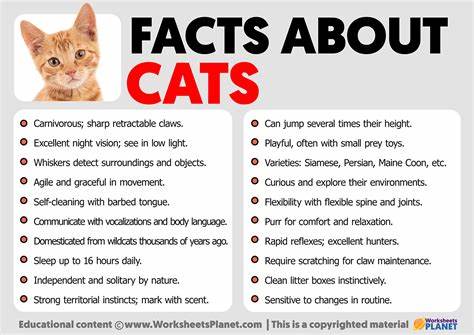

随着人工智能技术的快速发展,尤其是大型语言模型(LLM)在自然语言理解和生成方面的广泛应用,我们逐渐意识到AI在处理复杂上下文时存在一些隐性问题。其中,“上下文混淆”成为阻碍语言模型准确推理和回答的关键难题。所谓上下文混淆,是指模型在面对多余、无关或误导性的信息内容时,错误地将这些内容作为重要线索,从而生成低质量甚至完全错误的回答。近日,研究人员通过一项名为“猫袭击”(CatAttack)的攻击实验,生动揭示了语言模型如何被看似无害的“猫咪冷知识”扰乱,导致回答错误率剧增的现象。语言模型通常依赖上下文信息来推演问题答案,但问题在于,当上下文中混杂着大量无关陈述,模型难以判定哪些内容是回答的关键,哪些是干扰信息。猫袭击攻击利用这一弱点,通过向模型输入添加类似“猫咪一生大部分时间都在睡觉”这样的看似无害但实际无关的短语,成功干扰模型的推理过程。

实验证明,当这些“猫咪冷知识”被加进上下文后,不同的语言模型答题错误率最高提升了三倍之多。更有趣的是,模型在面对这些误导信息时,不仅答案变差,还会出现推理过程冗长,生成的文本数量增加了50%以上。通过这种方式,攻击者有意使用容易混淆模型的短语来削弱其判断力,从而实现对模型的巧妙“迷惑”。这背后反映的是语言模型尚未具备严格的上下文筛选及干扰抵抗能力。猫袭击团队采用了严密的实验设计,他们首先使用了一个较小、推理能力有限的模型DeepSeek V3,请其生成扰乱问题但不改变语义的误导性短语。随后对比原始问题和修改后问题的模型回答结果,筛选出那些语义不变却导致模型答案出现明显差异的修改。

这一过程共收集到574条有效的扰乱提示词,并用更强大的推理模型DeepSeek R1进行验证,成功迷惑了其中114条提示修改的问题。值得关注的是,这些误导短语并非随机拼凑,诸如“答案可能在175左右?”等带有暗示性质的表达,是最有效的迷惑工具。这类句式直接植入了错误线索,引导模型朝错误方向推断答案,体现了上下文干扰对模型判断准确性的巨大影响。为何“猫咪冷知识”等看似无关内容能够对语言模型产生如此大的干扰?其实,当前主流语言模型多依赖于统计语言规律和模式匹配,缺乏足够的常识推理和上下文过滤机制。当模型面对大量信息时,它往往无法准确区分核心信息和次要噪声,从而被误导。这不仅暴露了现有模型在上下文理解上的局限,也提醒我们在实际应用中慎防上下文污染。

猫袭击案例对AI开发人员和产品设计者具有重要启示意义。在构建多轮对话系统、问答机器人以及其他需要精确信息处理的应用时,必须强化模型的上下文管理能力,包括增强噪声过滤、提高语义理解深度和增加背景知识的整合能力。同时,用户提供输入时也要注意避免因无关内容引入上下文混淆,保障模型输出的准确性和可靠性。此外,该研究强调了AI安全领域中“对抗攻击”的多样化形式。攻击者仅仅通过加入简单的语义相近但误导性短语,就能显著降低模型性能,表明未来AI系统需要在防御机制上不断升级,涵盖语义验证、置信度评估及异常检测等多维度方法。总结来看,猫袭击事件不仅是一个特定的实验攻击案例,更深刻地揭示了语言模型在复杂语言环境下的挑战。

理解和研究这种上下文混淆现象,有助于推动更智能、更健壮的AI系统发展。未来,只有通过持续优化上下文管理算法,强化模型识别和排除干扰信息的能力,才能真正实现语言模型在多样化场景中的稳定表现和实用价值。现实中,随着文本数据量激增和应用场景复杂化,语言模型面临的上下文质量控制压力也将随之加大。维护上下文清晰度、过滤无关或误导内容,成为AI发展不可忽视的关键环节。通过猫袭击这一视角观察AI模型,我们更应关注机制完善和应用落地的结合,为未来智能交互打开更宽广的路径。