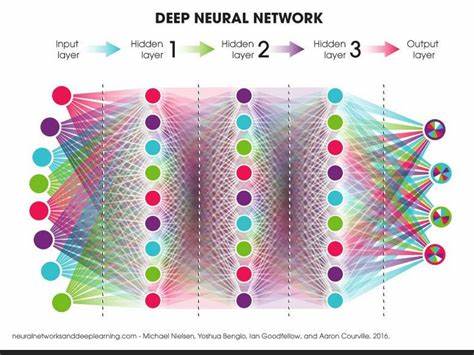

随着深度学习技术的不断进步,优化器在神经网络训练中的重要性日益凸显。优化器不仅影响模型的收敛速度,还对最终性能有着决定性的作用。近年来,学术界和工业界持续探索更高效、更稳定的优化算法以应对大规模复杂模型训练的挑战。在此背景下,SPlus作为一种基于“白化”距离度量的全新神经网络优化器应运而生,展现出强大的实用价值和显著的性能优势。SPlus的设计理念源自于Shampoo家族算法,但在其基础上通过引入稳定化技术和经验驱动的调整,实现了训练速度和稳定性的双重提升。本文将深入解读SPlus的核心机制,结合其在Transformer架构中的表现,帮助读者全面理解该优化器的独特优势及应用实践。

神经网络优化器发展史上,Adam因其自适应学习率和动量机制备受推崇,成为深度学习模型训练中的主流选择。然而,Adam在大规模参数空间中仍存在收敛速度较慢及超参数敏感等问题。Shampoo算法则尝试通过基于二阶信息的全局矩阵预处理,提高梯度更新的方向性和速度,但其计算复杂度高、数值稳定性不足成为阻碍推广的主要瓶颈。针对这些难题,SPlus提出了一种基于“白化”距离的梯度下降方法。所谓白化,是指通过特定矩阵变换,使数据中的相关性被消除,进而实现更加均衡和稳定的梯度调整。SPlus将这一思想用于优化步骤中,以一种新的距离度量代替传统的欧式距离,极大地提升了梯度更新的效率和稳定性。

除了核心的白化技术,SPlus还针对大规模训练过程中常见的数值不稳定问题,设计了多项关键稳定化措施。例如,通过适当的正则化策略和缓冲参数,避免了矩阵求逆和特征分解中的数值爆炸和精度损失,同时保持了较低的计算开销。这些技术措施确保了SPlus在实际训练中的鲁棒性和高效运行。从实证角度看,SPlus在多个主流任务中均表现优异。无论是在自然语言处理领域的语言模型训练,还是在图像处理中的分类任务,以及新兴的扩散模型生成领域,SPlus均能够以较少的梯度步数和更快的壁钟时间达到与Adam相当甚至更优的性能。特别是在标准Transformer结构上,SPlus通常仅需执行44%的梯度更新步数,而wall-clock时间仅为Adam的62%,显著提升了训练效率。

此外,SPlus的学习率策略也体现出其设计的先进性。相较于Adam,SPlus采用了不同的学习率尺度,推荐将Adam调优后的学习率乘以神经网络的隐藏层宽度的两倍作为初始学习率,或者直接尝试固定的学习率0.2,进一步简化了超参数调节工作。更重要的是,SPlus学习率策略在扩展网络规模时保持一致性,方便研发人员进行模型规模的无缝放大。为了方便开发者将SPlus快速集成至现有训练流水线,团队提供了适配JAX和PyTorch两大主流深度学习框架的单文件实现。开发者只需简单替换原有Adam优化器调用,加入相应的评估参数更新步骤,即可开始使用SPlus。同时,团队在GitHub项目中开源了丰富的实验代码,涵盖语言模型、扩散模型和图像分类任务,支持在TPU集群上复现论文结果,为研究者和工程师提供了宝贵的实战参考。

值得一提的是,SPlus鼓励用户在训练中采用基于EMA(指数移动平均)的模型参数用于评估,有效提高了模型的泛化能力和验证稳定性。这一机制区别于传统训练参数评估方式,是SPlus在设计中的一处创新。尽管SPlus在性能和稳定性上取得突破,但选择合适的学习率和批量大小依然是获得最佳训练效果的关键。开发团队建议在实际应用中进行充分的学习率搜索,并使用较大的批量大小(例如1024)以充分发挥优化器潜力。同时,比较不同优化器的性能时,应从多个训练检查点开始,而非仅从初始化状态,以确保评估的公平性和全面性。未来,随着神经网络规模和复杂性的不断增长,像SPlus这类兼具理论创新和实践效果的优化器将愈发重要。

它不仅为训练提供了稳定快速的解决方案,也为进一步融合二阶信息和数值稳定技术提供了实用范例。期待更多研究者和工程实践者能基于SPlus展开深入探索,推动深度学习模型优化进入新的高度。总结来看,SPlus以其基于白化距离的梯度更新方法及多项数值稳定化技术,成功缓解了传统优化算法中的瓶颈问题,实现了更快更稳定的神经网络训练。无论是语言模型、图像分类还是生成模型领域,SPlus均展现出卓越的通用性和先进性。它的出现不仅丰富了神经网络优化器的工具箱,也为实际深度学习开发流程带来了实质性的效率提升。对于从事大规模模型训练的研究者和工程师而言,了解并采用SPlus无疑是迈向高效模型迭代的重要一步。

。