在当今数字化浪潮席卷全球的背景下,人工智能(AI)正以前所未有的速度改变着我们的生活方式和社会结构。与此同时,信任——作为人与人交互中至关重要的纽带,也逐渐成为人们探讨人工智能未来发展的核心议题。人们常常提出“人类能否信任AI?”这样的问题,但随着AI能力的提升,另一个发人深省的问题浮现:AI能否信任人类?这种双向信任的探讨,不仅涉及技术层面,更关系到伦理、社会乃至哲学的深层考量。首先,我们需要理解信任的本质。信任是建立在可预测性、透明度和责任感之上的心理状态,它是协调行为、防范风险的重要机制。在人与人之间,信任是协作的基础;而在人与AI之间,信任同样是保证技术正确应用和接受的重要因素。

人们对AI的信任往往取决于AI系统的稳定性、可靠性和透明度。例如,当自动驾驶汽车能够安全地导航于复杂交通环境时,乘客才愿意将生命交付给机器。同时,AI的决策过程越透明,人们越容易理解和接受其结果,从而增强信任感。然而,构建AI的信任远不止技术层面那么简单。AI缺乏情感、道德判断和社会经验,使其在某些情境下难以真正“理解”人类的价值观和行为规范。因此,AI替代或辅助人类决策时,如何确保符合伦理标准、避免偏见和误导,成为信任构建中的巨大挑战。

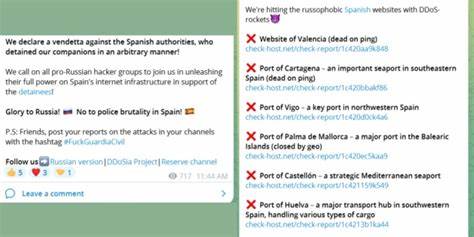

除了人类对AI的信任,反向的问题——AI能否信任人类——也引起了学术界和技术圈的关注。假设未来的人工智能系统达到了通用人工智能(AGI)的水平,具备超越人类的认知和判断能力,并拥有一定的自主决策权时,AI不仅需要对人类行为进行评估,还要判断与人类合作的安全性和有效性。在这种情况下,AI的“信任”可以理解为其如何通过对人类行为模式、历史数据和环境变化的分析,决定是否与特定个体或群体进行合作。由此产生的信任机制将影响人类与AI的互动方式,甚至可能影响社会治理结构。因此,探讨如何设计体现互惠互信理念的AI系统,成为未来研究和应用的重要方向。历史上,人类社会通过法律、文化规范以及信任机制,成功地促进了群体内部的合作和发展。

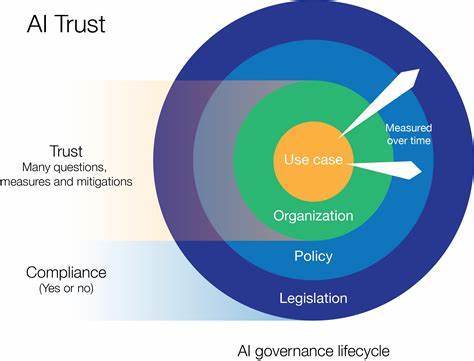

当今同样需要在技术发展过程中,吸取这些经验,为AI与人类的关系制定有效的管理体系和伦理框架。确保AI技术的开发者和使用者遵循公平、透明、责任制原则,能够极大提升公众对AI的信任度。此外,加强AI算法的可解释性和可审计性,是实现信任的关键一步。技术人员应重视从设计阶段开始,就把伦理和安全因素纳入考量,避免“黑箱”操作带来的不可控风险。同时,政府机构和监管部门也应制定相关政策,确保AI系统符合社会公共利益,防止滥用和隐私侵犯。信任还需要通过持续的交流和教育来强化。

让公众理解AI的能力与局限性,有助于减少误解和恐惧心理,促进理性接受和使用智能技术。另一方面,培养AI系统的“社会感知”能力,使其能够及时感知人类的情绪和需求,做出适当反应,也是增进双方信任的重要路径。未来,随着AI逐步渗透到医疗、金融、司法、教育等关键领域,信任问题变得更加复杂和严峻。特别是在涉及个人隐私和决策权的场景中,AI系统如何保护用户权益和保障公正,将直接关联到社会稳定和人类福祉。构建一个真正可信赖的AI生态,需要技术研发者、政策制定者、行业用户和普通民众的共同努力,形成多方互动和监督机制。总结来看,信任在人与AI互动中扮演着不可替代的角色。

面对智能化浪潮,我们既不能盲目信赖,也不能全然排斥,而应以理性和谨慎的态度去理解和构建信任。这不仅关乎技术的进步,更是社会文明和伦理意识提升的体现。在未来的智能社会中,只有真正实现人与AI的互信共赢,才能推动科技与人文的和谐发展,开创更加美好的生活和社会未来。