近年来,大型语言模型(LLM)因其强大的自然语言处理能力成为人工智能领域的研究热点。构建属于自己的LLM不仅能够加深对模型内部机制的理解,还能提升实践能力,推动相关技术的发展。如何从基础开始一步步搭建起完整的LLM系统,成为了许多AI开发者和研究者所关注的核心问题。本文将结合权威资源,详细介绍从零开始编写大型语言模型的完整课程内容,逐步讲解环境配置、数据处理、核心算法实现及模型训练等关键步骤,帮助读者系统掌握LLM构建的全过程。 首先,进行代码环境搭建是学习和开发LLM的第一步。高效的编程环境能够提供稳定的开发基础,避免不必要的技术障碍。

课程推荐使用Python作为主要编程语言,并采用uv工具便捷管理依赖项和运行环境。针对不同操作系统,尤其是Windows用户,课程中给出了相关依赖项的安装建议及替代方案。为了加载经典的GPT-2模型权重,作者特别将TensorFlow格式转换为更广泛使用的PyTorch格式,方便用户顺利完成模型初始化。接下来,文本数据处理是构建语言模型的核心环节之一。课程教授如何使用先进的分词技术,例如字节对编码(BPE),来高效压缩和表示文本数据。深入的文本预处理包括数据清洗、加载器设计以及批量处理策略,确保训练过程中数据的质量和流畅供应。

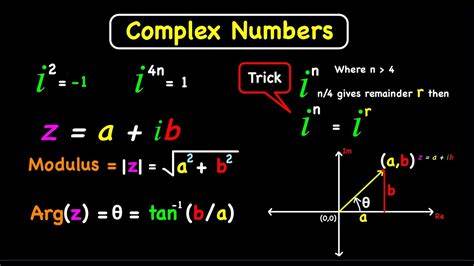

只有掌握了稳健的数据管道,才能为后续复杂模型的训练奠定坚实基础。 先进的注意力机制是大型语言模型的技术核心。课程重点讲解自注意力、因果注意力以及多头注意力的原理,并手把手教你从零编码实现这些机制。通过逐步构造注意力模块,读者不仅能理解注意力如何有效捕获上下文信息,还能直观感受到模型在处理文本序列时的动态权重分配过程。对比构建一辆赛车引擎的复杂性,将注意力机制比作LLM的“发动机”,使得学习过程更具形象性和趣味性。 完成基础架构后,课程引导学员开始模型的预训练阶段。

通过无监督学习的方法,模型不仅学习语言的结构,还掌握了基本的语义表达能力。作者详细讲述了如何使用海量未标注文本数据进行训练,如何设计损失函数,以及如何选择优化算法,确保模型能够快速收敛并获得优良的泛化性能。预训练阶段是LLM成功的关键一步,合理的训练策略直接决定最终模型的表现。 微调阶段则进一步提高了模型的实用价值。课程示范如何将预训练模型细化至实际任务中,如垃圾邮件分类等文本分类案例。通过小规模有标签数据的训练,模型能够更精准地适应具体应用场景。

接下来引导进行指令微调,使模型具备理解并执行复杂指令的能力。这一过程显著提升了模型在交互式对话和任务执行中的表现,增强其实用性和智能程度。 课程内容丰富且循序渐进,适合作为独立学习材料,也可作为配套资源辅助相关书籍理解。其设计理念结合了教学与实践,强调通过编写代码来深化理论理解。学习过程中既注重底层细节,又确保整体框架的完整,极大提升了学习体验和成果转化率。此外,课程还适时分享了从2018年GPT-2发布至2025年最新大型语言模型发展的趋势和变革,帮助学习者保持行业敏感度,扩展视野。

Sebastian Raschka教授凭借多年机器学习和AI教育经验,精心打造了这一系统课程。在他因伤病休养期间,将这些视频课程公开分享,为广大AI爱好者提供了宝贵学习资源。同时,课程伴随的GitHub开源代码和Hugging Face模型权重,为实践者提供了便捷工具,提高了学习效率和操作便利性。 总体而言,从零开始构建大型语言模型不仅具备较高的学习价值,还能激发开发者的创新潜能和技术热情。通过系统掌握环境搭建、文本预处理、注意力机制、模型预训练及微调等关键环节,读者将获得扎实的知识基础和实践经验。未来,随着人工智能技术的不断迭代与进步,掌握LLM底层构造方法将成为专业AI人才的重要竞争力。

建议对大型语言模型感兴趣的研究者和开发者积极参与相关课程学习,深入理解并亲手实现LLM,才能真正把握这一领域的前沿趋势和技术精髓。