随着人工智能技术的快速发展,AI模型的复杂度和性能不断提升,推理环节的算力需求也日益增长。然而,传统的AI推理经济模式却显得束缚重重,硬件利用率低下、价格不透明以及架构僵化等问题依然阻碍着行业的进步。为了解决这一核心痛点,Modular与SF Compute携手推出了大型批量推理API,并首次向前100位新客户免费发放千万级推理令牌,旨在通过创新技术和经济模式,彻底变革AI推理生态,助力更多企业和开发者释放潜能。传统AI推理市场长期以来面临严峻挑战,主要表现为固定定价策略和过度预留资源,导致高成本且资源浪费严重。特别是在大规模推理需求快速增长的背景下,如何在保证性能的前提下,实现成本的有效控制成为业界亟待解决的问题。Modular与SF Compute的合作以“破除僵化,重塑经济”为宗旨,结合实时的GPU现货市场和高效的推理软件栈,创造出全新的推理代币经济体系。

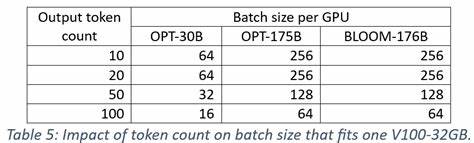

这一体系不仅大幅降低了推理成本,甚至达到了比现有市场价格低80%的惊人成效,为广大用户带来了实实在在的经济红利。新推出的大型批量推理API设计之初便聚焦于异步、高吞吐量推理场景,覆盖从数据标注、文本摘要到合成生成等多样化应用。该API支持超过20款前沿模型,涉及语言、视觉和多模态领域,模型体量从轻量高效的1B参数规模,到超大规模的600B+参数前沿系统,极大满足不同用户和场景对性能与成本的平衡需求。技术层面,SF Compute提供了数千台高性能GPU,包括NVIDIA H100、H200以及即将上线的AMD MI300/325X,通过实时现货市场实现动态定价,价格优势明显,比传统一到三年的预留价格还要低廉。Modular平台则利用其编译器原生执行能力和专为生成式AI优化的推理引擎,实现高达60%的吞吐量提升。两者强强联合,构建了一个高度融合、智能调度的推理生态系统,自动根据模型需求、带宽、延迟和价格变动等多维度因素,智能分配计算资源,达到硬件利用最大化与推理成本最小化的双重效果。

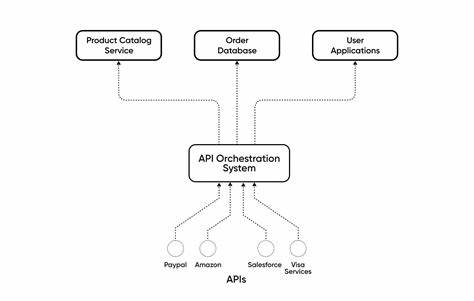

更为重要的是,这一系统打破了以往硬件与云服务的壁垒。通过统一抽象接口,用户无须关心背后的具体GPU厂商和型号,开发体验大幅提升。真正实现了硬件无差别化接入和云端多样化基础设施的无缝融合,赋能开发者专注于模型与应用创新。经济模式创新使得推理服务不再依赖于固定资源、长期合同和硬性预留,而是根据实时市场供应情况灵活调整,这摧毁了传统云厂商的锁定模式,激发市场活力,促进资源高效流通。对用户而言,这带来了更多选择、更优价格和更高自由度。当前推出的免费千万批量推理令牌专属计划,无疑为希望探索大规模推理的企业和开发者提供了一次宝贵的体验机会。

借助这一优惠,用户能够零门槛试水最先进的AI推理技术,发现其在成本控制和性能体现方面的显著优势,从而为后续的大规模部署和业务扩展奠定坚实基础。未来,Modular和SF Compute还将持续优化平台功能,支持长时在线推理、实现更丰富的模型兼容性和多集群协同调度,进一步挖掘算力效率潜力,推动AI推理基础设施的持续进化。对行业整体而言,这标志着AI推理领域一次范式转变,推动算力资源从稀缺高价向高效弹性服务转变,使更多创新应用能够触达更广泛的市场和用户。总结来看,Modular与SF Compute合作打造的免费批量推理令牌计划,不仅是一次技术与经济的革新,更是一次赋能产业生态的战略举措。通过开放前沿AI推理资源,打造统一、高效、经济的推理市场,他们正引领AI推理进入一个更加智能、高效且普惠的新纪元。对于关注AI推理效率与成本控制的企业和开发者而言,抓住这一机会,即可领先一步,享受最具竞争力的推理体验,提升自身技术实力和市场竞争力。

。