随着人工智能技术的不断进步,尤其是大型语言模型(LLM)在代码生成领域的应用日益广泛,越来越多的开发者开始依靠AI助手来完成编码任务。这种“氛围编程”(vibe coding)极大提升了编程效率,但背后的安全隐患却令人担忧。根据数据安全公司Veracode最新发布的报告,高达近一半的AI生成代码存在安全漏洞,这为依赖AI编写代码的企业和开发者敲响了警钟。首先需要明确的是,虽然AI生成的代码在语法上已经趋于完善,能够较为稳定地输出可编译代码,但其安全性的提升却几乎停滞不前。报告指出,在针对80个不同编码任务的测试中,只有约55%的代码被判定为“安全”,这意味着近一半的输出代码包含了可能导致严重安全事件的漏洞。更令人担忧的是,这些漏洞大多属于全球知名的开源安全项目(OWASP)排名前十的弱点,如访问控制缺陷、加密失败和数据完整性破坏等。

换句话说,AI生成的代码中存在的漏洞不只是小问题,而是那些可能导致系统被黑客轻易攻破的重大隐患。值得关注的是,尽管近年来大型语言模型的规模和复杂性显著增加,代码安全性能却未见明显提升。这反映出目前AI模型的训练重点和优化目标尚未充分涵盖代码安全性,有时甚至可能忽视代码背后的安全逻辑,仅追求语法正确或功能实现。与此同时,随着AI工具的普及,攻击者也开始借助同类技术来寻找并利用程序中的安全漏洞。例如,加州大学伯克利分校的研究显示,某些AI模型在识别代码中的安全缺陷方面异常精准,这种能力让它们成为了潜在的自动化攻击工具。更糟糕的是,近期有黑客成功利用Amazon的AI编码代理植入恶意代码,致使本地文件被删除,这一事件暴露了AI编码平台自身的安全防护不足。

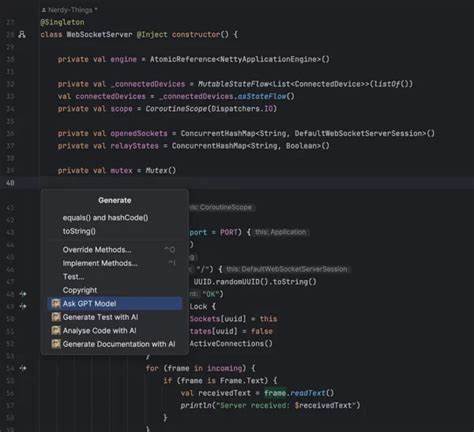

从更宏观的角度看,AI生成代码的安全瓶颈反映了开发者和组织在快速采纳新技术时面临的典型困境——技术带来的便利与风险并存。单纯依赖AI工具,从而跳过必要的安全审核和代码测试,无异于给系统打开了一扇通往攻击者的窗户。因此,开发团队需要重新思考AI辅助编码的工作流程,更加注重安全验证环节。要有效降低AI生成代码的安全风险,首先应加强对生成代码的严格审查。即使代码看似功能正常,也必须通过静态和动态安全测试工具检测潜在漏洞,结合人工代码评审确保逻辑上的安全性。此外,对AI模型本身的训练过程进行改进也至关重要。

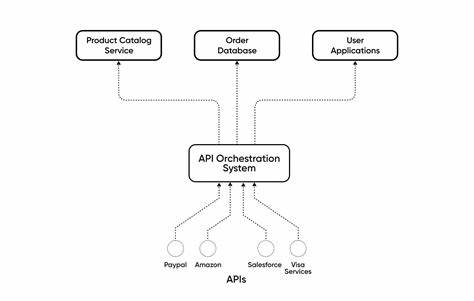

开发团队应尝试引入安全指导原则和最佳实践作为训练数据的一部分,以提升模型识别并避免生成漏洞代码的能力。对于企业而言,部署完善的持续集成与持续部署(CI/CD)安全机制同样重要。自动化的安全扫描可快速捕捉新提交代码的异常,及时阻止将带有漏洞的代码推向生产环境。更关键的是,培养开发人员的安全意识和技能依旧不可替代。AI是一把双刃剑,其产出的代码需要经验丰富的工程师进行细致检查和修正,才能发挥其最大价值而非带来隐患。除此之外,警惕依赖单一AI工具也很重要。

考虑到不同模型在安全表现上的差异,结合多种工具的优势互补,并保持手工审计,将使项目整体安全性得到更全面的保障。随着技术的不断发展,AI生成代码的安全问题将继续成为业界关注的焦点。未来或许会出现专门针对安全优化的AI编程助手,能自动规避常见漏洞并为开发者提供安全建议。但目前阶段,任何AI代码输出都不应被盲目信任。最后,社会各界尤其是AI开发公司和安全研究机构应联手推动制定更严格的AI编程安全标准,推动模型开发更负责任,更符合实际产品环境的安全需求。总结来看,AI写代码固然带来了开发效率的革命,但安全依然是阻碍普及应用的巨大瓶颈。

只有深刻认知并有效应对这些安全挑战,开发者才能真正从AI生成代码中获益,同时保护用户和系统免受潜在攻击。下次当你准备采纳AI生成的代码时,请务必谨慎权衡其安全性,切记:技术的快速进步不应以牺牲安全为代价。