近年来,人工智能技术的飞速发展极大地推动了人类社会的数字化进程,尤其是大型语言模型(LLM)的问世,使得机器能够在语言理解、文本生成等领域展现出惊人的能力。这类模型凭借其对海量数据的学习,能够以极具人类思维风格的方式生成内容。然而,正是这种技术的快速进步,也暴露出一项被广泛忽视却极为关键的问题——人工智能的可靠性危机。 所谓的可靠性危机,指的是生成式AI系统在实际输出中频繁出现事实错误、信息幻觉和无法验证的内容,这些问题严重影响了其作为工具的可信度和实用价值。例如,近期知名大型语言模型在为著名学者编写传记时,竟然错误地断言其死亡并引用了伪造的名人言论;又如AI生成的地图信息多次与现实数据不符,甚至连基本的地理分布都出现严重偏差。类似的情况使得用户不得不对AI生成的信息进行额外核实,降低了使用体验,也影响了公众对整个人工智能技术的信任度。

从根本上看,这种幻觉和错误的现象,与生成式AI的设计原理息息相关。大型语言模型并非基于传统的符号计算或确定性逻辑推理,而是通过对大量文本数据的统计学习,预测下一词出现的概率,从而生成语言输出。这种方法类似于“猜词游戏”,并不具备理解真实世界事实的能力,因此在面对不确定信息时,模型可能会“凭空编造”内容以保持语言流畅性和合理性。 此外,数据本身的质量问题也加剧了这一困境。训练数据往往来源于互联网,其中混杂有大量误导性信息、虚假新闻、讽刺笑话等非事实性内容。当模型在无意识地学习这些信息后,自然会在输出中反映这些错误,甚至放大它们的影响。

加上网络上恶意散布错误信息的现象日益严重,训练数据的净化和筛选工作成为了一项极其艰巨的任务。 更深入的技术挑战还体现在AI系统缺乏对“真理”的识别能力。人类在沟通时,能够结合多方面的知识和经验来判断信息的真实性,但当前的生成式AI缺少这一推理能力。它们既不会像人类一样主动去验证信息,也难以理解上下文中的讽刺或幽默,因而经常产生令人误解的输出。例如,AI模型可能会基于对“赞成吃石头”这一怪异短语的机械预测,而推荐人们每天摄入一小块岩石,这显然是对讽刺性新闻的误读。 这种本质上的“盲目性”导致生成式AI难以克服的可靠性局限,使得大量依赖其生成内容的场景面临风险,尤其是在医疗、法律、新闻报道等敏感领域。

内容的不准确不仅会误导用户,还可能带来严重的社会后果,甚至威胁到公共安全。因此,阻止虚假信息的传播和提高模型输出的事实性,成为当前人工智能研究领域的重要课题之一。 业界对此问题的反应不尽相同。部分技术领导者期望通过扩展模型规模、提升训练数据多样性和完善后续微调机制,逐步减少错误率,实现更可信的AI服务。然而,经验表明,单纯依赖“更大更强”的模型难以从根本上解决幻觉问题,因为其生成过程依然基于概率预测而非因果推理。另一条更具挑战性的路径是结合符号人工智能与深度学习的优势,即构建能够进行逻辑推理和知识验证的混合型AI系统。

混合系统的设计理念强调,AI需具备对事实和规则的显式理解和计算能力,这与目前大量依赖“黑箱”神经网络的生成式模型形成对比。通过引入符号推理模块和知识图谱,AI能够对信息进行多层核验,自动识别和纠正潜在错误。此外,随着对AI伦理和透明度的重视增强,开发团队越来越注重让机器具备解释自身决策过程的能力,从而为用户提供更具说服力和责任感的答案。 当然,要实现真正可靠且智能的AI,还需跨越技术、数据和伦理等多重难关。技术上,需要开发新的算法框架,提升AI的因果推断和常识推理能力。数据方面,不仅要强化训练数据的质量控制,更需建立有效的实时内容核查机制,避免被错误信息淹没。

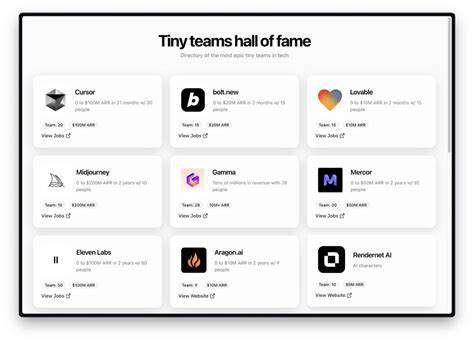

伦理和监管层面,应该明确AI生成内容的责任归属,保障用户权益,防范虚假信息带来的社会风险。 尽管挑战重重,人工智能的未来依旧充满希望。学界和产业界的不断努力正在推动技术向更可信赖、更智能的方向发展。诸如Robust.AI和Geometric.AI等创新公司正探索通过重构AI架构、引入符号推理和知识融合来解决幻觉问题。与此同时,公众对AI的预期也在逐渐理性化,认识到这些工具并非毫无瑕疵的全知权威,而是需要配合人类智慧共同工作的助手。 总之,人工智能的可靠性危机不仅揭示了当前生成式技术的局限,更提醒我们科技进步必须建立在对真理的追求和责任感之上。

只有从根本上重新设计和构建能够理解世界、校验信息的智能系统,才能真正实现AI赋能社会的巨大潜力,带来切实的生产力提升和社会进步。面对幻觉与错误的阴影,人类与机器的结合将成为未来智能时代最关键的课题之一。