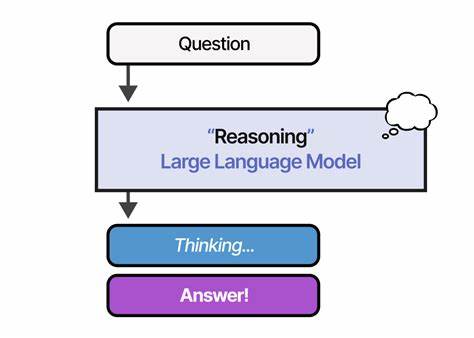

大型语言模型作为人工智能的重要分支,凭借其强大的语言理解与生成能力,正广泛应用于文本生成、问答系统、自动写作等多领域。然而,当前主流模型普遍采用"一次性回答"模式,面对涉及多个推理步骤或复杂逻辑的问题时,往往表现出不足。长远推理框架应运而生,旨在突破传统限制,促进模型能够进行多轮计划、执行、审查与综合,从而实现更精准且连贯的推理输出。长远推理框架的核心价值在于其结构化流程设计,通常包含问题分类、任务规划、执行节点、质量审核和综合生成多个环节。它通过将复杂问题拆解为若干子任务,形成有向无环图(DAG)结构来管理推理流程,确保各节点依赖关系合理且无循环依赖。这种设计不仅提高了推理的系统性,也为后续结果的审查和纠错提供了依据。

技术层面,长远推理框架一般基于灵活的后端服务搭建,如采用Python的FastAPI实现推理引擎,配合现代前端技术如Next.js构建用户交互界面,确保系统具备良好的扩展性与可访问性。此外,黑板系统作为核心调度机制,用于实现多步骤任务的协同处理,通过问答循环、评审机制、矛盾检测和记忆存储,实现动态调整及质量保障。通过引入并行执行与预算控制,长远推理框架不仅优化了计算资源的分配,还能有效降低响应延迟,提高丰富问答场景下的交互体验。值得注意的是,记忆模块在长期推理系统中扮演关键角色。通过维护嵌入表示、运行元数据和节点信念,系统能够在多次推理过程中积累经验和上下文,从而提升问答准确率和逻辑一致性。同时,利用轻量级存储和智能检索方法,克服传统记忆模块资源消耗大、检索效率低下的问题,兼顾实用与性能。

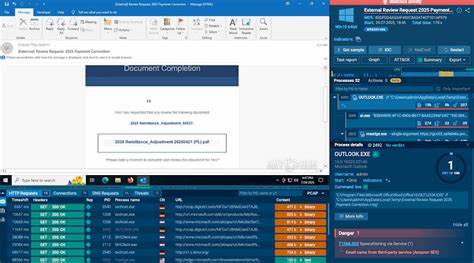

质量控制方面,长远推理框架设有多重评审机制,通过合同测试、节点质检和审稿人评估等手段,对每一步推理结果进行把关。更复杂的系统还引入了由多个评审者组成的判断团,通过加权反馈和迭代修正,最大程度减少语义歧义和事实错误。值得强调的是,长远推理框架中的自主适应机制令人瞩目。它采用一定的控制理论策略,如预算设置、风险对冲和故障回退策略,保障推理流程稳健运行。不仅如此,系统能够依据反馈动态调整控制参数,强化对复杂推理任务的不确定性应对能力,实现更智能的过程管控和资源优化。在评估与观测方面,框架提供细粒度的审计日志功能,采用结构化JSON格式记录推理路径和操作细节,为后期追溯与分析提供支持。

虽然目前缺少与主流监控平台的深度集成,但已具备多维数据采集潜力,有望推动运维管理和性能调优。对开发者而言,入门长远推理框架相对友好。项目通常提供丰富的部署脚本与依赖配置,如一键启动FastAPI服务、Express代理和前端页面,快速实现本地或分布式环境演示。同时,支持离线演示模式,满足基础探索与模型性能测试需求。就开源生态来看,长远推理项目活跃于GitHub,拥有清晰的模块划分和丰富的代码注释,便于研究人员在此基础上扩展功能、优化算法或集成更多评审机制。此外,项目文档详尽介绍架构设计理念、API接口及使用示例,为社区贡献和二次开发奠定基础。

当然,现有长远推理框架仍面临诸多挑战。首先,整体编排的顶层入口尚未完善,部分流程需要手动拼接,限制了易用性和自动化水平。其次,最终输出的统一合成模块尚未成形,影响整体语义连贯性和格式统一。再者,内部部分深度的错误处理和重试策略尚显薄弱,面对模型调用异常缺少充分的补偿措施。多样化的质量评审体系有待丰富,目前仅涵盖结构和一致性评估,缺乏针对事实准确性的专门判断器。除此之外,安全与并发控制方面存在潜在风险,如并发写入文件引发的资源锁竞争,输入清洗与恶意内容防护依旧不够全面。

长远推理框架是大型语言模型智能演进的重要里程碑,为未来实现更复杂、更具上下文理解能力的人工智能系统提供了技术支持和思路启发。随着算法优化、硬件性能提升及社区力量壮大,相信此类框架将在自然语言理解、医学诊断辅助、法律文本分析以及科研自动化等领域发挥更大价值。总体而言,长远推理框架突破了传统LLM单步回答模式的限制,为多步骤推理和动态调整提供了坚实的架构基础。它通过模块化设计、黑板式任务协调和智能反馈机制,实现了更可靠和高效的推理流程。尽管目前仍有不足,但这为未来智能应用场景中复杂问题的解决奠定了坚实基础,展现出广阔的发展前景。未来,随着更多评审机制的加入、更完善的错误恢复策略、以及更智能的控制算法,长远推理框架有望成为支撑高级人工智能决策和创造力的中枢,推动人机交互进入一个全新的时代。

。