随着人工智能技术的迅猛发展,函数调用作为AI系统与外部环境交互的关键环节,越来越受到关注。理解AI函数调用的底层机制,不仅有助于优化模型性能,还能提升应用的响应速度和用户体验。本文将深入探讨AI函数调用的工作原理,揭开其背后的技术细节,帮助读者全面掌握这一重要环节的核心要素。 AI函数调用本质上是模型与预定义功能之间的信息传递过程。与传统编程语言中函数调用的概念类似,AI函数调用允许模型根据输入内容自动调用某个特定的功能模块,从而实现特定任务。不同于静态的编程函数调用,AI函数调用强调动态推理和上下文理解,它依托于自然语言处理和深度学习模型,实现更灵活、更智能的交互。

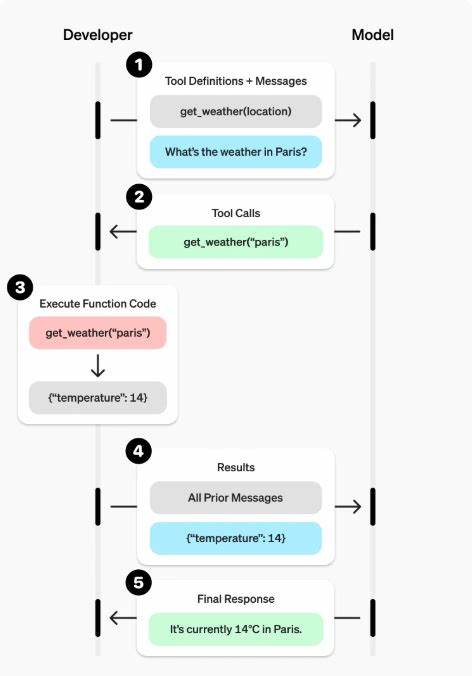

在底层架构中,AI函数调用通常包括几个关键步骤。首先,模型接收用户的请求,并通过内部分析模块识别出请求中潜在的功能需求。此过程涉及复杂的语义理解和意图识别,依赖于强大的语言模型来准确捕捉输入信息的含义。接下来,模型将与之匹配的函数参数整理完毕,生成用于函数执行的结构化数据。 随后,这些参数会被传递至对应的函数执行层,该层负责实际功能的运算和逻辑处理。这里的函数可能包括调用第三方API、执行数据库查询、进行数学计算或控制智能设备等。

完成调用后,函数返回结果,再通过AI模型进行结果整合和自然语言输出,从而生成对用户友好的回应。 技术实现上,AI函数调用离不开几种关键技术的融合。首先是自然语言理解(NLU),它使模型能够理解和解析自然语言输入,提取出有意义的指令和数据。其次是上下文管理,通过维护对话状态和历史信息,模型可以更准确地决定何时以及如何调用对应函数。最后,函数调用接口设计决定了模型与功能模块间的数据交互效率,良好的接口设计保障了调用的稳定性和兼容性。 赋能AI函数调用的另一个重要方面是模型训练和微调。

通过提供大量涵盖各种场景和指令的数据,模型不断优化其意图识别和参数生成能力。迁移学习和强化学习技术的应用,进一步增强了模型在复杂环境下的推理与决策能力,使其更灵活地处理多样化的函数调用请求。 性能优化方面,函数调用的延迟和准确率是核心指标。降低调用延迟有助于提升用户体验,但需要在保证计算资源合理利用的前提下实现。准确率的提升则直接关系到功能执行结果的可靠性,通过细致的错误检测和纠正机制,可以显著减少误调用和执行失败的情况。 随着AI应用场景的不断扩展,函数调用机制也在持续演进。

更加智能的调用决策算法、更丰富的函数库及更完善的接口标准正逐渐形成。未来,AI函数调用有望实现更加无缝和自然的人机交互,推动智能助手、自动化任务处理、智慧城市管理等多领域的发展。 此外,安全性与隐私保护在AI函数调用设计中同样尤为重要。合理的权限管理和调用审计机制保障了数据和功能调用的安全,防止滥用和攻击。隐私保护技术的引入,确保用户敏感信息在调用过程中得到妥善处理,符合相关法规和伦理标准。 总而言之,AI函数调用作为连接智能模型与实际功能执行的桥梁,担负着使命关键的角色。

通过深入理解其背后的技术细节和架构设计,可以开发出更智能、更高效、更安全的AI应用。未来,不断完善的函数调用机制将成为推动人工智能技术普及和革新的重要动力,引领技术与生活的深度融合。