在现代分布式系统中,限流已经从可选的保护措施变成了必不可少的基础设施。许多团队在面对突发流量、恶意请求或多租户隔离时都会控速,但实施自定义限流常常伴随着复杂性、性能权衡和运维痛点。基于这样的背景,我构建了一套服务,目标是让自定义限流变得简单、可观测并且无缝集成到现有架构中。下面分享设计思路、实现细节和落地经验,帮助你评估、复用或改进自己的限流方案。首先要明确为什么需要自定义限流。通用的网关或第三方限流只能提供粗粒度的保护,无法满足不同客户、不同接口或不同场景的差异化策略。

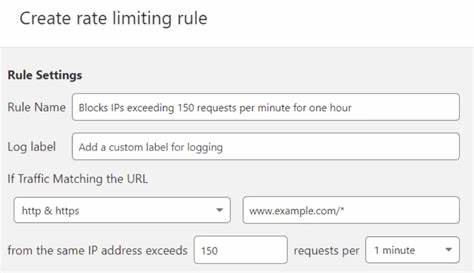

按用户、按租户、按API路径或按地域设定不同的速率,是保护关键资源和优化用户体验的常见需求。自定义限流还能配合业务指标做动态调整,例如根据错误率或后端队列长度自动收紧限流阈值,从而避免雪崩效应。在算法选择上,我并没有把所有情况都塞入一种方案,而是根据场景使用不同算法的组合。令牌桶适合支持突发流量和均衡处理,漏桶和固定窗口适合实现简单配额,滑动窗口或基于时间分段的滑动窗口更适合保证时间粒度内的平滑性。实际工程中,令牌桶用于允许突发短峰值,滑动窗口用于统计和限制稳定速率,固定窗口用于实现日配额或小时配额。设计时确保接口可以声明所需算法类型,以及相关参数如桶容量、填充速率、窗口大小和配额周期。

关于数据存储与一致性,限流的核心是计数和原子更新。分布式系统中最常见的做法是使用Redis作为核心存储,利用Redis的原子命令或Lua脚本实现单条请求的原子检查与更新。为降低延迟,关键路径尽量减少网络往返和复杂计算,将判断逻辑放到Redis脚本或附近的缓存节点。对于超低延迟需求,也可以在局部使用内存缓存配合定期同步,以降低对集中式存储的依赖,但需要处理一致性失真导致的漏限或误限风险。高可用性是另一项关键考量。限流服务本身既是保护对象也可能成为瓶颈。

为避免单点故障,我采取了分层架构,控制平面负责配置下发和策略计算,数据平面负责在请求路径上做快速判断。数据平面节点尽量无状态或只保持短期状态,使得横向扩容变得容易。控制平面使用持久化存储记录策略配置和审计日志,并支持灰度发布和回滚。为了应对Redis或中心组件的短暂不可用,设计了降级策略:当中心存储不可用时,服务可以按预设宽松或保守模式切换,确保不会因为判断路径失败导致全局不可用。性能设计方面,关键是减少每个请求的额外开销。我把限流判断拆分为快速路径和慢速路径。

绝大多数请求走快速路径,只做最小化的校验,例如从本地内存或近端缓存读取配额数据并快速判断;当匹配复杂规则或缓存未命中时再进入慢速路径,向Redis或控制平面查询并返回结果。为支持高并发,还实现了批量更新和合并请求机制,把多个计数更新合并为一次原子操作,从而减少对后端的写放大效应。策略表达与管理至关重要。为了让业务团队能够灵活配置限流规则,我设计了一套简单而可组合的策略DSL,支持按维度组合限流条件、多条件优先级和分层继承。通过控制台或API可以定义租户级、服务级和接口级策略,策略优先级和覆盖规则清晰可见。对于复杂场景,例如按API方法与用户角色组合限流,策略引擎支持动态解析并在下发到数据平面前进行静态验证,避免配置错误导致的大范围误判。

可观测性是运维体验的核心。限流动作必须被记录并与监控、告警结合。每次拒绝、降级以及回退都要产生可聚合的指标,例如拒绝率、命中率、延迟影响和错误类型。我集成了时间序列数据库和日志系统,提供仪表盘展示限流命中趋势、最频繁被限流的租户或API、以及限流规则的历史变更。基于这些数据可以实现自动化策略调整,配合简单的机器学习模型或规则引擎做预警,例如当拒绝率突然上升且后端错误率同步上升时,自动放宽部分限流阈值以保护整体可用性。安全与防护方面,需要防范滥用和伪造标识。

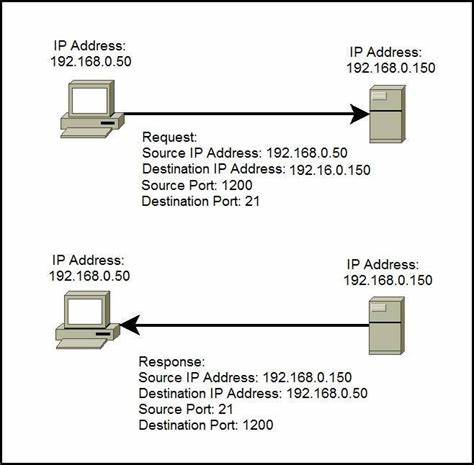

限流通常以API Key、用户ID、IP或租户作为维度,但身份信息可能被伪造或绕过。为了增强可靠性,限流服务通常与鉴权模块协同工作,优先使用经过认证的标识作为主键,对于匿名或不可信的标识采用IP或者连接-level的防护策略。此外,对于发现的DDoS或异常攻击,系统要能快速切换到更严格的策略并通知安全团队做进一步处置。易用性和集成方式也很重要。为了方便各类客户端接入,我提供了多种接入方案,包括API拦截器、网关插件和语言SDK。拦截器可以在服务端请求进入时直接调用限流判断接口,返回详细的限流剩余量和重试时间信息,便于客户端实现退避策略。

网关插件则能把限流放在边缘,减少后端负担。SDK则提供本地缓存策略,使得在短时间内能在客户端本地做决策,降低网络延迟对体验的影响。测试和灰度策略必须早期介入。限流策略一旦上线,往往会触及到真实用户体验,因此通过小流量灰度、自动回滚和预先模拟压力是必要操作。我们在上线前会用流量回放工具在预生产环境做压力测试,检查规则覆盖、冲突以及对后端延迟的影响。灰度上线时,优先对内部用户或非关键流量开放新策略,收集指标并调整策略参数后再放量。

运维成本与计费考虑也不可忽视。为避免因限流服务本身产生高额成本,采用分层计费与配额管理可以让不同客户按需付费并限制资源滥用。审计日志与配额消耗记录是计费的基础,同时可以作为违规检测和追溯依据。为了提高成本可控性,关键路径的存储尽量使用高效的内存型数据库,非关键日志和审计数据可以异步下沉到对象存储或冷数据仓库。在实际部署中会遇到一些常见陷阱。第一个陷阱是过度复杂的规则带来的维护成本。

太多细粒度规则会导致策略冲突、覆盖关系难以理解以及频繁回归。另一个陷阱是过度依赖单一存储,当Redis成为瓶颈时整个系统会出现可用性下降。为避免这些问题,需要在设计上引入限速器自身的自我保护措施和可观测性补偿策略。最后,过分追求严格一致性会影响延迟和吞吐,通常在限流场景下可以接受最终一致性,只要拒绝或允许的误差在可接受范围内。分享几个落地经验,帮助团队做决策。优先把限流作为平台能力而非单个服务内自行实现,这样能保证策略的一致性和审计能力。

把复杂判断逻辑尽量移动到可扩展的控制平面,而把快速、原子判断放在靠近请求路径的数据平面。采用分层降级策略来应对中心依赖不可用的风险。监控策略不仅要关注拒绝率,还要观察与后端错误率、请求延迟和容量使用率之间的联动,以便做动态调整。最后,投入自动化测试和流量回放工具,能显著降低上线策略带来的风险。总结一下,构建一个让自定义限流不再痛苦的服务,不只是实现几条规则那么简单,而是要在算法选择、存储架构、性能优化、可观测性与运维流程之间找到平衡。通过分层设计、混合限流算法、原子化操作、策略管理界面与完善的监控告警,可以让工程团队在保护系统安全与稳定的同时,保持业务的灵活性和用户体验。

限流是系统健康的重要守护者,做好它能在突发流量与攻击中为你的服务赢得宝贵的时间与稳定性。 。