近年来,随着人工智能技术的发展,基于大型语言模型(LLM)的应用迅速兴起,成为各行业创新和数字化转型的核心驱动力。无论是智能聊天机器人、自动内容生成还是复杂的自然语言理解系统,LLM都扮演着不可替代的角色。与此同时,开发者面临的挑战也日益凸显,尤其是在调试和优化过程中,由于许多框架和库封装了对外部API的调用细节,使得请求的真实数据难以被观察和分析。这促使越来越多的开发者选择在本地搭建代理工具,来精细化追踪LLM应用的HTTP请求与响应,为调试和维护带来极大便利。 使用代理的首要优势在于能够揭开抽象层背后的真实通信细节。虽然诸如LangChain等框架极大地简化了与不同LLM服务提供商的对接流程,只需少量代码改动即可切换服务,但它们同时隐藏了实际发起的HTTP请求内容,令开发者难以全面了解请求的头信息、数据负载及返回结果。

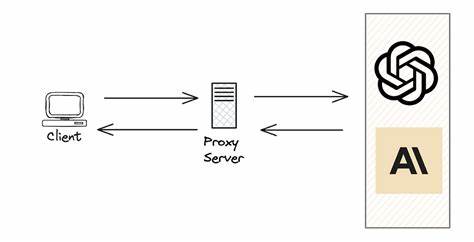

通过配置本地代理,如mitmproxy,开发者可以实时查看每一条请求和响应,连同所有相关的HTTP头和原始数据,这些信息对于排查问题、性能优化和兼容性调试极为宝贵。 代理工具的原理简单易懂:作为客户端和服务器之间的“中间人”,代理接收由应用程序发出的请求,转发至目标服务器,同时捕获并返回响应。在HTTPS环境下,虽然TLS加密机制防止了信息的中间人攻击,但通过安装并信任代理生成的自签名CA证书,客户端能够接受代理仿造的证书,从而实现全程解密和记录HTTPS请求。需要注意的是,这一操作涉及安全考量,仅建议在本地开发和测试环境中进行,避免在生产环境中使用。 以mitmproxy为例,它不仅支持命令行和图形化界面,还提供强大的脚本扩展能力,能根据需求对流量进行定制处理和展示。开发者可以轻松捕获每一次调用的详细数据,甚至将LLM对话内容自动提取并在代理界面进行高亮,极大提升调试效率。

此外,mitmproxy还能集成在Docker容器内,便于在多环境中保持一致的调试体验。 HTTPS协议的调试难点在于其严格的证书验证机制。代理工具通过生成自定义CA,迫使客户端信任代理作为合法证书颁发方,使得所有经过代理的请求均被解密和记录。实际操作中,需要开发者将代理CA证书添加到操作系统或开发环境中的信任列表。对于使用Python请求库如httpx的场景,可以通过向certifi库的证书捆绑包追加代理CA证书,使得请求过程不会因证书验证失败而中断。这样的配置确保了足够贴近真实环境的同时,获得对请求内容的完整掌控。

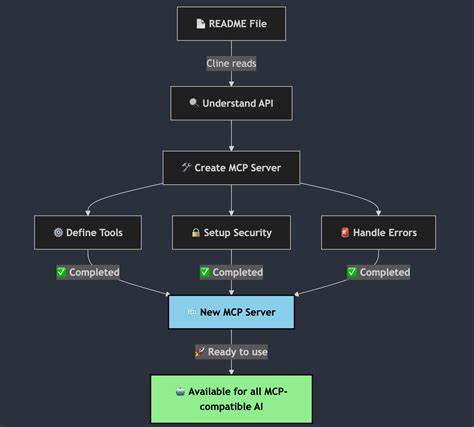

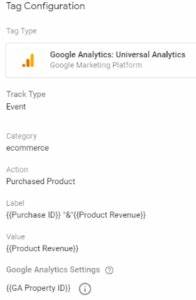

值得注意的是,现代LLM SDK和框架通常封装了请求客户端的构建,开发者无法直接传入代理参数。但大多数HTTP客户端遵循环境变量设置,诸如HTTP_PROXY和HTTPS_PROXY变量,可以全局指定请求所经过的代理服务。这使得无论是直接调用OpenAI SDK还是通过LangChain等高级框架,配置好代理环境变量即可实现流量捕获,无需修改应用源码。 在实际开发中,通过代理观察不同API模式和版本间请求数据的差异也大有裨益。以OpenAI的传统Completions接口和新推出的Responses接口为例,两者在请求JSON结构、字段命名和数据流方式上存在明显差异,启用代理能帮助开发者一目了然地掌握这些变化,并据此优化调用逻辑和业务流程。更进一步,如果开启流式输出,代理能够在界面分节显示服务器发送的Server-Sent Events(SSE),为流式处理的调试提供便利。

针对基于LangChain的复合型应用,更可借助代理深入理解框架内部的调用链路。复杂的多工具组合往往涉及多次API调用,代理能够分别捕获工具调用请求和后续将工具结果传递给模型的请求,直观展现链条式处理的细节,助力开发者掌握复杂业务逻辑。 代理也适用于处理特殊场景的自定义证书。例如在访问Amazon EKS Kubernetes API时,由于其使用专有CA,开发者需将对应CA证书同时注入应用与代理环境,确保请求能够正常通行。此外管理代理的SSL缓存,保证安全证书更新后即时生效,也是保证测试环境稳定的关键措施。 结合容器化技术,代理环境能够作为独立微服务部署,支持多用户多项目同时运行。

通过Docker容器启动的mitmproxy,不仅简化了环境搭建,还能与Web应用端口映射结合,直接在本地看到LLM应用的请求轨迹,极大提升开发体验和效率。不过须注意,出于安全考量,此类配置绝不可直接运维至生产环境,须严格限制访问权限。 总结来看,代理不仅是调试大型语言模型调用不可或缺的利器,更是深入理解各类LLM API内部机制的钥匙。开发者通过代理获得对网络请求和响应的透明视野,能够更灵活地应对接口变更和错误排查,有效缩短开发周期。同时,随着AI生态的不断进化,代理工具的灵活扩展性和脚本能力也日益关键,为未来多样化场景下的LLM应用开发奠定坚实基础。选择并配置合适的本地代理,已成为每一个需要打磨高质量LLM产品的开发者的必备技能。

通过不断探索和实践,开发者不仅能够驾驭当下的AI技术,更能构建起适应未来变革的稳健开发体系。