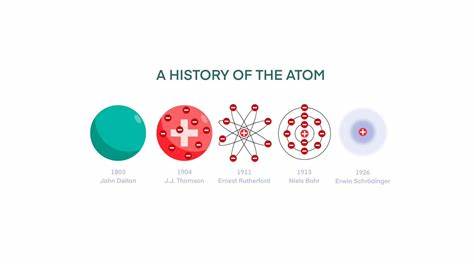

随着人工智能技术的迅猛发展,模型规模不断扩大成为推动性能提升的重要手段。在这场规模与性能的竞赛中,大型原子模型(Large Atomic Model)作为代表性技术成果,其最新检查点数据突破了10GB大关,标志着模型复杂度和计算能力迈入了一个全新的阶段。大型原子模型的检查点文件是保存训练过程中模型参数的关键文件,数据大小直接反映了模型规模和参数数量。突破10G的检查点意味着模型包含了数十亿甚至上百亿的参数,能够更有效地捕捉数据中的细微模式和语义复杂性。大型原子模型的成功历程充满技术创新与艰辛,一方面是硬件性能的大幅提升,包括更快的GPU和更高效的存储设备,另一方面则是分布式训练算法的发展使得如此庞大的模型得以在合理的时间内完成训练。高达10G以上的检查点文件不仅要求存储设备具备高速读写能力,同时也对模型推理和微调阶段提出了更高的系统需求。

此类规模的模型在自然语言处理、计算机视觉、推荐系统等多个领域展现出卓越的性能。在自然语言理解和生成方面,大型原子模型能够理解更为复杂的语境,实现更人性化和自然的对话体验,其在机器翻译、文本摘要、内容生成等任务中同样表现出优异的能力。计算机视觉领域中,模型的巨大参数量使得更加细致的图像特征被捕获,提升了目标检测、图像分割和风格迁移等多种任务的准确率和应用范围。推荐系统则通过对用户行为和兴趣的深入学习,实现个性化推荐的精度和多样性。而大型原子模型超大规模的检查点也带来了诸多挑战。模型参数庞大极大地增加了存储成本和传输负担,在模型更新和部署时需要强大的计算资源支持。

此外,模型训练过程中的能耗和碳排放问题也引发了广泛讨论,如何在追求性能极限的同时兼顾环境可持续发展,成为业界亟待解决的重要议题。为应对诸多技术瓶颈,研究人员积极探索模型压缩、知识蒸馏、参数共享等多种策略,力求在保持优势的同时减少存储和计算负担。隐私保护与安全性也是大型模型迈向广泛应用必须考虑的问题,数据合规性、模型可解释性和对抗攻击防御成为热点研究方向。面向未来,大型原子模型的应用前景极为广阔。随着检查点容量继续攀升,人工智能系统将具备更强大的自主学习能力和更贴合人类认知的智能表现。在智能医疗领域,这些模型能够辅助医生进行更精准的诊断和个性化治疗;在自动驾驶和机器人技术中,提升环境感知和决策判断的效率和可靠性;在金融风控与市场预测中,也将带来更深层次的数据洞察和风险管理能力。

此外,结合5G与云计算技术,大型模型的实时在线推理将变得更加可行,为智能城市、智慧教育等领域注入动力。值得注意的是,大型模型的生态建设同样重要。开放性的数据集、共享训练框架以及跨领域的技术交流将促进更多创新成果的诞生。企业与学术界的合作紧密联合,推动大型模型技术从实验室走向实际应用,真正实现人工智能价值的最大化。总结来看,大型原子模型检查点容量突破10G,是人工智能技术发展中的重要里程碑,体现了规模化与智能化的深度融合。面对模型参数急剧增长所带来的技术挑战,行业各方积极探索创新途径,共同推动高效、环保、安全的大型智能模型实现广泛应用。

未来,随着算法优化和硬件升级的持续加速,大型原子模型将在更多领域发挥关键作用,成为智能社会建设不可或缺的技术基石。