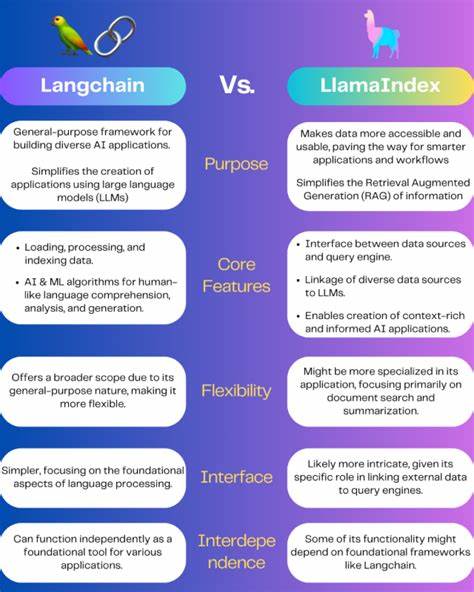

随着人工智能技术的不断进步,尤其是大型语言模型(LLM)的广泛应用,开发者在构建智能应用时面临着越来越复杂的挑战。如何合理管理模型调用流程、提升模型运行效率以及实时监控和调试,成为了关键问题。LangChain和Langfuse作为业界备受关注的两大工具,在促进LLM应用高效开发和运维方面表现突出。本文将深入探讨LangChain与Langfuse的核心差异、各自优势以及它们在实际应用开发中的角色和协同方式,帮助开发者更好地理解和选择适合自身需求的技术路径。 LangChain:构建复杂LLM工作流的强大框架 将LangChain比作一座建筑的电路系统并不为过,它主要负责将不同的语言模型、提示(prompts)、链(chains)和代理(agents)连接起来,构建起完整且有序的工作流。它类似于前端开发中React对DOM的作用,作为核心框架,确保数据流和控制流顺畅传递,保障系统整体的协同运行。

LangChain最具特色的部分之一是其Runnable接口,这一设计理念让用户能够将复杂的任务拆解成多个独立的、输入输出明确的小模块。例如,从向量数据库中检索相关文档、调用聊天模型生成响应,都可以作为单一任务独立实现。通过组合这些模块,用户能够灵活搭建多步骤的流程,同时各个部分方便独立调试和优化。 此外,LangChain还拥有强大的检索器(retrievers)功能。它支持内置检索器,并允许用户根据具体数据源定制检索器,从而为大语言模型提供精准的上下文支持。这对于实现基于检索增强生成(RAG)等高级应用场景尤为关键。

LangChain的模块化和灵活性使其极具扩展性。用户可以轻松替换底层模型、数据库或其他组件,而无需重写整个系统逻辑,这不仅提升了系统的维护性,也为未来迭代升级打下坚实的基础。随着应用规模和需求的增长,开发者能够方便地添加新模块、新检索器,保持工作流的高效运行。 Langfuse:专注于大型语言模型应用的可观察性和调试 与LangChain不同,Langfuse主要聚焦于监控、调试和持续改进LLM应用。它不是用来构建模型调用流程,而是为已经搭建好的系统提供透明的运维能力。 在实际应用中,LLM的生成过程可能会出现幻觉(hallucinations)、错误或意外行为。

Langfuse的优势在于能够详细跟踪每一次模型调用的输入、输出、令牌使用情况、成本和性能表现,甚至允许团队成员对模型响应进行注释,极大提升问题定位和优化效率。 通过集中化的仪表盘,Langfuse让开发者能够实时观察所有交互数据,深入分析模型的行为模式。它还支持自动化评估工具,可以将用户交互转化为结构化数据,从而为模型调优和版本迭代提供科学依据。对于需要管理大量提示的团队,Langfuse的提示管理功能也提供了便捷的平台,帮助集中维护和优化提示设计。 结合使用LangChain与Langfuse:构建与观察的完美协奏 尽管LangChain和Langfuse的功能侧重点不同,但它们并非竞争关系,而是可以协同发挥各自优势。对于正在构建或计划构建复杂多步骤LLM应用的团队,采用LangChain作为工作流构建框架,辅以Langfuse进行监控与调试,是当前非常理想的选择。

如果项目已经有既定的LLM架构,且不便于进行重构,单独引入Langfuse以增强观察和调试能力也是明智之举。开发者可以将模型调用数据导入Langfuse,利用它强大的追踪功能,快速定位问题和发现潜在优化点。 另外,对于坚持LangChain生态的用户,LangSmith作为另外一款观察和调试平台,是Langfuse的替代方案,为用户提供了更多选择。 未来展望与应用实践 随着模型的不断迭代和AI应用场景的日益丰富,模型的管理与优化变得尤为重要。LangChain为应用的构建带来了模块化与灵活性,而Langfuse则保障了应用过程的透明度和可控性。它们的结合为开发者提供了一个综合的解决方案,使得构建高质量、稳定且高效的LLM应用成为可能。

开发者在实际应用时,应根据自身项目的复杂度、对监控的需求以及现有技术架构,灵活选择这两款工具中的一种或两者结合使用。通过合理利用LangChain的工作流管理能力和Langfuse的观察调试功能,能够大幅提升开发效率,减少调试时间,最终为用户交付更加智能、稳定的产品体验。 总结来看,掌握LangChain和Langfuse的核心优势,结合项目需求制定合理的集成策略,将是LLM应用开发团队在激烈竞争中脱颖而出的关键。只有选择并善用合适的工具,才能避免因复杂性和隐蔽问题造成的效率损失,最大化大型语言模型的潜力,推动人工智能技术在各行业的深度落地。