随着全球数字化转型的加速,边缘计算逐渐成为连接物理世界与数字智能的桥梁。传统大型AI模型往往需要大量的计算资源和网络带宽,无法直接部署于资源受限的边缘设备,这成为阻碍智能应用快速落地的重要瓶颈。面对这一挑战,Phi-4-mini-reasoning凭借其3.8亿参数的轻量化设计,打造出了既具备强大数学和逻辑推理能力,又适合部署在边缘终端的创新解决方案。Phi-4-mini-reasoning不仅继承了Phi-4家族强大的推理基础,更结合了行业专项数据的细致微调,推动了智能推理向着专业化与场景化的方向迈进。 边缘设备如物联网终端、笔记本电脑、智能手机等,受限于计算能力、电池寿命和存储容量,传统深度学习模型难以直接部署并实时推理。为了解决模型复杂度与推理效率的矛盾,模型量化技术成为关键一环。

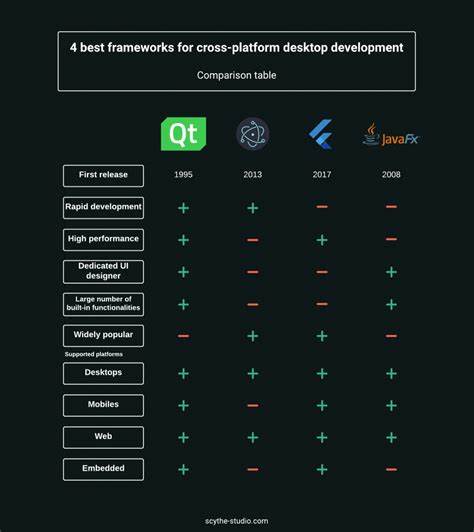

Microsoft Olive和Apple MLX Framework作为领先的AI模型优化工具,通过将高精度的浮点模型量化为低比特宽度的整数模型,大幅度降低算力需求和模型体积,实现了模型的便捷迁移和边缘部署。量化虽不可避免地引入一定程度的精度损失,但配合微调和推理优化,能在保持模型推理能力的同时优化计算效率,为工程师们带来了极具吸引力的方案。 以医疗场景为例,Phi-4-mini-reasoning经过基于Chain-of-Thought(CoT)数据的细致微调,能够深入解析复杂症状与诊断逻辑,为临床诊断提供辅助支持。通过利用公开的医疗推理数据集对模型进行针对性训练,Phi-4-mini-reasoning不仅提升了对医学领域逻辑关系的理解力,也强化了其在现实病案推理任务中的适用性。对边缘设备而言,这意味着医护人员可以在缺乏云端连接的偏远地区,依然享受高效、可靠的智能辅助诊疗服务。 微调过程在Azure ML平台上得以高效实现,借助强大的云端GPU资源和Microsoft Olive的自动优化,开发者能够灵活调整训练策略,快速迭代出契合特定行业需求的专属版本。

微调后的模型经过转换成ONNX格式,确保跨平台的推理兼容性和部署便利性。在本地端,采用onnxruntime-genai框架运行推理,能够最大限度发挥量化模型的性能优势,实现流畅的交互式应用。 Apple MLX Framework则为MacOS和Apple Silicon设备提供了本地量化及微调能力,满足那些倾向于在私有环境中处理敏感数据的用户需求。该框架支持便捷的数据集加载、格式化和训练命令行操作,降低了非专业人员应用高性能语言模型的门槛。 从数学推理的题目求解到复杂医疗诊断,Phi-4-mini-reasoning的表现都极具亮点。其结合了底层强大的逻辑推理引擎以及领域特定的知识微调,呈现出良好的泛化和定制能力。

以学校宿舍分配问题为例,模型能够准确推断出学生数量与宿舍总数,展现了对数字约束条件的深刻理解。而在医疗案例中,针对带有细节描述和命题复杂度的问诊信息,模型同样能够依据临床知识逻辑给出合理的诊断推测。 当前工业界对边缘AI的发展需求尤为迫切,Phi-4-mini-reasoning在此背景下的突破意义非凡。它不仅显著降低了推理模型在计算资源上的门槛,还通过定制化微调确保模型能够匹配行业复杂多变的实际场景。借助微软Azure AI Foundry模型目录的开放访问,开发者可以快速获取并部署量化后的Phi-4-mini-reasoning,极大缩短从研究到落地的周期。同时,丰富的文档和示例Notebook为入门与进阶使用提供了便捷支持。

展望未来,随着更多行业标注数据的积累与不断完善的微调技术,Phi-4-mini-reasoning有望支持涵盖制造、金融、零售、智能交通等多领域的专属推理任务。结合边缘设备的实时响应能力,将推动智能应用体驗升级,实现更深层次的人机协同。Microsoft Olive和Apple MLX的协同优化策略,也将继续推动部署效率和推理精度的均衡提升。 总体而言,Phi-4-mini-reasoning通过轻量化设计、行业微调及先进量化技术的集成,为边缘智能推理提供了强有力的解决方案。它有效缓解了传统大型模型在边缘场景中的部署难题,同时赋予模型更多的行业适应性和细分能力。对于智能设备制造商、行业解决方案开发者及技术研究者而言,深入掌握并应用这一新型推理框架,意味着抓住了未来AI边缘化趋势中的关键机遇。

在当前数字经济时代,数据智能的边缘化处理将成为提升效率、保障隐私和降低成本的重要方向。Phi-4-mini-reasoning凭借其强大的数学逻辑推理基础,并通过行业数据的精准调优,成功将先进的人工智能推理运用推向了边缘计算新高度。未来,依托更加完善的硬件软硬件协同优化和丰富多样的行业知识注入,Phi-4-mini-reasoning有望成为边缘智能领域的核心引擎,加速智能应用普及与行业数字化转型,推动人工智能持续赋能全球社会经济的发展。